与Physical Intelligence同日发声:深度机智亮出「情境数采」杀手锏,具身智能的通用性天花板要被捅破了?

文章摘要

【关 键 词】 具身智能、数据荒漠、第一视角、情境数采、通用智能

具身智能领域正面临一个关键挑战:“数据荒漠”问题严重阻碍了通用性突破。当前,尽管模型在模拟环境中表现优异,但在现实复杂场景中却频繁失败,这引发了行业对数据质量的深刻反思。深度机智提出的解决方案聚焦于以人类第一视角为代表的真实情境数据采集,试图从根本上解决这一难题。

传统数据采集方法存在明显局限性。合成数据和离线遥操作虽然提供了初步训练素材,但存在场景单一、任务真实性不足等问题,导致模型容易过拟合。机器人往往只是机械记忆特定轨迹,而无法掌握背后的操作逻辑。深度机智倡导的“情境数采”模式突破了这一瓶颈,强调数据应包含丰富的环境语境和因果关系,而非孤立的动作片段。

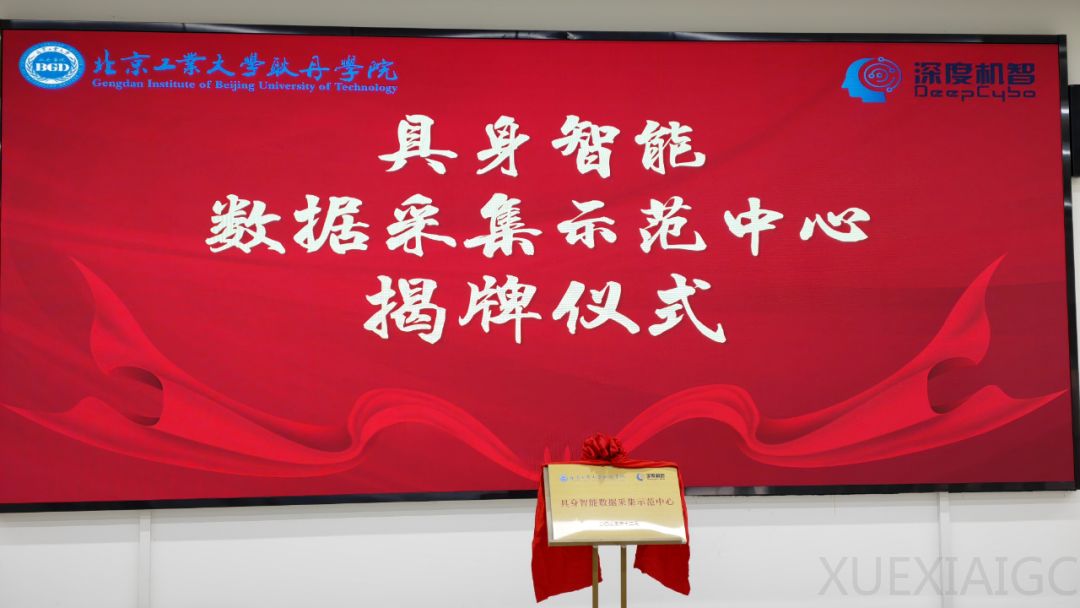

2025年12月,深度机智与北京高校合作成立的“具身智能数据采集示范中心”标志着这一理念的落地实践。该中心采用以第一视角为主、多视角辅助的多模态数据采集方式,构建标准化采集体系。其核心技术突破在于DeepAct数据引擎,该引擎实现了多维感知融合和场景记忆植入,使每一帧数据都携带环境背景和交互逻辑信息。例如,抓取烧杯的动作数据不仅记录坐标变化,还包括光照条件、桌面材质等环境细节。

这种新型数据采集范式带来了显著的技术优势。实验结果表明,基于大规模精细标注的第一视角人类经验数据,可以有效增强基座模型的物理智能,并实现向异构执行器的高效迁移。这一发现与Physical Intelligence的最新研究相互印证,共同验证了“人类经验数据驱动通用智能”的可行性。

深度机智作为中关村两院孵化的高科技企业,已经基本完成了人类数据驱动通用智能的技术全链路验证。目前,该公司正在全国范围内大规模采集真实情境数据,持续扩大数据规模。这一系列举措表明,当带有场景记忆的多模态数据积累到一定程度,配合全链路处理和模型创新,具身智能的通用性突破将指日可待。未来,机器人有望摆脱机械模仿的局限,在情境数采的支持下实现真正的技能涌现,迈向通用物理智能的新时代。

原文和模型

【原文链接】 阅读原文 [ 1246字 | 5分钟 ]

【原文作者】 机器之心

【摘要模型】 deepseek/deepseek-v3-0324

【摘要评分】 ★★★☆☆