文章摘要

【关 键 词】 开源模型、多模态AI、世界模型、视频生成、图像编辑

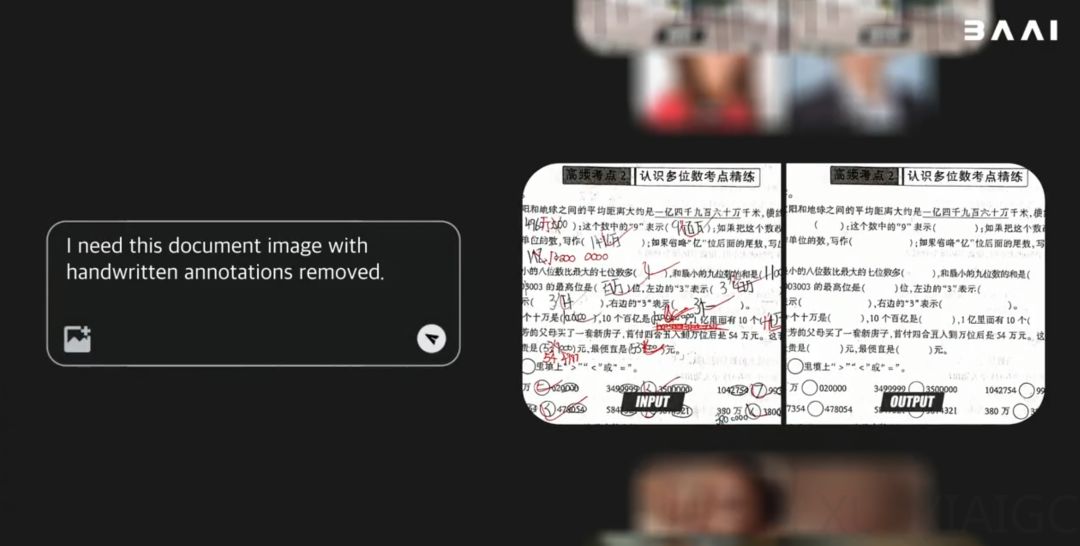

北京智源人工智能研究院最新发布的悟界·Emu3.5标志着开源原生多模态世界模型的重大突破。该模型以34B参数量实现图、文、视频任务的统一处理,其核心突破在于模拟动态物理世界的因果逻辑能力,而非仅追求视觉逼真度。通过第一人称视角漫游3D场景、动态消除手写痕迹等案例,展现出对空间一致性和长时序演变的深度理解。

作为世界模型基座,Emu3.5通过下一状态预测(Next-State Prediction)框架统一各类任务,在10万亿Token的多模态数据(含连续视频帧与文本)上预训练。关键技术突破包括:基于IBQ框架的视觉分词器支持2K分辨率重建,离散扩散适配技术(DiDA)实现20倍推理加速,以及多阶段强化学习对齐系统。这些创新使其在文本渲染、多模态交错生成等任务上超越Gemini-2.5-Flash-Image等标杆模型。

模型展现出两大核心能力:世界探索与具身操作可完成”整理桌面”等分步骤物理任务;视觉指导与复杂编辑能根据草图生成3D打印全流程,或制作分步教学指南。其独特优势在于保持长时序创作的主体一致性,例如将狐狸草图逐步转化为手办时精准保留核心特征,避免风格漂移。

智源研究院宣布将这一突破性模型全面开源,为开发者提供具备物理常识的基础设施。技术报告显示,Emu3.5的潜力不仅限于内容生成,更可能推动具身智能、虚拟现实等领域的范式变革。目前科研内测版已开放申请,其实际表现将验证世界模型在复杂场景中的应用边界。

原文和模型

【原文链接】 阅读原文 [ 1684字 | 7分钟 ]

【原文作者】 量子位

【摘要模型】 deepseek/deepseek-v3-0324

【摘要评分】 ★★☆☆☆

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...