世界首个「实时、无限」扩散视频生成模型,Karpathy投资站台

文章摘要

Decart公司发布了全球首个实时、无时长限制且支持任意视频流的扩散视频模型MirageLSD,标志着AI视频生成领域的革命性突破。该模型能够在40毫秒的延迟内将任何视频流转化为用户想要的任何世界,无论是相机、视频聊天、电脑屏幕还是游戏画面。这一技术不仅实现了实时智能调整画面风格和内容,还能通过文本提示进行任意控制,解锁了全新的应用可能性。

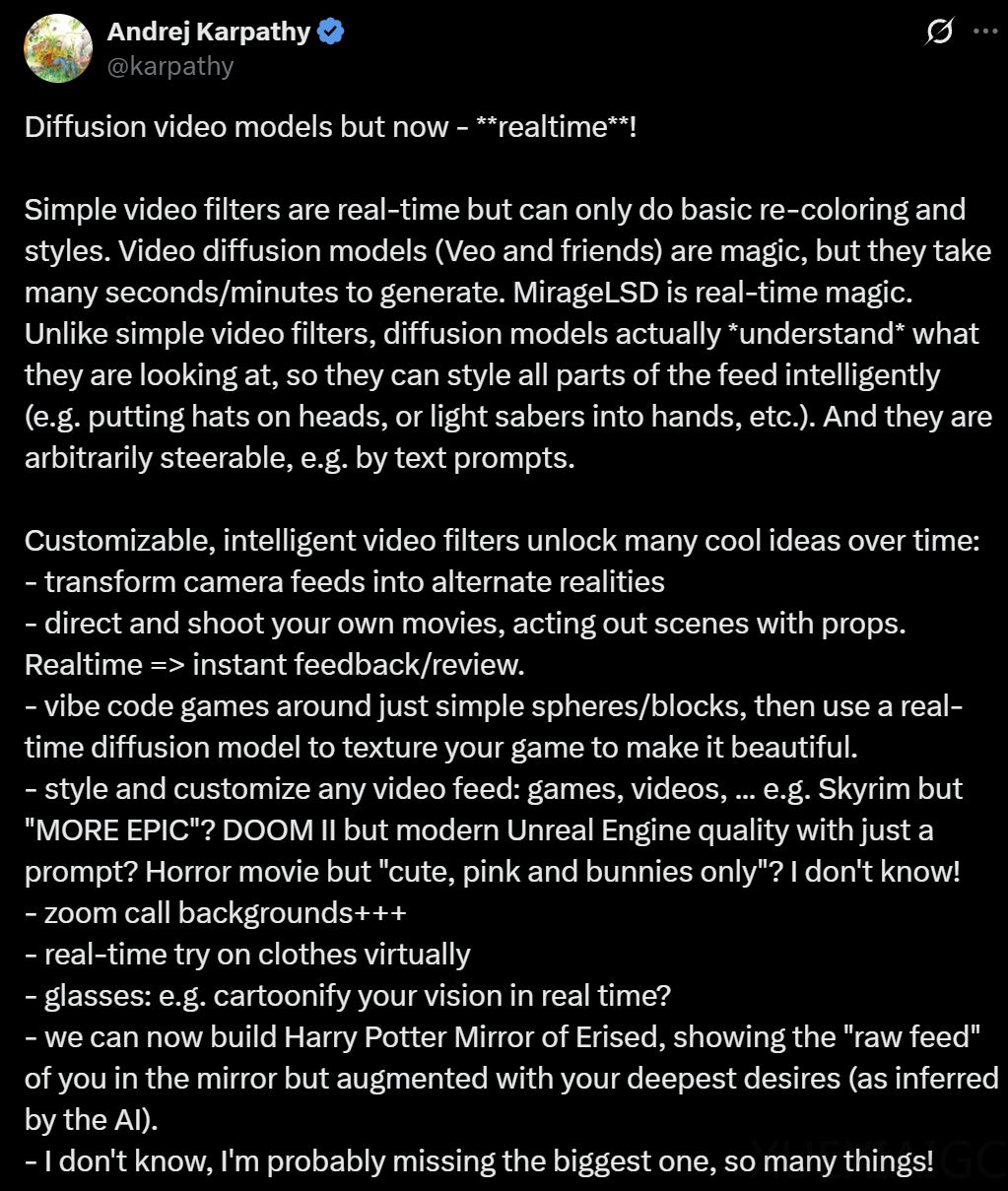

前特斯拉AI总监、OpenAI创始团队成员Andrej Karpathy对这一技术展开了广泛想象,包括将摄像头画面变为“另一个世界”、自导自演实时电影、游戏开发轻松起步、任意视频流的风格迁移、视频会议背景和实时虚拟试衣、AR眼镜升级以及哈利波特的“厄里斯魔镜”等。Karpathy已成为该项目的天使投资人,认为这项技术通用且强大,真正的“杀手级应用”尚未被发现,该领域值得无限想象。

MirageLSD的技术原理主要在视频生成的时长和延迟两大角度产生了突破。基于定制的实时流扩散(Live Stream Diffusion,LSD)模型,该模型能够逐帧生成并保持时间连贯性,成为第一个能够生成无限长视频的视频生成模型。通过Diffusion Forcing技术和历史增强方法,LSD实现了无限自回归生成,稳定、可提示,并始终与场景和用户输入保持一致。

在响应速度方面,MirageLSD相较于以往模型提升了16倍,实现了以24帧/秒的速率实时生成视频。通过设计定制的CUDA mega kernels、基于shortcut distillation和模型剪枝技术以及优化模型架构,MirageLSD实现了每帧生成时间控制在40毫秒以内,避免了被人眼察觉的延迟。

扩散模型通过一系列逐步去噪操作,将随机噪声逐渐还原为图像或视频。LSD采用了不同的方法,一次生成一帧,使用因果性的自回归结构,每一帧都依赖于此前生成的帧以及用户提示,支持即时反馈、零延迟交互,并且可以持续生成视频,无需预先设定终点。这种因果反馈机制使LSD能够保持时间上的一致性,持续适应画面中的动作与内容变化,并在实时遵循用户提示的同时,生成无限长度的视频序列。

尽管MirageLSD在技术上取得了显著突破,但仍存在一些技术缺陷和改进方向。当前系统依赖于有限的历史帧窗口,引入更长期的记忆机制有望提升长序列中的连贯性。此外,尽管支持基于文本的风格变换,但对于特定物体、空间区域或动作的精细控制仍较为有限。若能整合关键点或场景标注等结构化控制信号,将有助于在实时环境中实现更细粒度、用户可控的编辑操作。在语义一致性和几何稳定性方面,特别是在面对极端风格变换时,仍需进一步优化。MirageLSD在极端风格变化下,可能会出现物体结构或布局被扭曲的情况。

Decart公司将持续发布模型升级和新功能,包括面部一致性、语音控制和精确物体操控等。与此同时,平台还将上线一系列新特性,如流媒体支持、游戏集成、视频通话等功能。MirageLSD的发布不仅展示了AI视频生成技术的巨大潜力,也为未来的应用场景提供了无限可能。

原文和模型

【原文链接】 阅读原文 [ 2002字 | 9分钟 ]

【原文作者】 机器之心

【摘要模型】 deepseek-v3

【摘要评分】 ★★★★★