中英双语、29项第一、像素级理解:360 FG-CLIP2登顶全球最强图文跨模态模型

文章摘要

【关 键 词】 AI视觉、多模态模型、细粒度理解、开源技术、语义对齐

当前AI生成的视觉内容虽然炫酷,但在细节理解和空间关系处理上仍存在明显缺陷。例如,要求生成「穿红外套的猫站在蓝色跑车左边」或搜索「引擎盖有鸟粪的特斯拉」时,主流模型的表现不尽如人意。360公司最新发布的FG-CLIP 2模型通过像素级分析能力,显著提升了细粒度视觉理解水平,在29项国际基准测试中全面超越Google、Meta等竞争对手,成为当前最强的图文跨模态模型。

FG-CLIP 2的核心突破在于其显微镜级的细节识别能力。传统CLIP模型只能识别图像中的主体和基础动作,而FG-CLIP 2不仅能准确理解「狸花猫与屏幕里的英短猫对视」这样的复杂场景,还能通过毛发纹理区分品种。这种能力源于两方面的创新:一是构建了包含5亿中文图文对的FineHARD数据集,每条数据均配备短文本概括和150词左右的细节描述;二是引入开放世界目标检测机制,为4000万个图像区域生成独立标注,使模型学会从局部理解全局。

训练策略上,模型采用两阶段进阶学习:先建立全局语义认知,再聚焦局部特征对齐。配合五维协同优化体系(全局对齐、细粒度视觉/文本、跨模态排序、文本对比学习),模型在复杂场景下的准确率显著提升。测试显示,面对「户外机器人带领老人做操」的图片,FG-CLIP 2能准确描述场景,而MetaCLIP 2误判为「室内」,SigLIP 2则错误识别为「跳舞」。

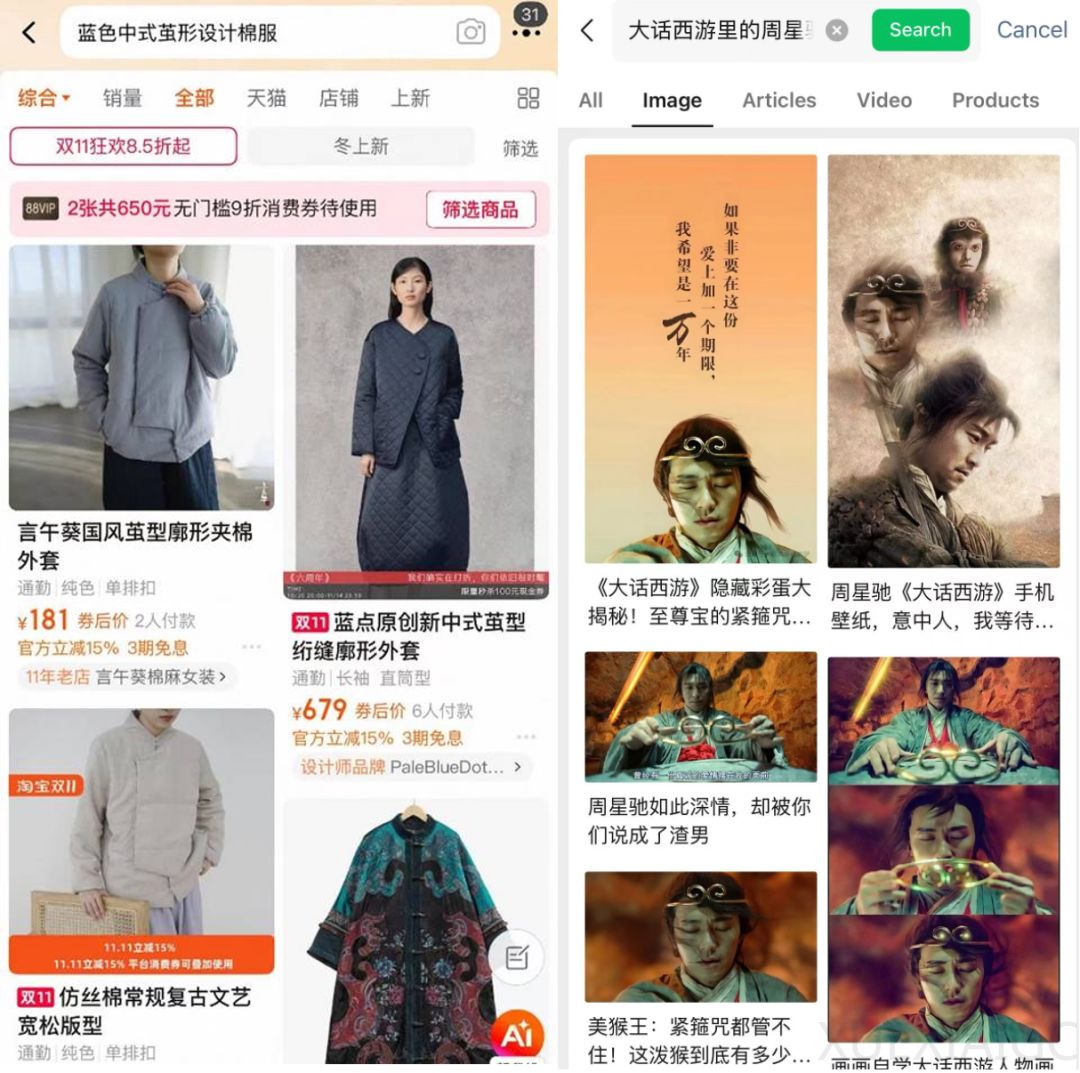

中英文双语能力是另一大优势。该模型在英文任务中以81.10分远超Meta CLIP 2(72.71分)和OpenAI CLIP(64.10分),同时通过自建LIT-CN等中文评估集,在语义理解上超越阿里Chinese-CLIP等专注中文的模型。这种双语一致性使其在电商搜索、内容审核等场景具备独特价值。

技术落地方面,FG-CLIP 2已应用于360的广告配图、IoT设备检索等业务,并通过API开放能力。在AIGC领域,它能监督生成内容与提示语的细节一致性;在具身智能中,可帮助机器人理解「拿起红色水杯」等空间指令。研究团队表示,该模型是其多模态技术体系的关键基石,与早前发布的LMM-Det、360VL等构成从感知到生成的完整链条。

这项突破标志着中国团队在多模态基础研究上的系统性进展。通过自建高质量数据集和训练方法创新,FG-CLIP 2不仅解决了传统模型的「近视」问题,更为未来通用智能的发展提供了重要技术支点。开源策略将进一步加速行业应用,推动视觉-语言理解技术向更精细维度发展。

原文和模型

【原文链接】 阅读原文 [ 3691字 | 15分钟 ]

【原文作者】 机器之心

【摘要模型】 deepseek/deepseek-v3-0324

【摘要评分】 ★★★★★