文章摘要

【关 键 词】 LLM、隐式推理、思维链、计算效率、可解释性

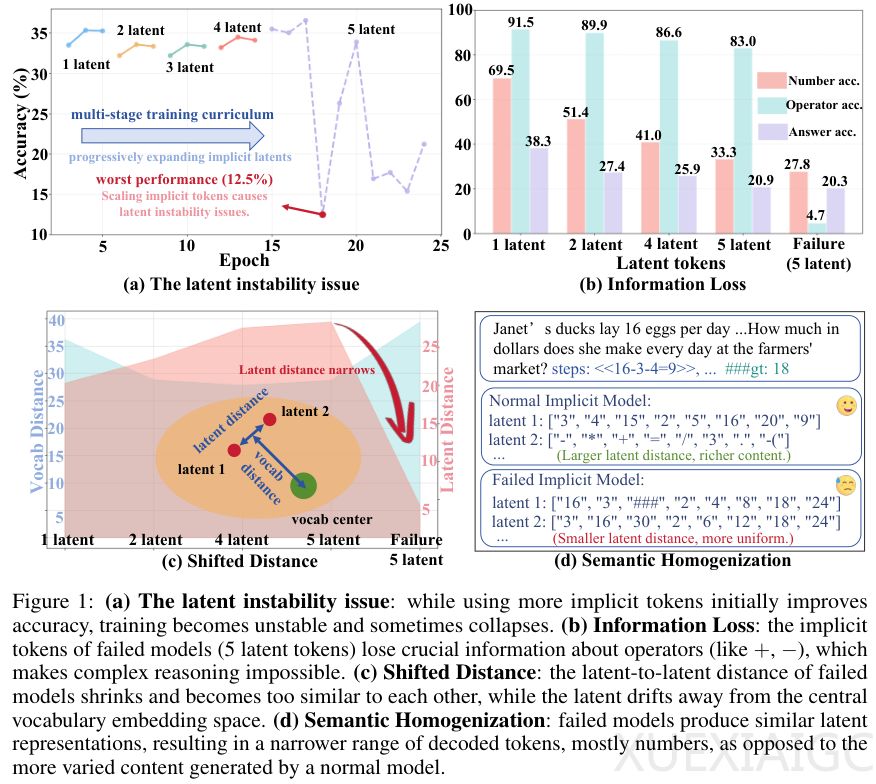

复旦大学与上海AI实验室联合团队提出的SIM-CoT(受监督隐式思维链)技术通过分步监督机制解决了隐式推理的稳定性问题。该方法在ICLR 2026被收录的论文中显示,传统隐式思维链(Implicit CoT)虽能压缩推理过程至潜在空间降低计算成本,但面临潜在不稳定性(Latent Instability)和语义同质化(Semantic Homogenization)两大核心缺陷。当隐式token数量超过临界点(如5个),模型准确率会断崖式下跌至12.5%,内部分析表明潜在向量逐渐脱离语义空间,丧失捕捉数学运算符等关键信息的能力。

SIM-CoT创新性地引入辅助解码器架构,在训练阶段强制每个隐式潜在向量对齐显式推理步骤,形成步骤级隐式监督。该设计在推理阶段完全移除解码器,保持隐式推理的高效性(2.3倍token节省),同时通过监督信号防止潜在空间坍缩。实验数据显示,该方法在GSM8K-Aug数据集上相对Coconut基线提升22.4%准确率,首次实现小模型隐式推理全面超越显式CoT(SFT-CoT),并在LLaMA系列模型中保持扩展性。

可解释性突破是另一关键成果:训练后的辅助解码器可将潜在向量逆向映射为人类可读的推理步骤。在西瓜收成案例中,模型输出答案”21″的同时,内部推导过程被完整可视化验证。该方法在SVAMP等域外测试集上平均提升4.3个点,证明其泛化能力优于易受文本格式影响的显式CoT。消融研究表明SIM-CoT可稳定支持8个隐式token的深度推理,打破传统隐式方法的扩展限制。

研究还发现解码器尺寸并非越大越好,1B参数解码器已能提供有效监督,过大规模(8B)反而导致性能轻微下降。该方法展现出与软思维技术的兼容性,为未来构建更复杂的隐式推理系统奠定基础。通过平衡监督强度与潜在空间自由度,SIM-CoT实现了高效、稳定且可解释的”沉默思考”,推动大语言模型推理技术向实用化迈进。

原文和模型

【原文链接】 阅读原文 [ 3212字 | 13分钟 ]

【原文作者】 AIGC开放社区

【摘要模型】 deepseek/deepseek-v3-0324

【摘要评分】 ★★★★☆