刚刚,智源悟界·Emu3.5登场,原生具备世界建模能力

文章摘要

【关 键 词】 人工智能、多模态模型、世界建模、技术突破、开源项目

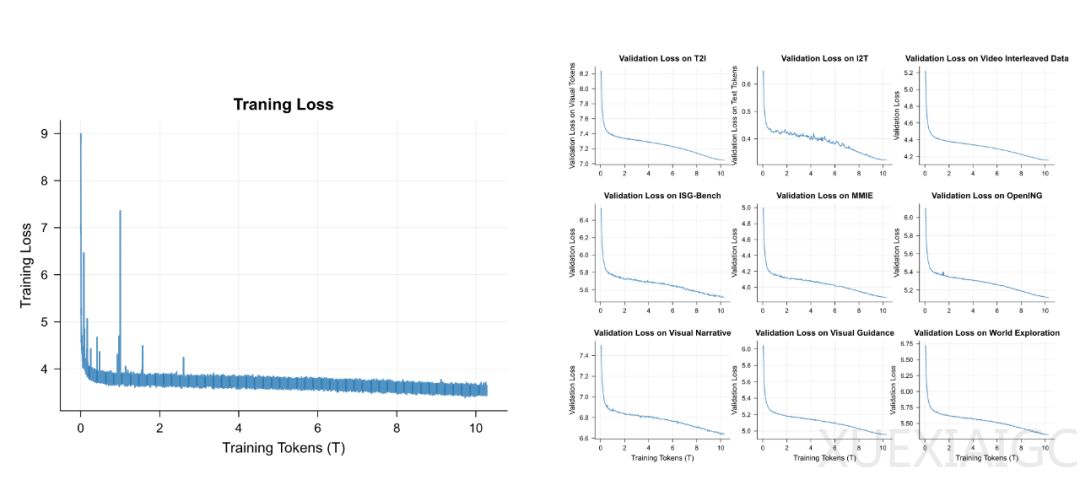

北京智源人工智能研究院发布了其多模态系列模型的最新力作——悟界・Emu3.5,被定义为“多模态世界大模型”。这一模型通过在超过10万亿的多模态Token上进行端到端预训练,学习并内化了现实物理世界的动态规律,展现出在长时程视觉指导、复杂图像编辑、世界探索和具身操作等任务上的强大潜力。Emu3.5首次揭示了“多模态Scaling范式”的存在,被认为是继语言预训练、推理和后训练之后,人工智能的第三条Scaling范式。

Emu3.5的创新之处在于其“原生多模态”理念和“下一状态预测”目标。与传统的“多模块”模式不同,Emu3.5实现了文本、图像、视频三种模态数据的理解和生成大一统。这种原生特性使其能够生成交错的视觉-语言输出,胜任视觉叙事和视觉指导等极具挑战性的新任务。例如,模型可以生成一系列图文并茂的卡片,逻辑连贯地讲述一个完整故事,或者生成分步的、带有视觉示例的教程。

Emu3.5的强大能力源于其庞大的训练流程。模型在包含10万亿Tokens的视觉-语言交错数据上进行训练,视频时长总计约790年。训练分为四个核心阶段:大规模预训练、监督微调、大规模多模态强化学习以及高效自回归推理加速。团队提出的“离散扩散自适应”(DiDA)技术将每张图像的推理速度提升了近20倍,且几乎没有性能损失,成功弥合了自回归模型与扩散模型之间的鸿沟。

Emu3.5在一系列任务中展现了卓越表现。在通用图像编辑与生成任务上,其文字渲染的准确性和自然度超越了包括Gemini-2.5-Flash-Image在内的领先模型。在世界建模与探索方面,Emu3.5能够生成在虚拟环境中连续移动的视觉序列,并保持场景的一致性。在具身操作任务中,模型能够将复杂任务分解为一系列带有语言指令和关键帧图像的子任务,为训练更通用的具身智能体提供了基础。

Emu3.5的突破为具身智能的发展补全了关键拼图。模型可以作为一个无限数据生成器,不仅能够生成丰富多样的虚拟环境和任务,还能生成从高层目标到具体操作的分步规划数据。通过“下一状态预测”和原生多模态融合,Emu3.5自然涌现出对时空、物理规律、因果等世界动态的内在理解,这正是机器人进行自主导航、精细操作、复杂决策等任务的基础。

智源研究院宣布后续将开源Emu3.5,以支持社区的进一步研究。Emu3.5展示出了作为“世界模型的基础模型”的巨大潜力,其开源无疑将为全球AI研究社区提供一个强大的新基座。技术报告也指出,模型在视觉分词器的压缩率和DiDA的加速潜力方面仍有提升空间,对新能力的评估也需要建立更系统化的基准。

原文和模型

【原文链接】 阅读原文 [ 2810字 | 12分钟 ]

【原文作者】 机器之心

【摘要模型】 deepseek/deepseek-v3-0324

【摘要评分】 ★★★★★