文章摘要

【关 键 词】 大模型、Agent、扩散模型、规划能力、效率提升

大模型通往现实世界的“最后三公里”中,Agent已成为最具代表性的技术路径。当前行业共识已从单纯追求“答对问题”转向更复杂的评估维度:能否以最短路径、最少交互预算稳定完成任务。华为诺亚方舟实验室联合多所高校的最新研究《DLLM Agent: See Farther, Run Faster》揭示,仅将语言模型生成范式从自回归(AR)改为扩散(DLLM),即可系统性改变Agent的行为模式。

研究发现,在完全相同的Agent框架、工具和数据条件下,DLLM Agent展现出显著优势:端到端执行速度平均提升30%以上,部分复杂任务效率甚至达到AR模型的8倍。这种提升并非源于计算速度差异,而是体现在决策质量上——DLLM Agent使用更少交互轮次和工具调用,且规划轨迹更直接,回溯和冗余更少。实验设计严格控制变量,唯一变化因素是生成范式,确保结论可靠性。

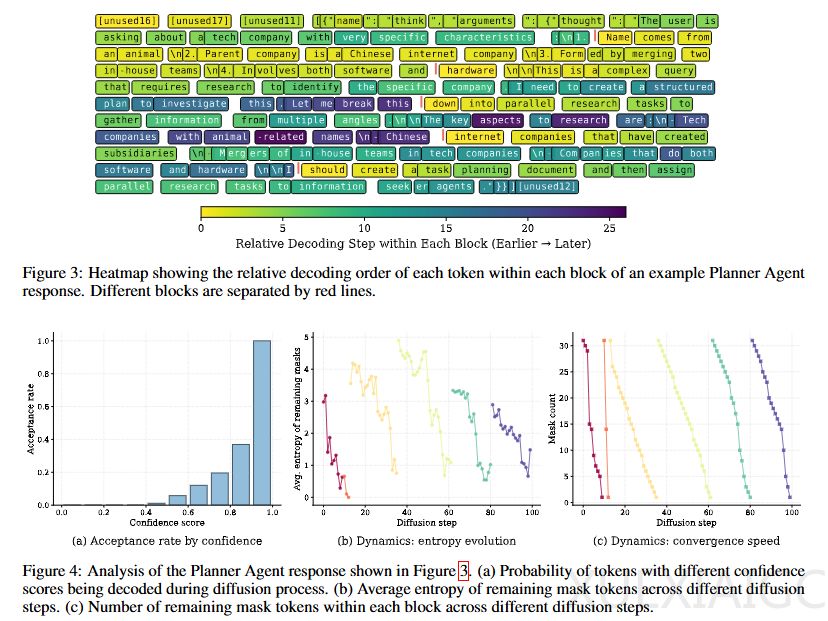

在BrowseComp-zh基准测试中,DLLM Agent表现出三个核心特征:工具调用次数减少、执行路径缩短、延迟降低,但同时也暴露结构化输出易错的问题。典型案例显示,处理多约束检索任务时,DLLM Agent通过更优的规划策略实现8.18倍速度优势。深度分析表明,DLLM的并行生成特性使其呈现“先全局后细节”的两阶段规划模式,与人类思维相似——早期并行提取关键约束,后期细化任务结构,避免了AR模型“边想边写”导致的冗余修正。

工具调用阶段,DLLM表现出独特的结构化倾向:先确定工具再并行生成参数,将整个调用视为可优化的“动作块”。注意力机制分析进一步揭示,DLLM在决策早期集中处理不确定性,随后快速收敛,其注意力模式呈现“全局→局部”的协调特性,与AR的局部最优策略形成对比。研究也指出DLLM的局限性,需通过特定训练策略(如span-aware attention mask)来提升结构化输出稳定性。

这项工作的意义在于揭示了生成范式本身可作为Agent设计的新维度。扩散模型不仅提供另一种生成方式,更通过并行推理能力重塑Agent行为:更早形成全局计划、减少无效探索、加速任务闭环。这种特性在需要快速决策的实时系统中具有重要应用潜力,为下一代高效Agent开发指明新方向。

原文和模型

【原文链接】 阅读原文 [ 2052字 | 9分钟 ]

【原文作者】 量子位

【摘要模型】 deepseek/deepseek-v3-0324

【摘要评分】 ★★★★★