只用2700万参数,这个推理模型超越了DeepSeek和Claude

文章摘要

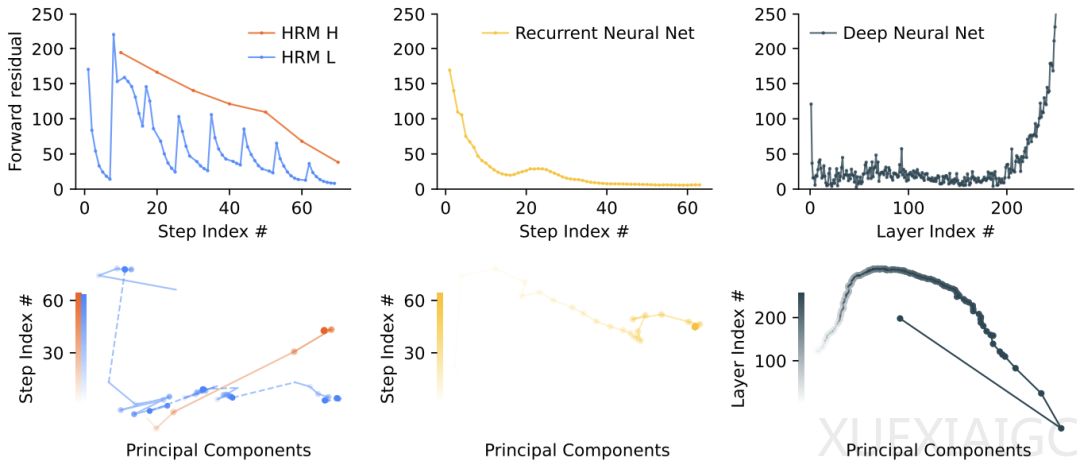

大语言模型在复杂推理任务中面临任务分解复杂、数据需求大以及高延迟等问题,当前的思维链(CoT)技术存在局限性。为了解决这些问题,Sapient Intelligence的研究者提出了分层推理模型(HRM),这是一种受大脑分层和多时间尺度处理机制启发的全新循环架构。HRM通过两个相互依赖的循环模块,在单次前向传递中执行顺序推理任务,无需对中间过程进行明确的监督。其中一个高级模块负责缓慢、抽象的规划,另一个低级模块负责处理快速、细致的计算。HRM仅包含2700万个参数,仅使用1000个训练样本,便在复杂的推理任务上取得了卓越的性能。

HRM无需预训练或CoT数据即可运行,在包括复杂数独谜题和大型迷宫中最优路径查找在内的挑战性任务上取得了近乎完美的性能。在抽象与推理语料库(ARC)上,HRM的表现优于上下文窗口明显更长的大型模型。ARC是衡量通用人工智能能力的关键基准。HRM的核心设计灵感来源于大脑的分层结构和多时间尺度处理机制。具体来说,大脑通过皮层区域的多级层次结构处理信息,高级脑区在更长的时间尺度上整合信息并形成抽象表示,而低级脑区负责处理即时、具体的感知运动信息。这种时间分离机制使得高级脑区能稳定地指导低级脑区的快速计算过程。

HRM模型由四个可学习的组件组成:输入网络、低级循环模块、高级循环模块和输出网络。HRM将输入向量映射到输出预测向量,通过循环连接特性实现表示精确度的提升和上下文适应性增强。HRM引入了近似梯度和深度监督机制,设计了一种一步梯度近似法,核心思想是使用每个模块最后状态的梯度,并将其他状态视为常数。这种方法需要O(1)内存,不需要随时间展开,并且可以使用PyTorch等自动求导框架轻松实现。深度监督机制则通过多次前向传递,对HRM模型进行训练。

HRM还引入了自适应计算时间(ACT)机制,受大脑在自动化思维与审慎推理之间动态切换的启发,实现了快思考与慢思考的动态调整。ACT能够根据任务复杂性有效地调整其计算资源,从而显著节省计算资源,同时最大程度地降低对性能的影响。HRM在推理时间扩展方面表现出色,仅需增加计算限制参数即可无缝实现推理计算扩展,而无需重新训练或调整模型架构。

在实验及结果部分,HRM在ARC-AGI、数独和迷宫基准测试中表现出色。在迷宫任务中,HRM最初会同时探索多条潜在路径,随后排除阻塞或低效的路径,构建初步解决方案大纲,并进行多次优化迭代。在数独任务中,HRM的策略类似于深度优先搜索方法,模型会探索潜在解决方案,并在遇到死胡同时回溯。在ARC任务中,HRM对棋盘进行渐进式调整,并不断迭代改进,直至找到解决方案。HRM在基准任务中对中间预测结果的可视化显示,模型可以适应不同的推理方法,并可能为每个特定任务选择有效的策略。

HRM的图灵完备性与早期的神经推理算法类似,在给定足够的内存和时间约束的情况下,HRM具有计算通用性。它克服了标准Transformer的计算限制,属于可以模拟任何图灵机的模型类别。HRM从基于梯度的密集监督中获取反馈,而不是依赖于稀疏的奖励信号,这在生物学上是合理的,避免了为每个token分配相同的计算资源进而导致的低效。HRM的提出为通用计算的变革性进步提供了新的可能性。

原文和模型

【原文链接】 阅读原文 [ 2659字 | 11分钟 ]

【原文作者】 机器之心

【摘要模型】 deepseek-v3

【摘要评分】 ★★★★★