文章摘要

【关 键 词】 AI生成、图像编辑、分层结构、PSD文件、专业设计

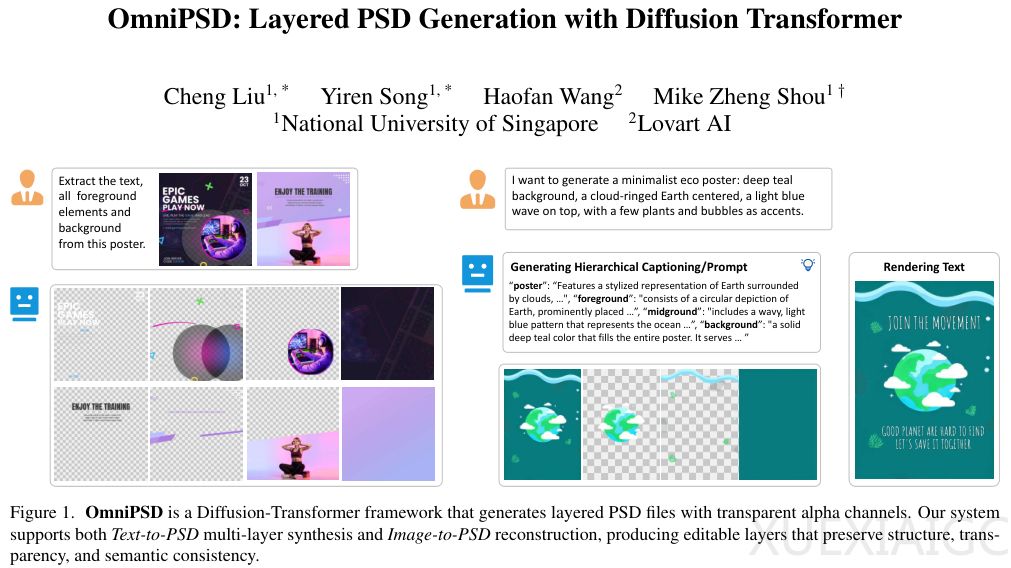

OmniPSD通过Diffusion Transformer架构实现了分层图像生成与拆解,标志着AI从生成图片向生成可编辑资产的跨越。该系统由新加坡国立大学和Lowart AI联合开发,能够通过文本生成带有透明通道的分层PSD文件,或将单张平面图像逆向拆解为可编辑的图层结构,解决了传统AI生成图像难以二次编辑的核心痛点。

当前主流生成模型如Stable Diffusion和Midjourney输出的扁平化光栅图像缺乏结构化属性,而专业设计工作流依赖PSD格式的图层、透明度和合成关系。OmniPSD的创新在于其重新训练的RGBA-VAE模块,专门处理透明度信息,通过多损失函数机制确保半透明区域的细节保留。相比传统VAE,该模块在重建透明图像时显著减少了边缘模糊和伪影,实现了包含光影投射等丰富细节的完整资产输出。

系统架构基于Flux生态系统,采用差异化策略处理生成与拆解任务。Text-to-PSD功能通过2×2网格化策略实现图层联合生成,利用Transformer的注意力机制保持跨层语义对齐;Image-to-PSD则采用逆向工程流水线,结合分割与生成能力完整恢复被遮挡的背景。这种设计无需额外控制模块,仅通过DiT原有架构就实现了图层间的动态协调。

为支撑模型训练,研究团队构建了包含20万专业PSD文件的Layered Poster数据集,采用层级化文本描述和三元组数据结构。实验数据显示,OmniPSD在FID和CLIP Score指标上显著优于LayerDiffuse等对比模型,尤其在复杂透明度处理方面表现突出。在缺乏直接竞品的图像拆解任务中,其背景修复质量远超基于SAM2的分割方案,实现各图层无缝组合的技术突破。

这项技术将AI从辅助工具升级为生产管线组件,可能重塑广告设计、游戏美术等领域的创作流程。设计师可直接编辑AI生成的源文件,或快速拆解现有素材进行重组,大幅提升工作效率。该进展预示着图像生成技术向结构化、语义化方向的演进,为数字内容创作开辟了新的可能性。

原文和模型

【原文链接】 阅读原文 [ 2690字 | 11分钟 ]

【原文作者】 AIGC开放社区

【摘要模型】 deepseek/deepseek-v3-0324

【摘要评分】 ★★★★★