复旦大学/上海创智学院邱锡鹏:Context Scaling,通往AGI的下一幕

文章摘要

人工智能领域正在经历一场深刻的变革,从传统的预训练模型向更复杂的情境智能(Contextual Intelligence)转变。2024年底,Ilya Sutskever的断言引发了业界对“Scaling What”的广泛讨论,新的技术路径如推理时扩展(Test-Time Scaling)、强化学习突破以及Agent化路径不断涌现。其中,复旦大学邱锡鹏教授提出的Context Scaling尤为引人注目。Context Scaling的核心在于让AI理解并适应复杂、多变、模糊的情境,而非单纯追求更大的参数规模或数据量。

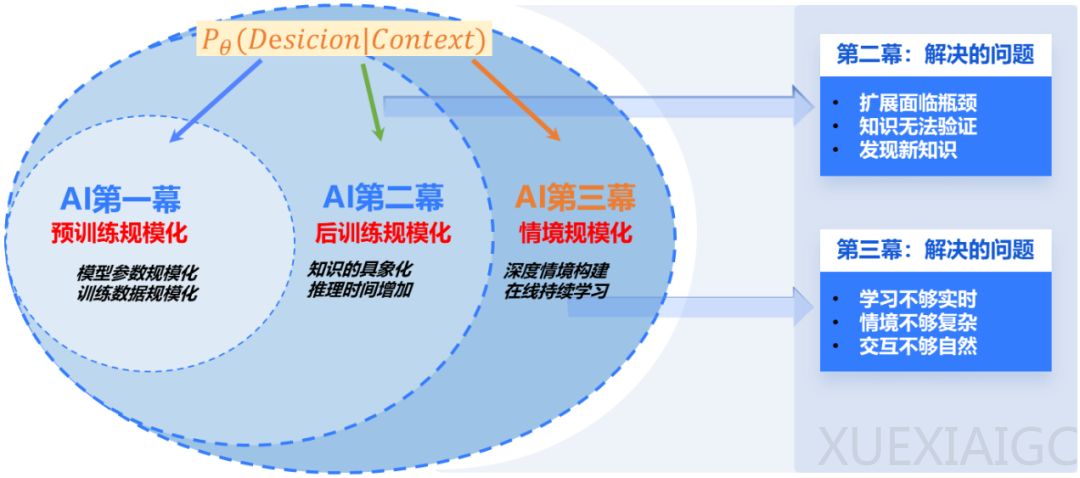

邱锡鹏教授将大模型的演进分为三幕:第一幕是模型规模化的胜利,通过堆叠数据与参数,实现了通用任务上的跃升;第二幕是后训练优化的探索,通过推理增强、知识具象化等手段提升模型解决复杂问题的能力;第三幕则是Context Scaling,旨在解决现有模型在模糊情境中决策的局限性。这一阶段的关键在于让AI理解并适应足够丰富、真实、复杂的情境信息,从而在模糊不清的世界中作出合情合理的判断。

Context Scaling的核心内涵在于捕获难以描述的“暗知识”,如社交智能、文化适应、情境判断和动态适应等。这些隐性知识构成了人类智能的核心,而AI若能通过Context捕获这些信息,将实现真正意义上的智能突破。例如,AI需要理解“不要”在不同情境下的不同含义,才能在多模态、多轮对话中做出准确的判断。此外,Context Scaling还对AI安全发展具有重要影响,通过让AI理解复杂的社会情境和隐含价值观,能够在没有明确禁令的情况下做出符合人类价值观的判断。

邱锡鹏教授指出,Context Scaling的成功依赖于三大技术支柱:强交互性、具身性和拟人化。强交互性要求AI不仅学会如何行动,更要理解为什么这样行动;具身性强调AI在虚拟或现实环境中的主体性;拟人化则要求AI具备类人的情感共鸣和反馈能力。这些能力使得AI能够在复杂情境中持续学习、调整策略,从而实现能力的持续提升。

然而,Context Scaling的实现也面临诸多技术挑战,包括模型结构的突破、学习范式的转变以及复杂情境的定义与构建。现有Transformer架构在长上下文处理上的效率受限,而Context Scaling要求模型支持多模态、交互式、动态变化的情境输入,这可能需要模型架构的根本重构。此外,从传统监督学习到交互式、持续式的弱监督学习,以及在新情境中快速适应的元学习能力,Context Scaling所需的训练目标与损失函数正在重塑AI学习的本质。

Context Scaling并非替代其他技术路径,而是对其构成补充与整合。例如,Test-Time Scaling关注输出阶段的计算效率,而Context Scaling关注输入的质量与结构,两者是正交互补的。与Agent路径相比,Context Scaling更多是对任务定义层的重新设想,强调智能体理解复杂情境的核心能力,这种能力可以通过各种Agent架构来实现,但其本身超越了具体的工具使用和任务执行。

Context Scaling不仅是大模型发展的下一幕,更可能是通向AGI(通用人工智能)的关键一步。在这场“Scaling What”的集体探索中,Context Scaling将推理增强、多模态融合、强化学习等看似分散的技术路径统一在“情境理解”这一核心目标之下。智能的本质,也许就在于面对复杂世界时那份模糊中的准确、不确定中的判断、冲突中的协调。

原文和模型

【原文链接】 阅读原文 [ 2631字 | 11分钟 ]

【原文作者】 机器之心

【摘要模型】 deepseek-v3

【摘要评分】 ★★★★★