大道至简,何恺明团队新作pMF开启像素级「无潜、单步」生成范式

文章摘要

【关 键 词】 生成式AI、扩散模型、图像生成、深度学习、单步生成

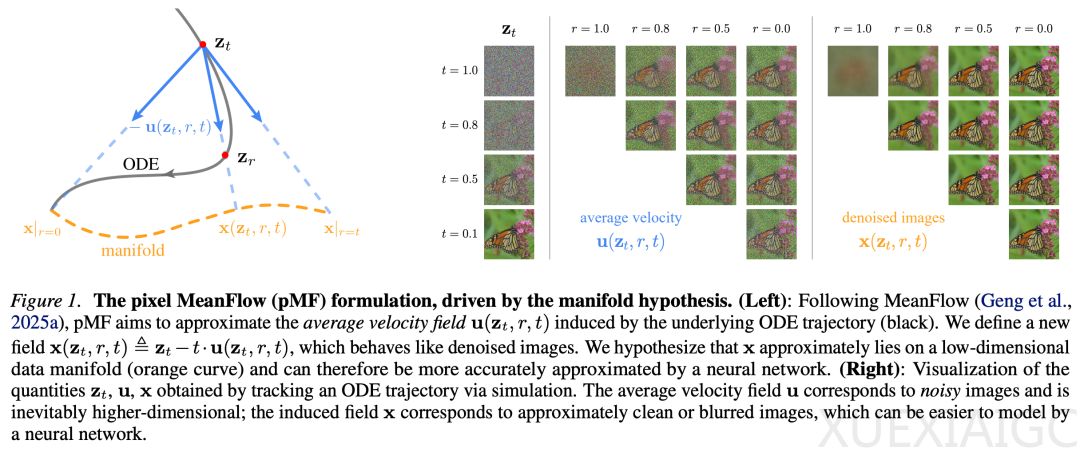

何恺明团队的最新研究提出了一种名为pixel MeanFlow(pMF)的创新框架,旨在解决当前主流扩散模型与流匹配模型在多步采样和潜空间依赖上的局限性。该框架能够实现单步、无潜空间的图像生成,显著降低了系统的复杂性和推理开销。研究团队通过在瞬时速度空间内定义损失函数,学习平均速度场,并直接对去噪图像的物理量进行参数化,从而构建了一个更高效、更直接的生成范式。

pMF框架的核心在于建立了u、v和x三个场之间的关联,其中u代表平均速度场,v代表瞬时速度场,x代表去噪图像场。团队引入了一种转换机制,将这三个场联系起来,使得网络能够直接输出x,同时保持单步建模的特性。实验证明,这种设计更符合流形假设,并且产生了一个更易于学习的目标。此外,pMF具备「所见即所得」的特性,使得感知损失能够自然地集成到模型中,进一步提升了生成质量。

在实验部分,研究团队通过2D玩具实验验证了x-prediction的优越性。结果显示,在高维空间中,x-prediction的表现显著优于u-prediction,表明x位于更低维的流形上,更易于学习。在ImageNet数据集上的测试中,pMF在256×256分辨率下达到了2.22的FID分数,在512×512分辨率下达到了2.48的FID分数,展现了其在单步、无潜空间生成方面的强劲性能。

研究还发现,选择合适的预测目标至关重要。在像素空间直接预测速度场会导致性能崩溃,而预测x则能够有效避免这一问题。此外,pMF在高分辨率生成和模型扩展性方面也表现出色,能够处理极具挑战性的高维观测空间,并且随着模型规模和训练时间的增加,性能进一步提升。

这项研究标志着向构建单一、端到端神经网络形式的直接生成建模迈出了坚实的一步。它不仅验证了单步、无潜空间生成的可行性,还为生成式AI领域提供了一种更高效、更简洁的解决方案。未来,这一框架有望在更多实际应用中展现出其潜力。

原文和模型

【原文链接】 阅读原文 [ 2241字 | 9分钟 ]

【原文作者】 机器之心

【摘要模型】 deepseek/deepseek-v3-0324

【摘要评分】 ★★★★★