文章摘要

【关 键 词】 AI技术、多模态模型、开源项目、视频分析、计算机视觉

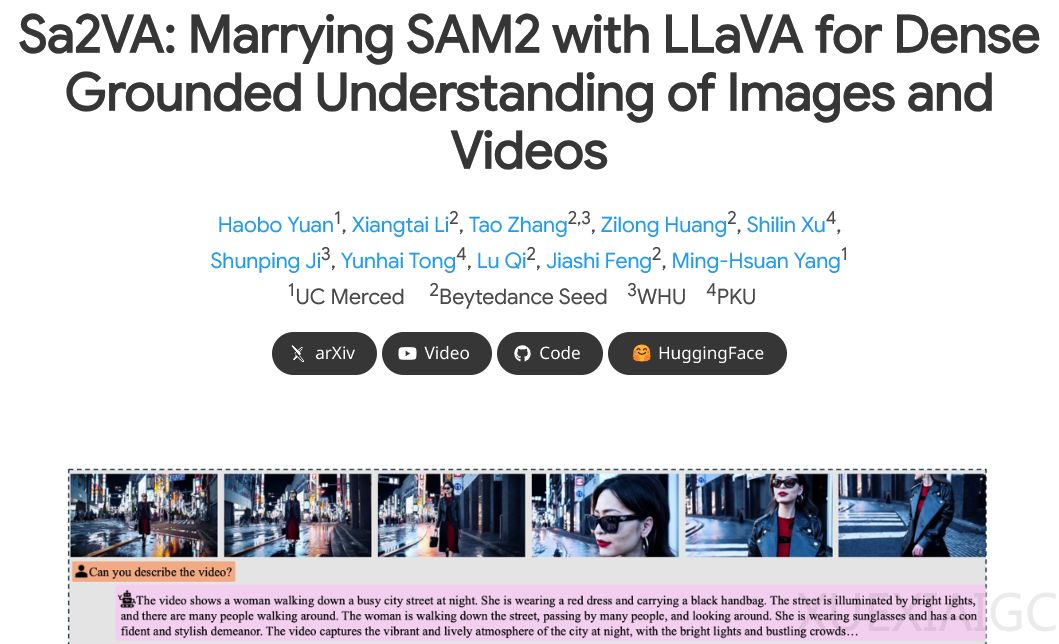

加州大学默塞德分校、字节跳动Seed团队、武汉大学和北京大学的研究人员成功将LLaVA和SAM-2两个AI模型整合,创造出名为Sa2VA的新型多模态系统。这一突破性成果实现了语言理解与视觉定位能力的完美结合,为人工智能在复杂视觉任务中的应用开辟了新路径。

Sa2VA采用独特的双模块架构设计。LLaVA模块作为语言理解核心,负责处理文本、图像和视频输入,通过视觉编码器和投影层将视觉信息转化为语言模型可理解的token。该模块基于Qwen2.5或InternLM2.5等大型语言模型构建,擅长宏观内容理解和对话生成。SAM-2模块则专精于视觉分割与跟踪,能生成像素级精准的掩码,但缺乏语义理解能力。两个模块通过特殊的”[SEG]”指令token实现协同工作,形成可反向传播的闭环系统。

研究团队采用多任务联合训练策略,使模型同步掌握指代表达分割、视频对象分割、视觉问答和定位对话生成等多项技能。在RefCOCO、MeVIS和DAVIS等基准测试中,Sa2VA展现出卓越性能,特别是在视频指代表达分割任务上表现突出。随着参数规模从10亿扩展到260亿,模型性能呈现稳定提升趋势。为评估真实场景表现,团队专门构建了包含7万复杂场景的Ref-SAV数据集,其中2000个视频经过人工精细标注。

该项目的另一重要贡献是完全开源策略。研究团队不仅发布了从轻量到重量级的全系列模型,还公开了训练数据集、评估代码、推理脚本和演示程序等完整工具链。基于InternVL和QwenVL等优秀底层模型,Sa2VA为开发者提供了高度灵活的应用选择。实际演示显示,系统能准确执行如”分割穿黄色连衣裙的女孩”等复杂指令,并在《爱乐之城》《教父》等电影片段分析中,同时完成对象追踪和氛围理解双重任务。

这项技术的创新价值在于首次实现了语义理解与视觉定位的无缝集成,解决了多模态AI长期存在的”能说不会指”与”能指不会说”的矛盾。其应用前景涵盖智能视频编辑、实时监控分析、增强现实交互等多个领域,为人机协作模式带来了新的可能性。通过模块化设计和开源生态建设,Sa2VA为后续多模态研究提供了可扩展的技术框架和发展路径。

原文和模型

【原文链接】 阅读原文 [ 2044字 | 9分钟 ]

【原文作者】 AIGC开放社区

【摘要模型】 deepseek/deepseek-v3-0324

【摘要评分】 ★★★★★