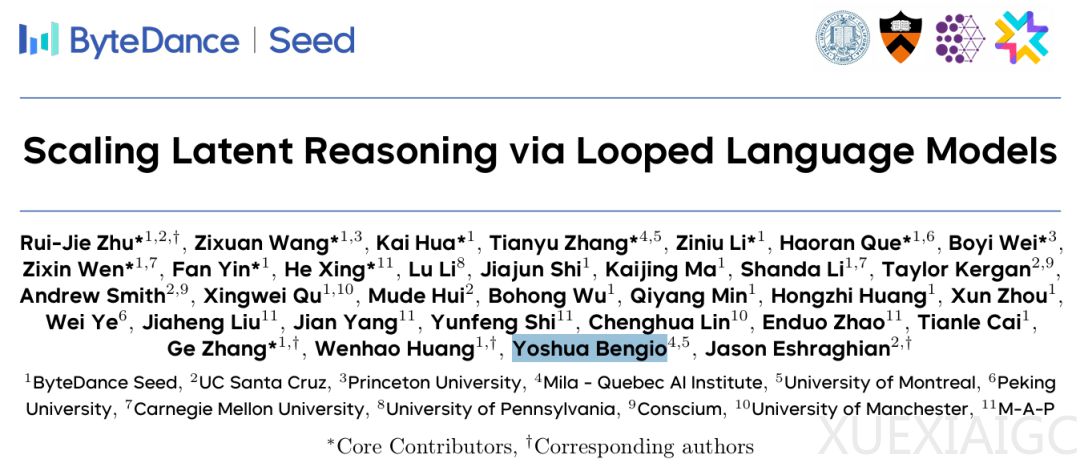

字节Seed团队发布循环语言模型Ouro,在预训练阶段直接「思考」,Bengio组参与

文章摘要

【关 键 词】 循环语言模型、潜在推理、参数效率、自适应计算、熵正则化

现代大型语言模型(LLM)通常依赖显式的文本生成过程(如思维链)进行推理训练,但这种方法未能充分利用预训练数据的潜力。为解决这一问题,字节Seed团队联合多家机构开发了Ouro循环语言模型(Looped Language Models),其设计灵感来源于象征循环的衔尾蛇(Ouroboros)。该模型通过三项核心技术革新实现了预训练阶段的直接推理能力构建:在潜在空间进行迭代计算、采用熵正则化目标实现学习型深度分配,以及扩展至7.7T tokens的超大规模数据训练。

模型架构采用参数共享的循环设计,在固定参数预算内实现动态计算深度。核心是由N个共享权重层组成的层堆栈,通过多次循环应用形成”潜在思想链”。与标准Transformer不同,该架构集成自适应退出机制:简单输入经少量循环即可退出,复杂输入则自动分配更多迭代次数。研究表明,这种潜在推理机制相比显式思维链更接近人类真实推理过程,产生的因果一致性推理优于传统的事后合理化解释。

实验数据表明,Ouro模型实现了显著的参数效率突破。1.4B和2.6B参数的循环模型在多数基准测试中分别达到4B和8B标准Transformer的性能,参数效率提升2-3倍。在HEx-PHI基准测试中,循环架构还展现出独特的安全性优势——随着循环步数增加,模型有害性输出持续降低。值得注意的是,性能提升主要源于知识操控能力的增强而非知识存储量的扩充,这通过对照实验得到验证。

训练流程采用多阶段优化策略,包含通用预热、稳定训练、CT退火等六个阶段。为平衡计算深度与稳定性,团队将初始设计的8循环步缩减至4步。创新的两阶段训练目标整合了所有循环步的期望任务损失和熵正则化项,既鼓励模型探索不同计算深度,又通过退出概率实现推理时的动态计算分配。最终产出的Ouro-Thinking系列模型在数学与科学数据集上表现突出,2.6B参数版本甚至超越部分8B规模基线模型。

这项研究为数据受限时代的模型扩展提供了新路径,证明通过优化计算架构而非单纯增加参数规模,同样能实现性能突破。循环语言模型展现的潜力包括:更高效的资源利用率、更接近人类的推理机制,以及可调节的安全特性,这些都为下一代语言模型的开发提供了重要参考方向。

原文和模型

【原文链接】 阅读原文 [ 1540字 | 7分钟 ]

【原文作者】 机器之心

【摘要模型】 deepseek/deepseek-v3-0324

【摘要评分】 ★★★☆☆