文章摘要

格灵深瞳最新发布的视觉基础模型Glint-MVT在多个领域展现了显著的技术突破。该模型通过引入间隔Softmax损失函数,显著提升了泛化能力,并在26个分类测试集中表现优异,平均准确率分别比OpenCLIP和CLIP高出2.3%和1.1%。Glint-MVT的核心创新在于将间隔Softmax引入视觉预训练Transformer模型,通过构造百万级虚拟类别训练模型,有效降低了数据噪声影响。这一技术不仅在图像分类任务中表现出色,还在图像分割、视频分割等下游任务中展现了强大的能力。

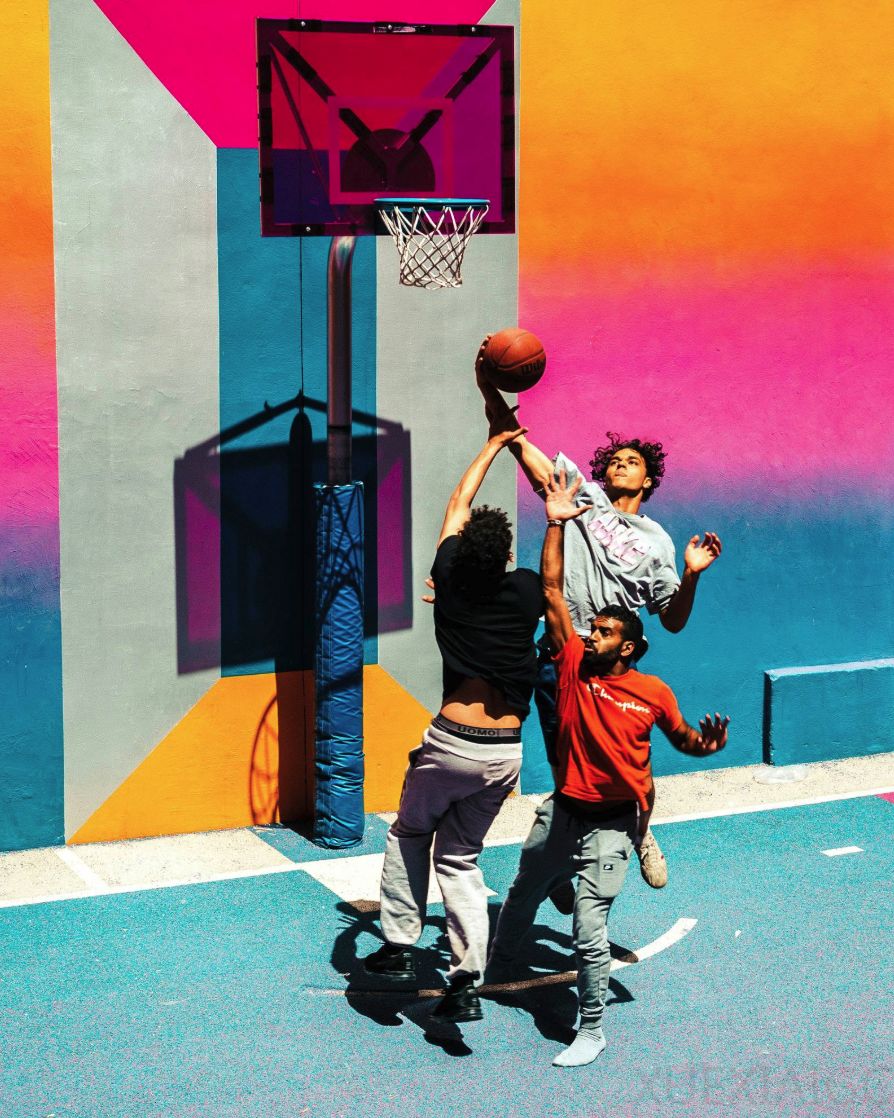

在图像分割任务中,Glint-MVT能够精准识别并分割复杂场景中的目标对象,即使目标被其他物体遮挡,也能实现超精细的分割效果。例如,在分割触摸篮球的人时,模型能够准确识别并分割出被遮挡的人物。此外,Glint-MVT还支持视频分割,能够在动态视频中稳定锁定目标对象,即使在快速变化的场景中也能保持高精度分割。例如,在Bruno Mars的唱跳视频中,模型能够准确分割出穿粉色西装的男子,细节处理非常到位。

Glint-MVT还应用于具身智能场景,能够根据自然语言指令进行任务判断。例如,当被问及“把橙子放到白色碗里是否合适”时,模型能够根据当前场景给出准确回答。这种能力展示了Glint-MVT在实际应用中的潜力,尤其是在需要复杂视觉理解和任务执行的场景中。

格灵深瞳团队在技术上的创新不仅限于模型本身,还包括训练方法的优化。通过虚拟类别构造和噪声抑制技术,团队显著提升了模型的训练效率和性能。相比传统的实例对比学习,间隔Softmax通过显式建模类别间边界,使模型更聚焦于语义结构,从而在图像检索和分类任务中表现更优。此外,团队还开发了基于Glint-MVT的多模态模型,如Glint-RefSeg和MVT-VLM,这些模型在引用表达分割和图像理解任务中均取得了当前的最优表现。

格灵深瞳的成功不仅源于技术创新,还与其务实的发展策略密切相关。作为国内计算机视觉领域的早期探索者,格灵深瞳始终专注于视觉技术的研发与落地,致力于解决实际产业痛点。公司坚持“从业务需求中来到产品落地中去”的研发逻辑,并通过开源策略推动技术创新和生态建设。这种务实与开放并存的哲学,使格灵深瞳在视觉技术领域持续领跑,并为AI技术的实际应用提供了有力支持。

Glint-MVT的发布标志着格灵深瞳在视觉基础模型领域的进一步突破,也为AI技术在复杂场景中的应用提供了新的可能性。未来,随着多模态大模型和视频理解技术的进一步发展,格灵深瞳有望在视觉技术领域继续引领创新,推动AI技术的实际落地。

原文和模型

【原文链接】 阅读原文 [ 2355字 | 10分钟 ]

【原文作者】 量子位

【摘要模型】 deepseek-v3

【摘要评分】 ★★★★★