文章摘要

思科最新发布的Silicon One P200 ASIC芯片和8223路由系统标志着数据中心网络技术的重大突破。这款51.2 Tbps路由器通过800 Gbps相干光器件支持长达1,000公里的传输距离,理论上可构建总带宽达3 EB/秒的超大规模网络,足以连接当前最大的AI训练集群。其创新性在于将多个数据中心整合为统一计算单元,微软、阿里巴巴等云服务商已开始评估该技术的部署潜力,阿里云特别指出这将显著提升其DCI网络的稳定性与扩展性。

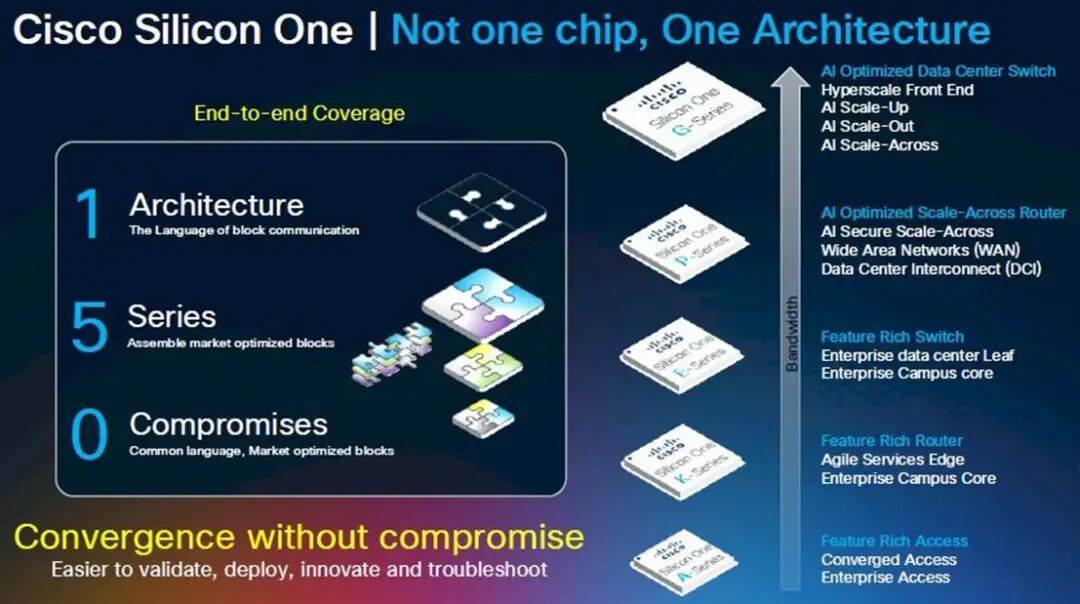

跨数据中心网络架构正成为AI算力扩展的关键路径。随着AI模型规模每年翻倍,单个数据中心的物理限制(如电力供应、散热)迫使行业转向分布式方案。思科院士Rakesh Chopra阐释了”跨网络扩展”概念:不同于传统纵向扩展(连接机架内GPU)或横向扩展(连接数据中心内节点),新架构需在广域范围内实现14倍于传统DCI的带宽。通过512个叶节点和256个脊节点组成的全双工网络,P200芯片可提供12.8 PB/秒聚合带宽,而三层架构更可扩展至3,355 PB/秒。

深度缓冲技术是思科方案的核心差异化优势。尽管传统观点认为深度缓冲区会导致AI训练延迟,但思科通过改进拥塞控制算法解决了这一难题。P200配备16GB HBM3内存作为数据包缓冲区,能吸收流量突发并避免数据包丢失——这对持续数月的AI训练至关重要,因为单个数据包丢失就可能导致整个训练回滚到检查点。该技术结合后量子加密和硬件信任根,为长距离数据传输提供了安全基础。

行业竞争格局正在重塑,思科、英伟达和博通分别提出了不同的技术路线。博通的Jericho4交换机同样提供51.2 Tbps带宽,而英伟达的Spectrum-XGS则侧重浅缓冲区设计以追求最低延迟。市场需求的多样性使这些方案可能长期共存:思科的深度缓冲适合对网络弹性要求高的分布式场景,英伟达方案则更适合延迟敏感型任务。值得注意的是,8223路由器同时支持SONiC和IOS-XR操作系统,既能满足超大规模厂商对开源技术的偏好,也保留了传统网络设备的兼容性。

电力与成本因素正深刻影响数据中心拓扑结构。相比传统15-30千瓦/机架的Web服务基础设施,NVIDIA的GPU机架功耗已达140千瓦并可能突破1兆瓦,这使得集中式超大规模数据中心面临供电瓶颈。思科的计算显示,使用P200芯片构建分布式网络仅需2,000个端口即可实现13 PB/秒带宽,较传统模块化方案减少87.5%的端口需求,在功耗、空间和管理复杂度方面带来显著优化。这种”数据中心即芯片”的架构理念,正在重新定义下一代AI基础设施的形态。

原文和模型

【原文链接】 阅读原文 [ 5426字 | 22分钟 ]

【原文作者】 半导体行业观察

【摘要模型】 deepseek/deepseek-v3-0324

【摘要评分】 ★★★★★