文章摘要

【关 键 词】 AI模型、延迟优化、硬件契合、进化算法、混合架构

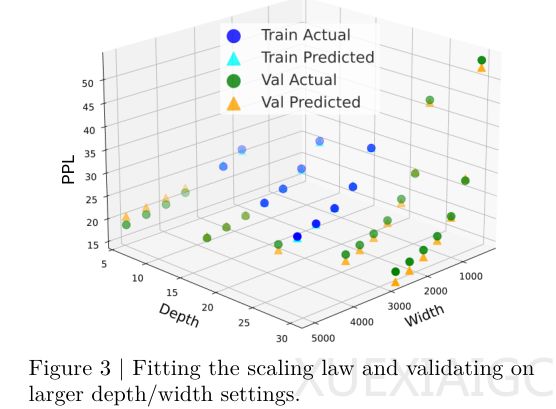

NVIDIA最新研究颠覆了传统小型语言模型的设计理念,参数数量减少不再直接等同于速度提升,关键在于模型架构与硬件特性的深度匹配。研究团队通过Nemotron-Flash系列模型,提出了一套面向真实设备延迟的全新设计哲学。传统的“深而瘦”架构在GPU并行计算环境中表现不佳,层数过多导致顺序依赖问题,严重浪费GPU的并行处理能力。实验数据表明,在相同延迟预算下,层数较少但宽度较大的“矮胖”模型往往表现更优。研究人员修正了经典的缩放定律,将参数总量拆解为深度和宽度两个独立变量,使模型设计从经验主义走向精确的工程计算。

在微观架构层面,研究团队放弃了单一算子的取舍策略,转而寻求混合架构的最优解。通过对DeltaNet、Gated DeltaNet和Mamba2等新兴算子的系统测试,发现这些算子组合时能产生超预期的协同效应。基于进化算法的自动搜索框架帮助团队从无数种可能的排列组合中找到最优架构,最终形成了DeltaNet、Mamba2和全注意力层交织的混合设计。这种结构既保留了Transformer的记忆力,又充分发挥了线性算子的速度优势。

训练策略的革新也是Nemotron-Flash成功的关键。权重归一化技术通过将参数投影到单位球面,显著改善了模型后期的收敛行为,提升了泛化能力。针对线性注意力机制初始状态不稳定的问题,创新的元Token机制通过预置可学习的虚拟Token,有效解决了“冷启动”问题,增强了语言建模的稳定性。

性能测试结果显示,Nemotron-Flash在准确率和速度两方面都实现了突破。3B版本在数学和代码任务上的表现显著优于同类产品,最大吞吐量达到每秒2939个Token,是竞品的6.4倍。更值得注意的是,通过合理配置注意力机制,在几乎不影响准确率的情况下,吞吐量可进一步提升至每秒4657个Token。从系统层面的大词表Tokenizer设计到微观架构的精细优化,Nemotron-Flash展示了如何通过深度理解硬件特性来打造真正高效的语言模型。

原文和模型

【原文链接】 阅读原文 [ 2598字 | 11分钟 ]

【原文作者】 AIGC开放社区

【摘要模型】 deepseek/deepseek-v3-0324

【摘要评分】 ★★★★☆