文章摘要

【关 键 词】 开源模型、多模态、AIGC、视觉助手、LLM

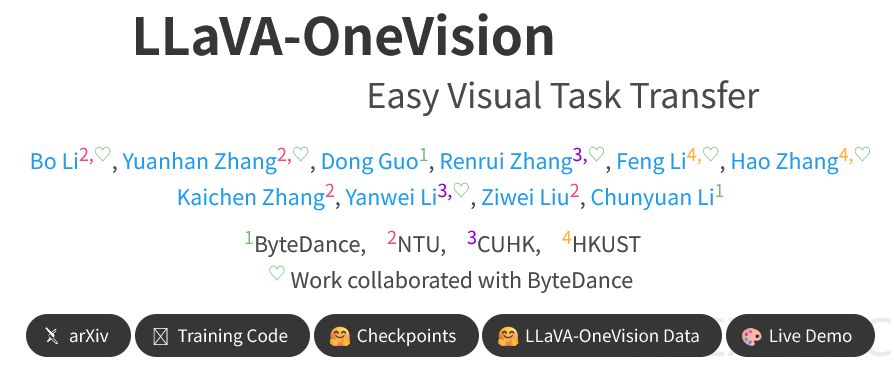

LLaVA(大型语言与视觉助手)的发展历程展现了开源社区在多模态模型领域的突破性进展。从2023年4月首次提出视觉指令微调方法,到2024年8月推出功能全面的LLaVA-OneVision,该系列模型通过不断提升图像分辨率、优化训练数据以及整合视频处理能力,逐步缩小了与闭源模型的差距。关键里程碑包括LLaVA-1.5在11个基准测试中刷新纪录,以及LLaVA-NeXT在多个测试中超越Gemini Pro的表现。

然而,开源社区面临的核心挑战在于模型复现的可行性。尽管LLaVA等项目推动了多模态接口的标准化,但完整训练数据、清洗策略等关键细节的披露不足,导致复现困难。为应对这一挑战,灵感实验室团队推出了LLaVA-OneVision-1.5,其核心目标是提供开放、高效且可复现的完整框架。该模型的训练分为三个阶段:语言-图像对齐、高质量知识学习和视觉指令微调。研究团队特别优化了训练效率,通过离线并行数据打包方法实现了11倍的压缩比,大幅提升了GPU利用率。

LLaVA-OneVision-1.5采用了创新的架构设计。视觉编码器选用RICE-ViT,该技术具备区域感知能力,尤其擅长处理文档和图片中的文字,并支持可变分辨率输入。语言模型则基于Qwen3,为复杂任务提供强大支持。在数据处理方面,团队引入了”概念均衡”采样策略,通过匹配图片与概念词条,确保模型知识覆盖的广泛性。预训练数据集包含8500万高质量图文对,指令微调数据集则覆盖七个任务类别,共计2200万样本。

性能测试显示,80亿参数的LLaVA-OneVision-1.5-8B在27个基准中的18个上超越了Qwen2.5-VL-7B,而40亿参数版本则在所有测试中优于Qwen2.5-VL-3B。消融研究验证了RICE-ViT在OCR任务中的优势,以及中期训练数据扩展对性能提升的重要性。LLaVA-OneVision-1.5不仅提供了强大的模型性能,更通过全面公开训练细节、工具链和配置,为多模态研究的可复现性树立了新标准。这一成果标志着开源社区在推动人工智能技术民主化方面迈出了重要一步。

原文和模型

【原文链接】 阅读原文 [ 2422字 | 10分钟 ]

【原文作者】 AIGC开放社区

【摘要模型】 deepseek/deepseek-v3-0324

【摘要评分】 ★★★★☆