文章摘要

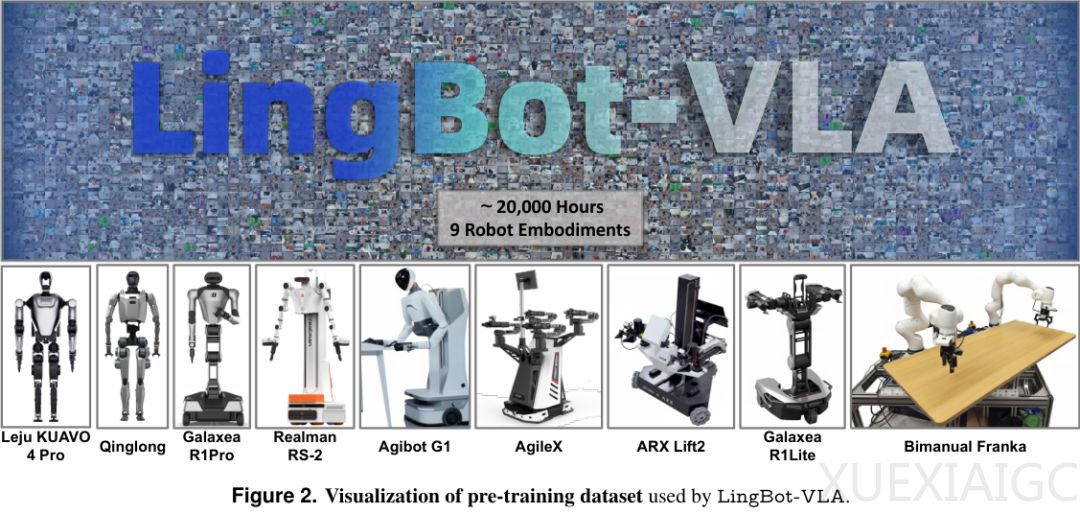

蚂蚁集团开源的具身智能基座模型LingBot-VLA标志着机器人学习领域的重要突破。该模型通过两万小时真机数据验证了机器人学习存在类似大语言模型的缩放定律,且性能提升尚未达到瓶颈。研究团队收集了涵盖9种主流双臂机器人配置的多样化操作数据,构建了一个极具挑战性的多模态数据集。实验表明,随着数据量从3,000小时增加到20,000小时,模型在下游任务中的成功率持续显著提升,且增长曲线未出现饱和迹象。

LingBot-VLA采用分层架构实现脑手协同,将视觉语言模型与动作生成模块巧妙结合。其核心是预训练的Qwen2.5-VL模型负责语义理解,而动作专家模块采用Flow Matching技术生成连续平滑的动作轨迹。混合Transformer架构确保了高层语义对动作的指导,同时避免了跨模态信号干扰。深度信息的引入显著增强了模型的空间感知能力,在处理堆叠物体等精细操作任务时表现突出。

在工程实现方面,团队重新打造了高性能训练基础设施,在8个GPU集群上实现每GPU每秒261个样本的吞吐量,速度较现有框架提升1.5到2.8倍。通过完全分片数据并行、混合精度训练和FlexAttention等优化手段,大幅提升了训练效率。严苛的实机测试显示,LingBot-VLA在三种不同机器人平台上均展现出压倒性优势,平均成功率提升4.28%,进度分提升7.76%。该模型还表现出极强的数据利用效率,仅需80次演示就能超越竞争对手130次演示的表现。

这项研究为通用机器人发展提供了务实范本,其开源策略将加速整个领域的探索步伐。随着数据量的指数级增长,具备实际工作能力的机器人有望更快进入日常生活。该成果不仅验证了数据规模对机器人智能的关键作用,也为解决机器人领域长期面临的泛化难题提供了可行方案。

原文和模型

【原文链接】 阅读原文 [ 2840字 | 12分钟 ]

【原文作者】 AIGC开放社区

【摘要模型】 deepseek/deepseek-v3-0324

【摘要评分】 ★★★★☆