文章摘要

【关 键 词】 机器人、人机协同、运动学习、数据翻译、零样本

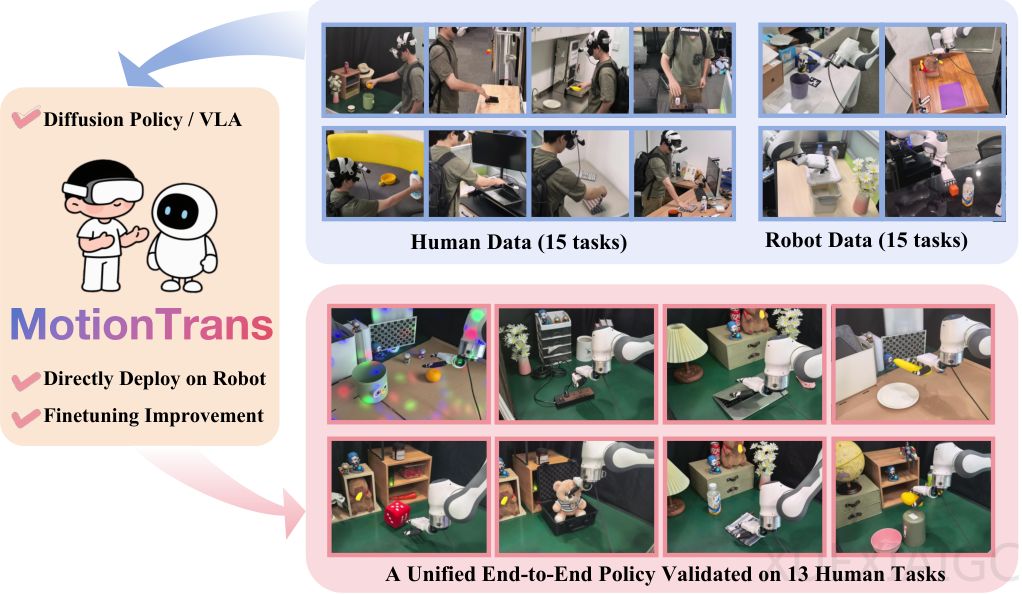

机器人学习领域取得突破性进展,通过人机协同训练框架MotionTrans实现了从人类演示到机器人执行的直接技能转移。该框架的核心创新在于建立了一个高效的翻译系统,能够将普通VR设备采集的人类动作数据转换为机器人可理解的格式。这项技术使机器人能够在零样本条件下学会全新的人类动作,无需预先接触相关机器人演示数据。

传统机器人模仿学习面临的核心困境是数据收集成本过高。训练一个功能完善的机器人需要海量高质量的机器人演示数据,这个过程既昂贵又耗时。为解决这个问题,研究者转向利用人类日常行为中蕴含的运动智慧。人类作为天生的操作大师,其行为数据具有无可比拟的价值,但过去的方法需要通过中间表示进行转换,导致细节丢失和学习流程复杂化。

MotionTrans框架通过三个关键步骤实现突破:数据采集、格式转换和协同训练。数据采集环节利用商用VR设备便捷地记录人类手部动作和第一人称视角图像,同时通过遥操作系统收集机器人数据。格式转换的创新点在于统一了人类和机器人的观察-动作空间,包括图像视角、手腕姿态坐标系和手部关节状态的标准化处理。训练阶段采用Diffusion Policy和π0-VLA两种先进的端到端策略架构,并创新性地使用统一的数据归一化标准。

实验结果令人振奋:在13个全新的人类任务中,机器人成功完成了9个。即使在失败的任务中,机器人也表现出正确的运动趋势,证明其确实掌握了任务的核心要素。更值得注意的是,经过MotionTrans预训练的模型,在仅使用5-20个机器人演示样本进行微调后,性能比从头训练的模型提升约40%。这证实了人机协同预训练为机器人学习提供了宝贵的运动先验知识。

深入分析揭示了运动转移的机制:机器人并非简单模仿人类动作,而是在自身安全操作范围内通过插值生成新动作。典型案例研究表明,当机器人同时学习低处和高处放置数据时,能够准确执行中等高度的放置任务,成功率高达80%。这证明人类数据提供了”做什么”的任务感知,而机器人数据则提供了”怎么做”的身体感知,两者的结合产生了强大的泛化能力。

该研究还发现,在预训练阶段,保持身体一致性比任务精确匹配更重要。视觉分析表明,模型能够跨越身体差异,准确识别任务相关物体。随着数据量增加,零样本性能持续提升,验证了数据多样性和规模对泛化能力的关键作用。

这项工作的开源策略将加速相关领域的研究进程。MotionTrans框架不仅证明了直接从人类数据进行运动级别学习的可行性,更为有效利用人类行为数据提供了系统性的解决方案,为人机协同学习开辟了新的可能性。其突破性的数据转换方法和训练策略,有望推动机器人操作能力实现质的飞跃。

原文和模型

【原文链接】 阅读原文 [ 4702字 | 19分钟 ]

【原文作者】 AIGC开放社区

【摘要模型】 deepseek/deepseek-v3-0324

【摘要评分】 ★★★★★