租了8张H100,他成功复现了DeepSeek的mHC,结果比官方报告更炸裂

文章摘要

【关 键 词】 AI技术、残差连接、模型复现、深度学习、信号放大

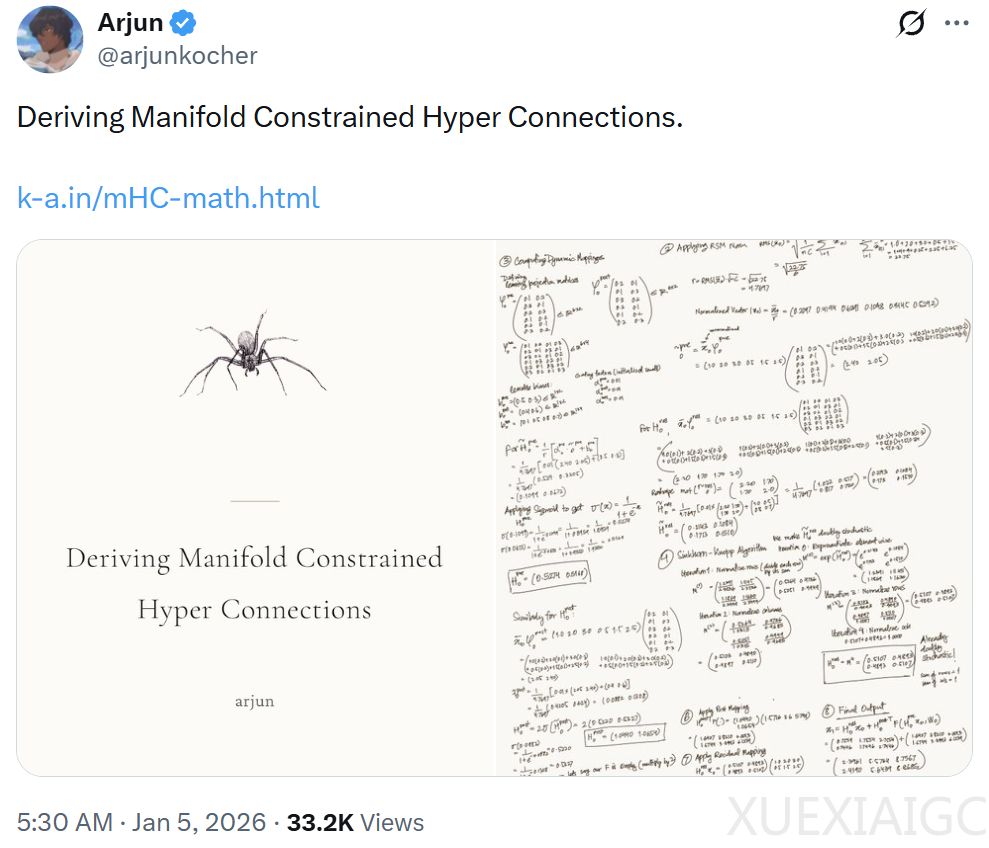

DeepSeek提出的mHC架构通过多流并行设计和双拟随机矩阵约束,解决了传统Transformer在大规模训练中的信号爆炸问题。传统残差连接采用单一信息流设计,而超连接(HC)扩展为多流并行架构,通过三个可学习矩阵控制信息流动。然而,不受约束的混合矩阵会导致信号呈指数级放大,在27B参数规模下出现3000倍的放大效应。mHC通过Sinkhorn-Knopp算法将混合矩阵约束为双拟随机矩阵,确保信息只能被路由和混合而不能被放大,从而维持了信号守恒。

FlowMode工程师Taylor Kolasinski的复现实验验证了mHC的稳定性优势。在10M参数规模下,HC虽然表现出更好的验证损失(0.88对1.12),但其信号放大倍数达到9.2倍,且不同种子间的方差是mHC的3倍。当参数规模扩大到1.7B时,HC的信号放大倍数飙升至10924倍,远超DeepSeek论文中报告的3000倍。值得注意的是,mHC在所有实验中均保持1.0的稳定放大倍数,且性能与HC相当,证明约束机制不会牺牲模型表现。

逐层分析显示,不稳定性主要源自网络第0层的混合矩阵。该层直接处理原始输入嵌入,缺乏前置的LayerNorm保护。在压力测试中,当学习率提高3倍时,深度64的HC模型出现14765倍的信号放大和剧烈振荡,而mHC始终保持稳定。尽管实验中HC模型未出现崩溃,但梯度裁剪和有限训练步数可能掩盖了潜在风险。趋势线预测显示,在100B参数规模下,HC可能产生40万倍的信号放大,这种不稳定性将无法通过常规技术手段控制。

实验还揭示了架构设计中的关键洞见:双重随机约束不是性能限制,而是规模化训练的必要保障。与2016年ResNet解决梯度消失问题类似,mHC通过主动约束解决了信号爆炸问题。这种守恒定律的强制执行,使得模型在参数量增长三个数量级(10M→1.7B)时仍能保持稳定。所有复现数据均显示,mHC在不同深度(24-48层)和不同随机种子下具有完全一致的行为模式。

技术实现方面,Sinkhorn投影仅需约20次迭代即可收敛,计算开销可忽略不计。工程师特别指出,该约束的代码实现仅需10行左右,却能消除大规模训练中最危险的故障模式。后续研究计划探索10B参数规模下的放大效应,预计可能观测到5万倍的信号放大,这将进一步验证mHC在超大规模模型中的必要性。完整代码和实验数据已通过W&B平台公开,为社区提供了可验证的研究基准。

原文和模型

【原文链接】 阅读原文 [ 4908字 | 20分钟 ]

【原文作者】 机器之心

【摘要模型】 deepseek/deepseek-v3-0324

【摘要评分】 ★★★★★