文章摘要

【关 键 词】 机器人、空间感知、开源模型、深度相机、具身智能

蚂蚁集团旗下灵波科技开源高精度空间感知模型LingBot-Depth,该模型在深度精度和像素覆盖率方面优于顶级深度相机。该技术突破解决了机器人空间定位的核心难题,特别是在处理透明、反光物体时,抓取成功率显著提升。实验数据显示,透明物体抓取成功率从0%提升至50%,反光物体抓取成功率提升30%~78%。LingBot-Depth通过算法创新弥补硬件短板,使消费级RGB-D相机实现接近专业设备的性能。

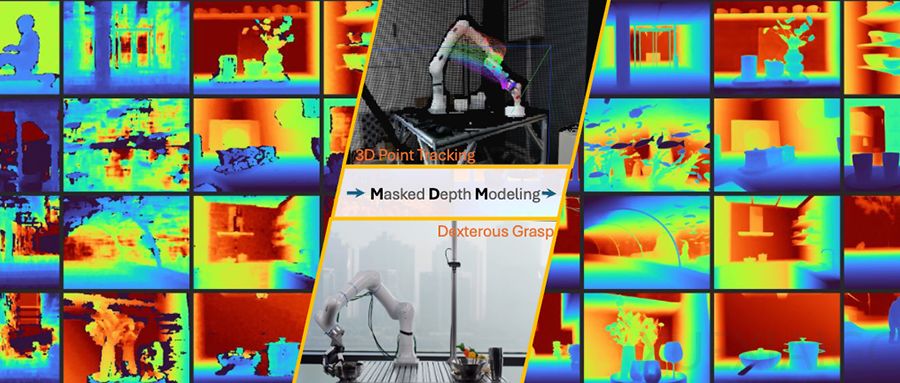

模型的核心创新在于掩码深度建模(MDM)机制,将传感器缺陷转化为训练素材,使AI学习真实物理规则而非人工编造的逻辑。这一方法在NYUv2、ETH3D等基准测试中表现优异,室内场景相对误差降低70%,稀疏SfM任务均方根误差降低47%。MDM框架支持从任意RGB-D输入生成高精度深度图,为机器人提供稳定的空间感知能力。

技术实现依托于大规模数据训练,包括100万合成样本和200万真实样本,构建了千万级多样化训练集。研究人员采用ViT-Large模型进行预训练,将几何信息融入语义标记,显著提升感知质量。实际测试中,配备该模型的机械臂在透明物体抓取任务中展现出突破性性能,验证了技术的实用价值。

开源策略是本次技术推广的关键,灵波科技不仅公开模型代码和检查点,还计划发布300万RGB深度对数据集。这一举措可能推动RGB-D相机硬件优化,增强模型在复杂场景中的鲁棒性。从行业影响看,该技术降低了高精度空间感知的实现门槛,为机器人导航、自动驾驶等应用提供了基础支撑。

技术的突破性体现在三个方面:首先,解决了传统深度相机在反光、无纹理表面的失效问题;其次,通过算法提升使低成本设备达到专业级性能;最后,开源生态加速了技术迭代和应用落地。LingBot-Depth标志着具身智能向人类级空间理解迈出重要一步,为机器人自主操作奠定了感知基础。随着技术普及,未来智能设备在复杂环境中的适应能力将得到质的飞跃。

原文和模型

【原文链接】 阅读原文 [ 3248字 | 13分钟 ]

【原文作者】 机器人前瞻

【摘要模型】 deepseek/deepseek-v3-0324

【摘要评分】 ★★★★★