文章摘要

【关 键 词】 AI训练、学习方法、强化学习、模型优化、智能反思

Thinking Machines Lab的最新研究《On-Policy Distillation》提出了一种颠覆性的AI训练方法,旨在通过实时指导优化模型的学习过程。传统训练方式分为监督微调(SFT)和人类反馈强化学习(RLHF)两个独立阶段,但二者存在内在矛盾:SFT要求模型模仿既有数据,RLHF则鼓励探索新答案,导致模型在保守与冒进间摇摆。该团队由OpenAI前CTO Mira Murati领衔,核心成员包括RLHF技术先驱,其研究聚焦于“如何让AI更高效学习”这一根本问题。

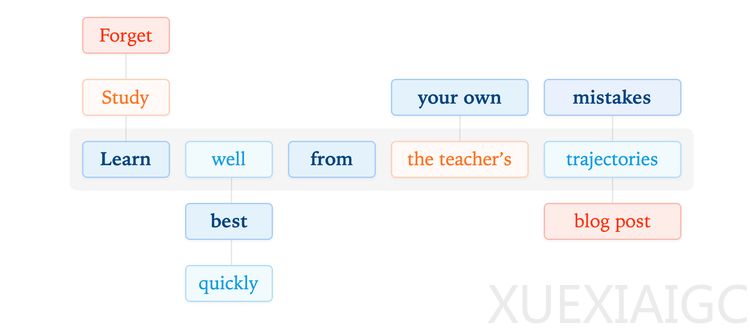

传统蒸馏训练依赖教师模型提供完美答案供学生模仿,而新方法“政策内蒸馏”让学生模型在自主生成内容时获得实时反馈。这种”边行动边学习”的机制,将反馈粒度细化到每个生成标记(token),如同写作教师逐句批改而非仅给总分。研究团队将此称为“用微镜头监督AI思考过程”,通过密集监督(dense supervision)显著提升学习效率。实验显示,该方法在AIME’24数学基准测试中超越传统RLHF模型,同时降低算力需求并增强训练稳定性。

这项研究标志着AI训练范式的哲学转向——从依赖海量数据模仿,转向引导模型反思自身行为轨迹。传统方法侧重统计规律的学习,而新方法培育的是“自我改进型智能体”,使AI能在实践中持续优化决策路径。这种转变的价值不在于增加算力,而在于重构学习机制本身,为实现真正具备反思能力的智能系统奠定基础。当AI开始理解”为何这样决策”而非仅复制结果时,可能预示着机器智能从”语言模仿”到”思维构建”的第二次觉醒。

原文和模型

【原文链接】 阅读原文 [ 1290字 | 6分钟 ]

【原文作者】 硅星人Pro

【摘要模型】 deepseek/deepseek-v3-0324

【摘要评分】 ★☆☆☆☆