文章摘要

【关 键 词】 谷歌、视频模型、多图参考、人物一致性、中文支持

谷歌发布了Veo 3.1视频生成模型,虽然是小版本迭代,但在多个用户场景中实现了显著改进。新版本支持多图参考和首尾帧功能,音频效果与画面纹理质量均有提升。其中,人物一致性表现突出,同一人物在不同角度下能保持高度统一,解决了以往版本中人物形象跳脱的问题。不过,中文支持仍然不足,提示词和音效的中文适配效果较差。

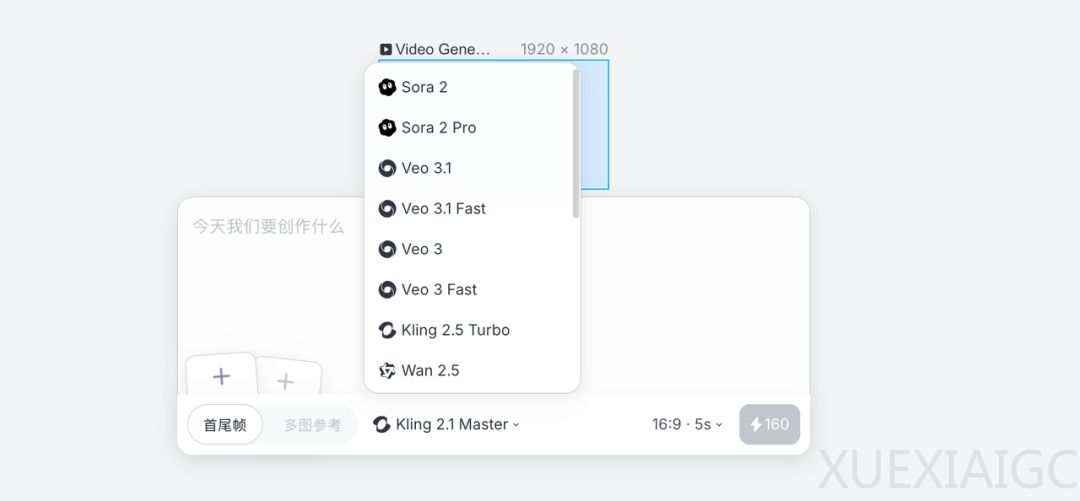

测试发现,Veo 3.1的画面真实感和光影层次明显优于其他模型,尤其在人物表情细节和环境音效方面表现突出。例如,生成的骑马场景中,马蹄声与风声的混合增强了场景立体感。但相比之下,Sora 2在分镜切换上更具优势,能通过时间戳指令实现自然的镜头衔接,适合叙事类视频创作。不同模型各有所长:Sora 2擅长分镜叙事,Veo 3.1侧重质感还原,Kling 2.5 Turbo则在动态流畅度上表现更佳。

Lovart平台作为多模型集成工具展现出独特价值。用户无需切换界面即可对比不同模型的生成效果,例如在制作”梵高走进咖啡馆”短片时,可分别调用Sora 2处理分镜、Veo 3.1制作特写、Kling 2.5 Turbo表现人物走动。该平台还支持多图参考功能,允许用户上传多张图片融合生成视频,显著降低了创作门槛。测试中,将西部牛仔图片与不同场景结合时,模型能准确保持人物特征并生成符合物理规律的光影效果。

AI视频创作正呈现出专业化分工趋势。创作者团队尝试通过组合多个模型制作完整短片,发现不同模型在氛围渲染、动作细节等方面各具特色。这种”工具组合”的创作方式类似于电影导演选择不同镜头和滤镜,关键在于根据场景需求选择最适合的模型。Lovart的年度会员服务提供了稳定的生成环境和无限额度,支持从分镜设计到最终输出的全流程创作。

当前AI视频领域仍存在明显技术红利,相比饱和的传统短视频赛道,AI视频更注重镜头语言和叙事能力而非表演技巧。随着多模型协作工作流的成熟,该领域可能迎来内容爆发期。不过,语言支持(特别是中文)的局限性和部分动作细节的不自然,仍是需要突破的技术瓶颈。测试表明,与两年前相比,现有模型已能生成近乎真实的视频片段,标志着该技术正快速向实用化方向发展。

原文和模型

【原文链接】 阅读原文 [ 3659字 | 15分钟 ]

【原文作者】 AI产品阿颖

【摘要模型】 deepseek/deepseek-v3-0324

【摘要评分】 ★★★★★