文章摘要

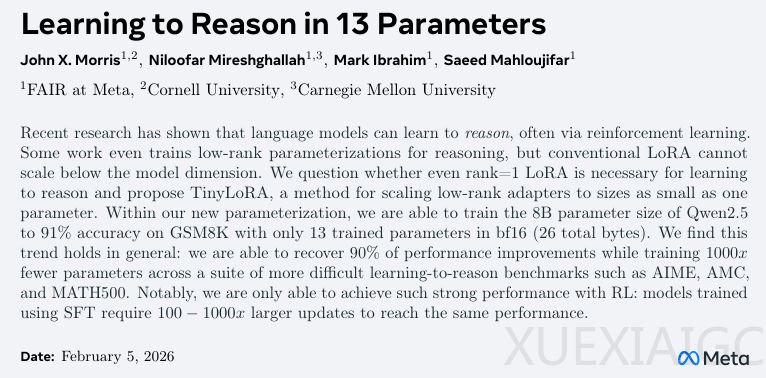

Meta FAIR等机构研究人员开发出一种名为TinyLoRA的极致微调技术,仅需调整13个参数(26字节)即可显著提升大语言模型的数学推理能力。该方法配合强化学习框架,使80亿参数模型的解题准确率从76%飙升至91%,挑战了传统模型训练对海量数据需求的认知,揭示了大模型内部潜在知识结构的可激发性。

传统微调方法如LoRA需要调整数百万参数,而TinyLoRA通过跨层共享微小可训练向量实现极致压缩。其核心创新在于使用固定随机投影将单一向量的影响力分配到所有目标层,极端情况下仅需1个参数即可完成百亿规模模型的定向调整。研究表明,这种”螺丝刀式”微调在强化学习环境下效果尤为显著——使用GRPO算法的Qwen2.5-7B模型,13个参数即实现15%准确率提升,而监督微调同等条件下仅改善7%。

实验数据显示,模型规模与微调效率呈正相关:Qwen2.5-7B仅用1个参数就在GSM8K任务上获得5%提升,而LLaMA-3需要10倍参数量才能达到相近效果。在优化设计方面,平铺式参数共享策略优于模块化共享,且fp32精度虽占用双倍存储却带来更优性能,表明超小型参数对数值精度异常敏感。

该方法在复杂数学数据集上展现强大泛化能力,196个参数的微调即可保留完整微调87%的性能增益。研究揭示大模型预训练阶段可能已编码解题核心知识,微调更多是调整输出风格而非注入新知识。这种机制在数学推理等答案明确的任务中效果显著,但在创造性领域仍需验证。

技术突破带来两点重要启示:模型定制化的存储计算门槛将大幅降低,未来部署专业模型可能仅需传输几KB的适配器;同时深化了对知识表征的理解,表明精准的微小干预有时比大规模参数更新更有效。该成果为万亿参数时代的模型控制提供了新思路,但其应用边界仍需在更广泛任务场景中探索验证。

原文和模型

【原文链接】 阅读原文 [ 2312字 | 10分钟 ]

【原文作者】 AIGC开放社区

【摘要模型】 deepseek/deepseek-v3-0324

【摘要评分】 ★★★★★