18个月,中国Token消化狂飙300倍!别乱烧钱了,清华系AI Infra帮你腰斩API成本

文章摘要

【关 键 词】 大模型、API服务、智能路由、评测体系、基础设施

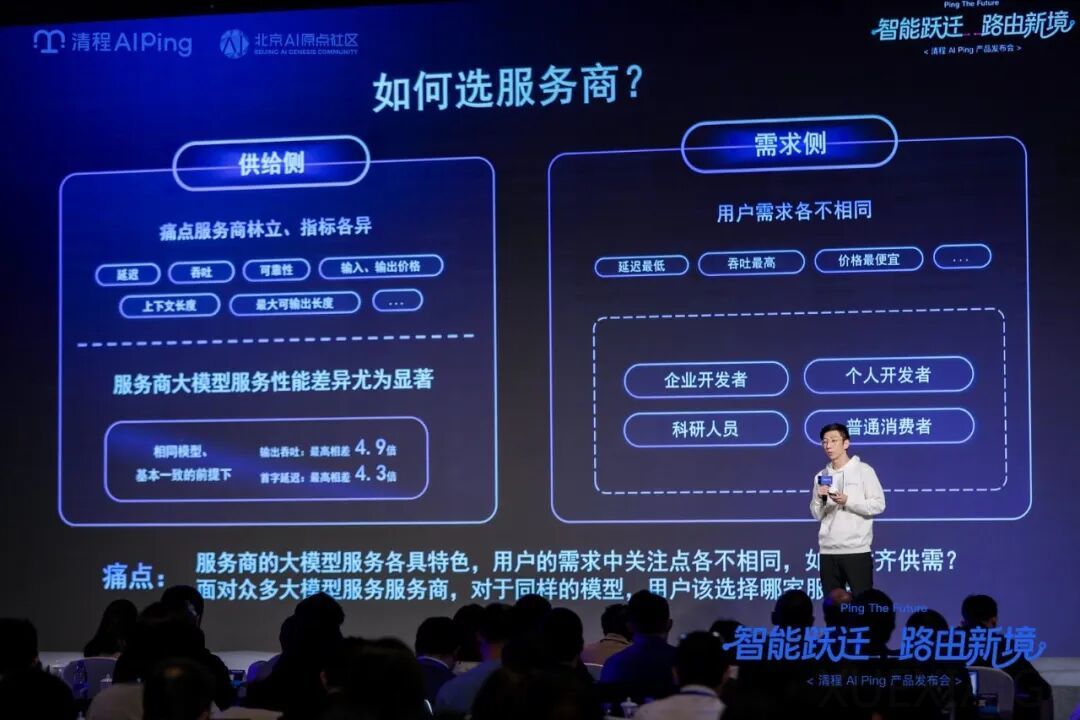

中国大模型API服务市场正面临严重的”黑盒”焦虑,服务碎片化和不透明性导致开发者面临巨大挑战。数据显示,中国大模型数量已超过1500个,日均Token消耗量从2024年初的1000亿飙升至2025年6月的30万亿,增长超过300倍。然而,当前API服务存在严重的不确定性,模型性能波动大,服务质量参差不齐,开发者往往难以判断实际调用的模型版本和配置。

清程极智推出的AI Ping平台试图通过评测与路由两大机制解决这些问题。该平台已接入30家主流服务商,覆盖555个模型接口,能够对大模型服务进行持续评测与公开展示。其核心功能包括:实时评测模型服务质量、智能路由选择最优服务商、动态调整调用策略。测试显示,该系统可使整体正确率超过单一旗舰模型,同时调用成本下降超过50%。

AI Ping的技术核心在于构建了”全维度评测体系、服务商级智能调度、多模型智能路由”的三角闭环。评测系统采用7×24小时持续观测,确保数据实时性;路由系统则具备预判能力,能根据实时数据动态调整调用策略。这种”自动驾驶”式的调度机制,在实测中使整体吞吐量提升约90%,成本下降37%。

该平台的应用效果已在多个场景得到验证。在ToB智能客服领域,开发者得以摆脱选型内耗;在成本敏感场景,独立开发者能精准匹配性价比最优方案;在多模型协作场景,调度能力直接提升了商业可行性。值得注意的是,这套评测体系正在反向重塑服务商行为,推动行业竞争从价格战转向服务质量比拼。

专家认为,智能路由将成为下一代AI基础设施的关键组件。中国工程院院士郑纬民指出,当模型路由、服务路由、芯片调度完全打通后,用户只需提出需求,智能将像电力一样被高效调用和分发。这种基础设施的演进,有望从根本上解决当前大模型API服务的碎片化和不确定性难题。

原文和模型

【原文链接】 阅读原文 [ 4660字 | 19分钟 ]

【原文作者】 机器之心

【摘要模型】 deepseek/deepseek-v3-0324

【摘要评分】 ★★★★★