文章摘要

【关 键 词】 人工智能、分布式系统、安全框架、多代理协作、风险管理

通用人工智能(AGI)的发展路径可能并非依赖单一超级智能模型,而是通过多个专业化子模型的协作实现。谷歌DeepMind团队近期提出的分布式AGI安全框架挑战了传统AI对齐研究的基本假设,指出当前领域过度关注单体智能体的安全性,而忽视了多代理系统可能引发的集体风险。拼凑型AGI(Patchwork AGI)假说认为,通用智能将首先由具备互补技能的代理群体协作涌现,这种去中心化架构在技术上和经济性上都比单体模型更具优势。

技术扩散的历史规律显示,随着代理间通信协议(如MCP)的标准化,集成摩擦的降低将推动代理经济进入超速增长阶段,其演化速度可能超越安全设施的建设节奏。在具体应用场景中,复杂任务可被拆解为由不同专业代理协作完成:编排者代理协调工作流,搜索代理获取信息,解析代理提取数据,分析代理执行计算,最终整合成完整输出。这种系统展现的能力远超个体代理之和,但也带来了非线性风险和突发行为,包括串谋、协调失灵和追责困难等挑战。

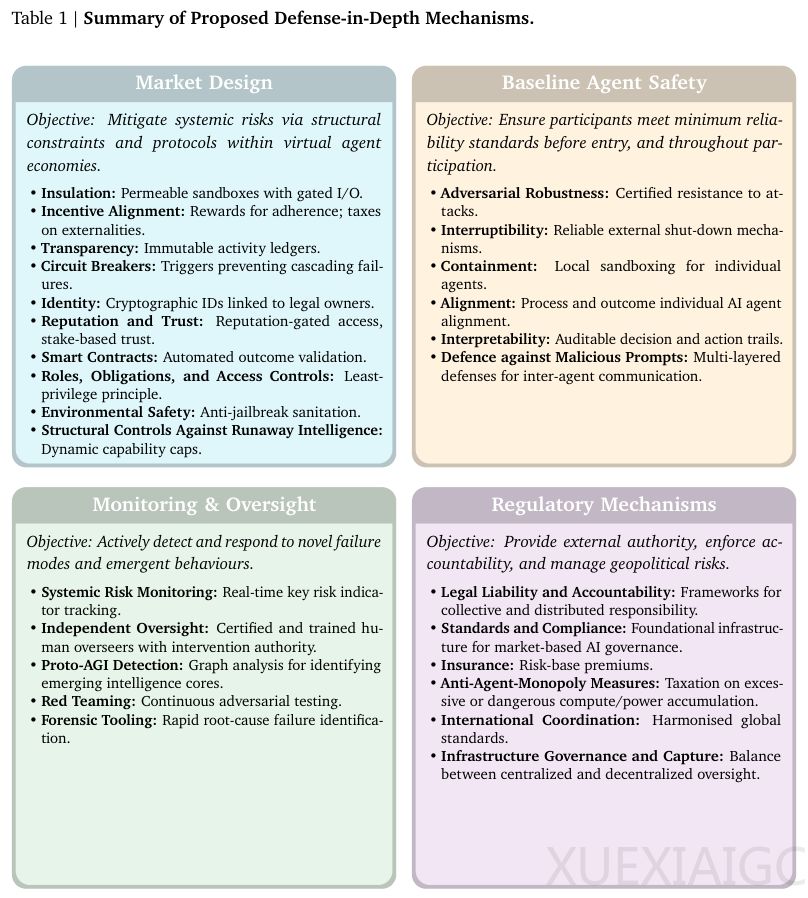

为应对这些风险,DeepMind提出四层深度防御体系。市场设计层面通过结构性约束管理系统性风险:隔离沙盒环境确保可控运行,激励对齐机制引导合规行为,透明化审计追踪决策链条,断路器机制自动阻断异常活动。身份管理系统要求每个代理具有唯一加密标识,智能合约则嵌入自动化核验逻辑。基准代理安全层设定准入门槛,要求个体具备对抗鲁棒性、可中断性和容器化隔离能力。监测监督层部署实时跟踪系统,通过AI监督AI的模式识别恶意串谋,红队测试扩展为集体压力测试,取证工具重建复杂因果链。监管机制层建立法律责任框架,引入保险制度和反垄断措施,并通过国际协调防止监管套利。

该框架将安全重心从黑箱认知过程转向透明互动系统的监管,通过市场规则设计实现对分布式智能的治理。其有效性依赖于基础设施的抗捕获性,要求核心组件如身份验证中心具备高度可靠性。当前大语言模型通过API互联展现的协作趋势,已预示分布式AGI的雏形。未来AGI可能演化为专业代理组成的数字社会,其安全性取决于当前对运行规则的设计,这要求研究视野从单体智能转向复杂智能网络。该框架为智能爆炸场景提供了兼具理论支撑和实践路径的解决方案,强调通过系统性规则设计维持人类对数字未来的理解力、干预权和问责能力。

原文和模型

【原文链接】 阅读原文 [ 3702字 | 15分钟 ]

【原文作者】 AIGC开放社区

【摘要模型】 deepseek/deepseek-v3-0324

【摘要评分】 ★★★★☆