Adam的稳+Muon的快?华为诺亚开源ROOT破解大模型训练「既要又要」的两难困境

文章摘要

【关 键 词】 LLM优化、自适应学习率、矩阵感知、鲁棒性、梯度噪声

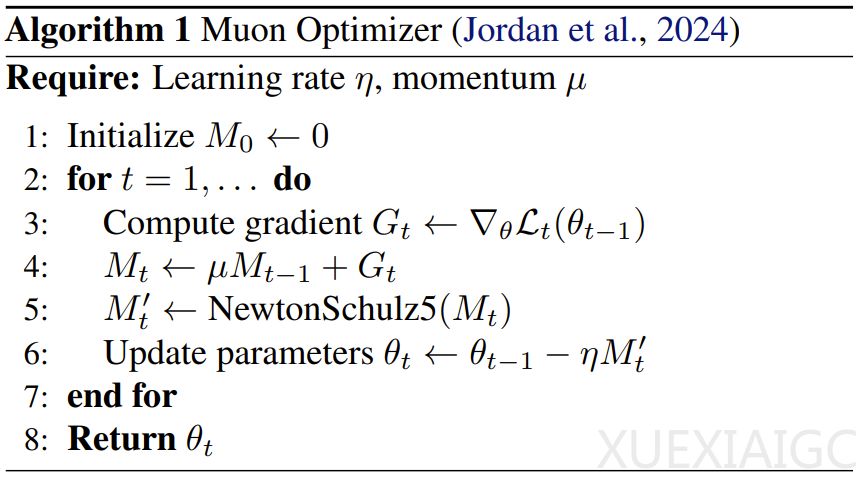

在LLM优化领域,传统方法如Adam和新兴方法Muon各有优劣。Adam凭借动量和自适应学习率成为深度学习的主流选择,但在处理十亿级参数的混合精度训练时存在数值不稳定性问题。Muon通过将权重矩阵视为整体进行优化,提升了训练效率和显存利用率,但其固定系数设计和异常值敏感性导致鲁棒性不足。

华为诺亚方舟实验室提出的ROOT优化器,通过两大核心创新解决了这些问题。首先,针对Muon的维度脆弱性,ROOT采用自适应Newton-Schulz迭代(AdaNewton),为不同维度的矩阵定制细粒度系数,显著提升了正交化精度。其次,针对梯度噪声问题,ROOT引入软阈值机制,将梯度分解为基础分量和异常分量,有效抑制了异常值对训练稳定性的影响。

实验结果表明,ROOT在预训练和下游任务中均表现出色。在10B token的大规模预训练中,ROOT的训练损失始终低于Muon,最终达到2.5407,比Muon低0.01。在下游任务基准测试中,ROOT的平均分为60.12,优于AdamW(59.05)和Muon(59.59)。此外,ROOT在计算机视觉任务中也展现了强大的泛化能力,在CIFAR-10数据集上的Top-1准确率达到88.44%,显著高于Muon的84.67%。

ROOT的提出标志着优化器领域的重要突破。它不仅解决了现有方法的局限性,还为未来大规模语言模型的训练提供了更高效、更稳定的解决方案。其开源代码将进一步推动相关研究和应用的发展,有望成为下一代AI系统训练的新标准。

原文和模型

【原文链接】 阅读原文 [ 3428字 | 14分钟 ]

【原文作者】 机器之心

【摘要模型】 deepseek/deepseek-v3-0324

【摘要评分】 ★★★☆☆