DeepSeek的新模型很疯狂:整个AI圈都在研究视觉路线,Karpathy不装了

文章摘要

【关 键 词】 大模型、视觉压缩、开源模型、OCR技术、上下文效率

DeepSeek团队推出的DeepSeek-OCR模型通过视觉token压缩技术实现了文本处理效率的突破性提升。该模型将1000字文本压缩为100个视觉token,在保持97%精度的同时实现十倍压缩率,单块A100显卡日处理量可达20万页数据。这一技术路径可能彻底改变大语言模型的输入范式,使像素级输入取代传统文本token成为更高效的选择。

OpenAI联合创始成员Andrej Karpathy指出,视觉输入具有多重优势:更高的信息压缩率带来更短的上下文窗口需求,统一的视觉处理流程可同时兼容文本格式信息(如加粗、颜色)和图像内容,且能彻底消除分词器带来的技术债务。纽约大学谢赛宁教授对此表示认同,认为这种思路与人类视觉记忆机制存在相似性——人们回忆文字时往往依赖页面位置等空间信息。

技术分析显示,传统视觉token在表示文本时效率低下,1万英文单词需3-6万个视觉token,而DeepSeek的技术将其压缩至约1500个。这种突破性压缩效率若与稀疏注意力机制结合,可能将模型上下文窗口扩展至千万token级别,实现企业级文档全量缓存或完整代码库的实时处理。研究者推测谷歌Gemini模型可能已采用类似技术,而DeepSeek选择完全开源的做法加速了领域发展。

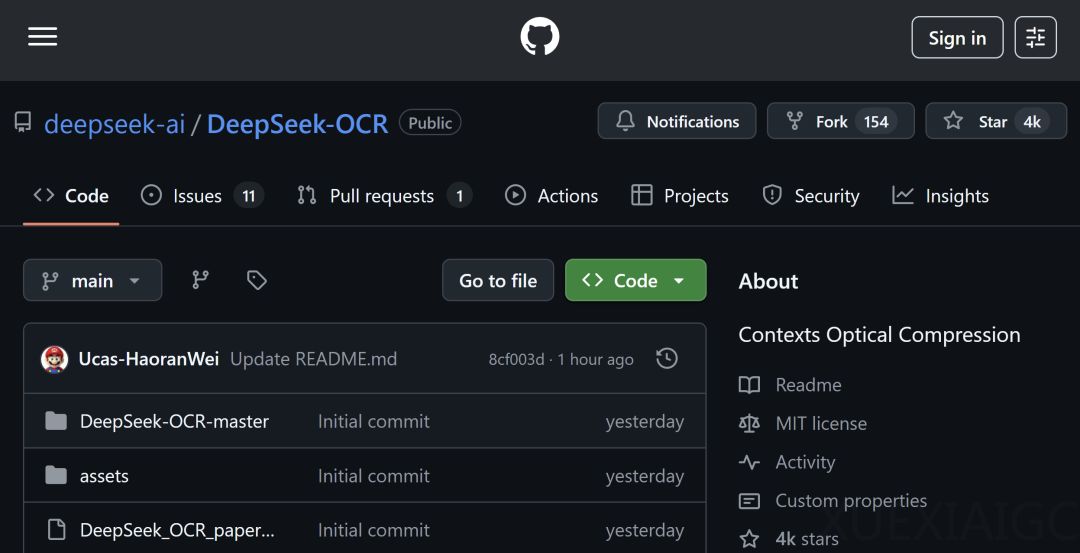

社区验证方面,该模型在GitHub上线首日即获4000+星标,开发者已成功在多种硬件环境部署。但批评者指出该方法与人类渐进式认知存在差异,且技术渊源可追溯至2022年《Language Modelling with Pixels》提出的PIXEL架构。后续CVPR、NeurIPS等会议的多篇论文持续发展了视觉语言模型方向,显示该领域存在持续创新。

核心争议在于视觉压缩是否会影响模型的语言推理能力,以及这种技术路径能否真正扩展至通用智能场景。尽管存在质疑,DeepSeek-OCR展现的工程突破仍被视为解决长上下文效率问题的可行方案,其开源策略将进一步推动相关技术的验证与优化。

原文和模型

【原文链接】 阅读原文 [ 2646字 | 11分钟 ]

【原文作者】 机器之心

【摘要模型】 deepseek/deepseek-v3-0324

【摘要评分】 ★★★★★