文章摘要

【关 键 词】 AI模型、数学推理、自我验证、竞赛表现、反思能力

DeepSeekMath-V2的发布标志着数学专用AI模型的重大突破。这个基于DeepSeek-V3.2-Exp-Base构建的685B参数模型,不仅能够解答数学问题,还能通过自我验证机制检查解题步骤的正确性。其独特之处在于采用了生成器-验证器双系统架构,使AI具备了类似人类的反思能力。生成器负责提出解题方案,而验证器则严格审查每一步推理过程,甚至还有元验证机制来监督验证器的工作质量。

在数学竞赛表现方面,该模型展现出惊人实力:在2025年国际数学奥林匹克竞赛(IMO)模拟赛中解决了5/6的题目,在2024年普特南数学竞赛中获得了接近满分的118/120分。这些成绩不仅达到了人类金牌选手水平,在某些方面甚至超越了人类最佳表现。特别是普特南竞赛中118分的成绩,远高于去年人类选手的90分最高分。

这一突破性进展恰逢AI领域关于模型能力的重要讨论。前OpenAI首席科学家Ilya Sutskever近期提出的担忧指出,当前AI在评测中表现出色但实际应用能力有限,存在”应试型智能”与”通用智能”的鸿沟。DeepSeekMath-V2的设计理念似乎回应了这一担忧,通过培养AI的内在反思能力而非单纯优化外部指标,实现了推理质量的实质性提升。

该模型的技术创新主要体现在过程导向的训练方法上。与以往结果导向的AI不同,它强调解题过程的严谨性,通过生成器与验证器的对抗学习,使AI逐步发展出批判性思维能力。这种设计使模型能够发现并修正自己推理中的错误,最终产生逻辑严密的数学证明。

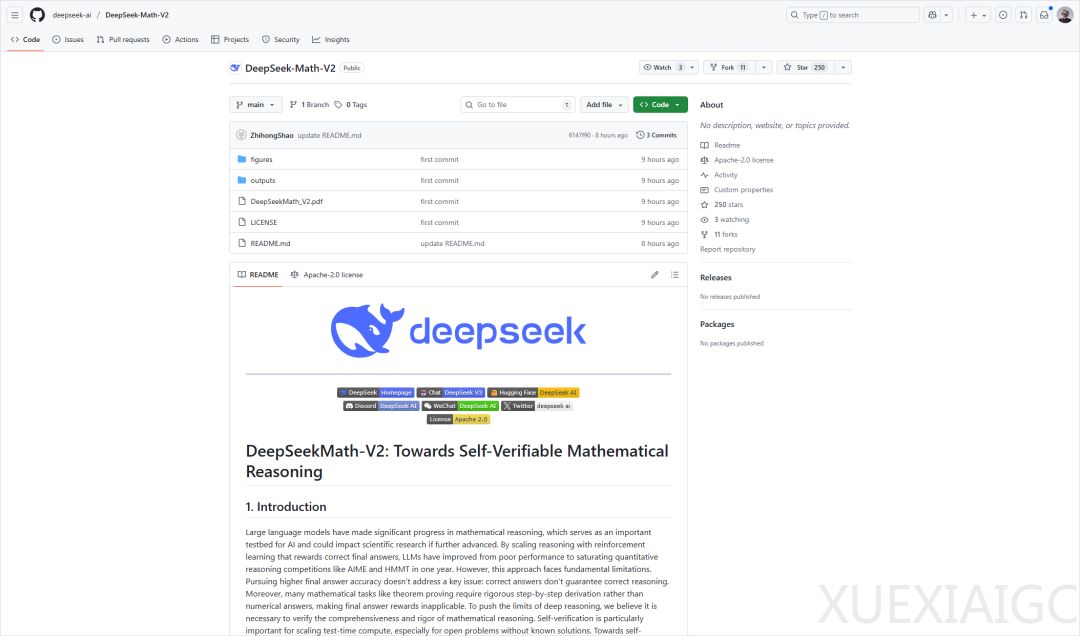

论文《DeepSeekMath-V2: Towards Self-Verifiable Mathematical Reasoning》详细阐述了这一技术路径,并遵循DeepSeek的传统保持开源。这一工作不仅提升了AI的数学能力,更探索了智能本质的哲学问题,即如何使AI从追求外部奖励转向追求内在逻辑自洽。这种”向内看”的能力发展路径,可能为弥合AI评测表现与实际应用之间的差距提供了新思路。

原文和模型

【原文链接】 阅读原文 [ 3186字 | 13分钟 ]

【原文作者】 数字生命卡兹克

【摘要模型】 deepseek/deepseek-v3-0324

【摘要评分】 ★★★★★