文章摘要

【关 键 词】 人工智能、大模型、注意力机制、技术路线、行业竞争

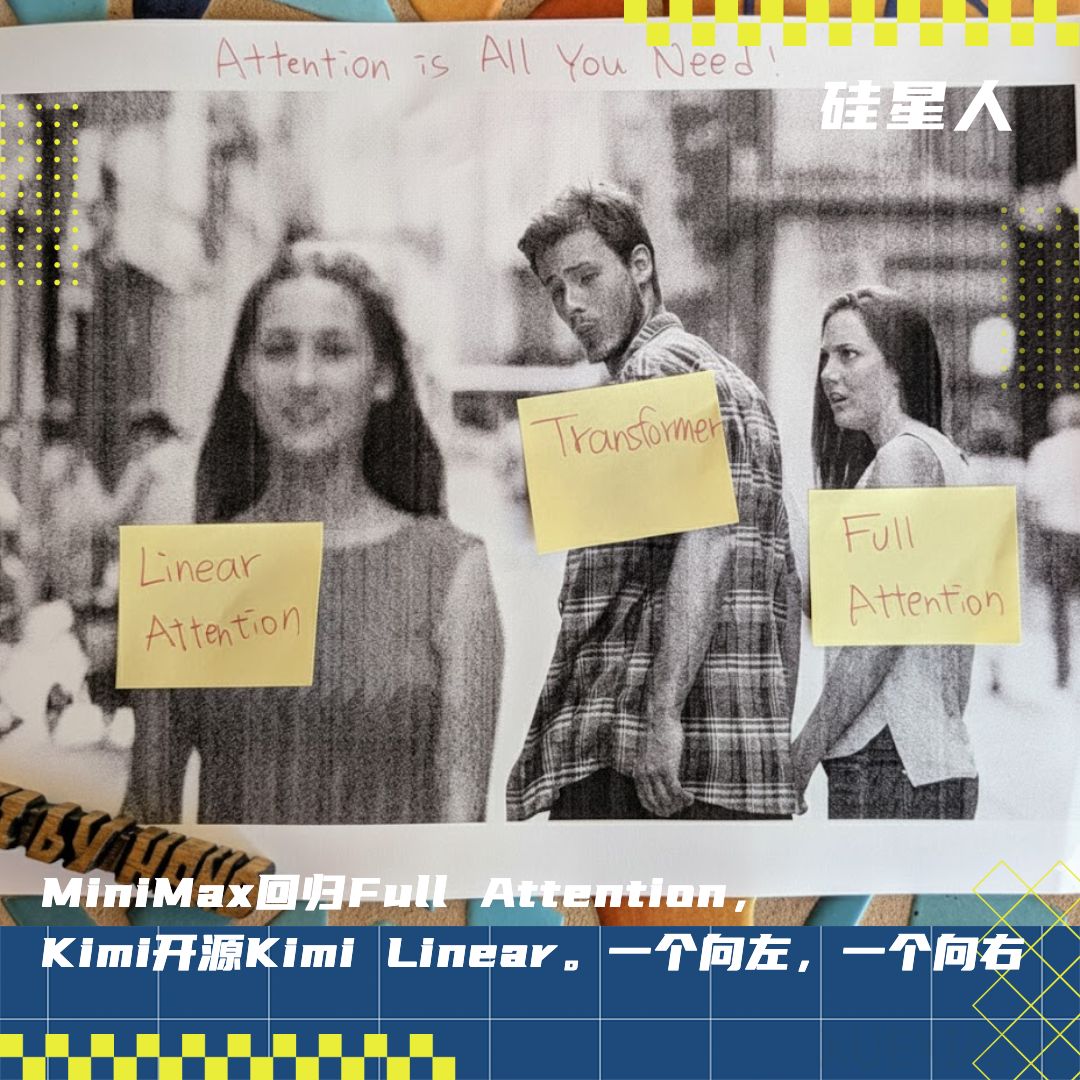

MiniMax和月之暗面在大模型技术路线上展现出截然不同的选择,引发了行业对注意力机制效率与性能平衡的深入探讨。MiniMax在M2模型中回归Full Attention架构,强调通过工程优化实现智能、速度与成本的最佳平衡。其预训练负责人孙浩海详细阐述了放弃高效注意力的三大核心困难:工程链路复杂性爆炸、评测体系局限以及基建不完善。这些挑战揭示了现代大模型需要同时支持多种应用场景时面临的实际困境,也反映了行业在验证新算法时普遍存在的Benchmark困境。

月之暗面在MiniMax发布72小时后迅速推出Kimi Linear模型,以48B参数的混合架构实现技术突破。该模型采用创新的Kimi Delta Attention(KDA)机制,通过通道级门控实现精细记忆控制,在保持性能的同时显著提升效率。3:1的KDA与MLA混合比例经过系统验证,被证明是平衡性能与效率的最佳点。模型还采用无位置编码设计,带来推理效率提升、训练简化和长上下文泛化优势。实验数据显示,Kimi Linear在KV Cache减少75%的情况下,吞吐量提升6倍,首次在公平对比中全面超越全注意力模型。

这两种技术路线代表了行业在效率与性能之间的不同权衡。MiniMax选择等待GPU进步解决Full Attention的成本问题,而月之暗面则通过架构创新主动优化效率。MiniMax的策略基于对工程复杂性的审慎评估,认为当前阶段Full Attention仍是经过充分验证的可靠选择。月之暗面的技术突破则证明,经过系统性工程化解决,高效注意力机制可以实现与Full Attention相当甚至更优的性能。

这场技术路线之争不仅关乎算法选择,也反映了中国头部大模型企业的战略差异。MiniMax和月之暗面在长上下文、代码/Agent等领域的同场竞技,使技术讨论与实际商业竞争相互交织。两家公司的公开技术分享为行业提供了宝贵参考,展示了不同技术路径的优缺点和实现细节。这种开放的技术探讨有助于推动整个大模型领域的发展,而最终的路线选择可能需要根据具体应用场景和资源条件做出判断。

原文和模型

【原文链接】 阅读原文 [ 2734字 | 11分钟 ]

【原文作者】 硅星人Pro

【摘要模型】 deepseek/deepseek-v3-0324

【摘要评分】 ★★★★☆