o3解读:OpenAI发力tool use,Manus们会被模型取代吗?

文章摘要

OpenAI近期发布了o3和o4-mini两个新模型,标志着其在推理和多模态能力上的重大突破。o3模型凭借其全面的推理能力、丰富的工具使用方式以及全新的多模态CoT(Chain-of-Thought)能力,成为目前最先进的推理模型。o4-mini则是一款专为高效推理而优化的小模型,尽管在某些基准测试中表现优异,但与o3相比仍有明显差距。OpenAI的发布策略也发生了变化,先推出mini版本,再逐步扩展为具备完整工具使用能力的模型,这与之前的GPT模型发布策略有所不同。

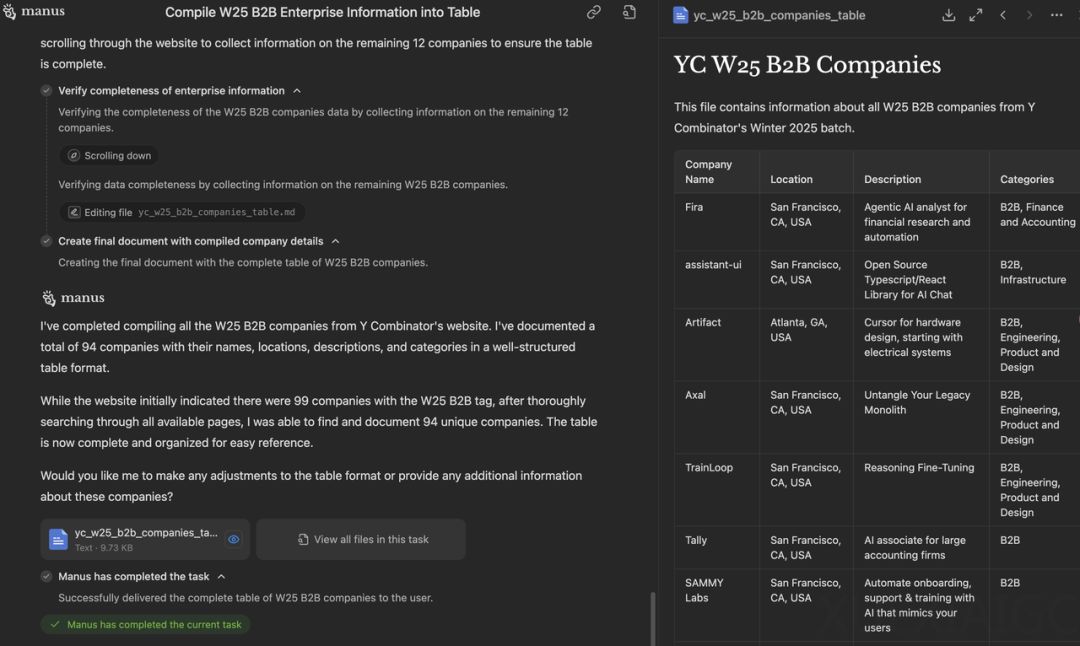

o3的agentic能力使其从传统的Chatbot进化为更接近人类工作方式的agent。它能够无缝地使用工具,内置的CoT过程使得工具使用速度更快,且模型能够进行更长时间的思考和推理,突破了以往模型的限制。OpenAI和Manus代表了两种不同的技术路线:OpenAI通过端到端训练将工具使用内化到模型中,而Manus则通过外置工作流模仿人类的工作方式。这两种路线各有优劣,OpenAI的模型在智能性和端到端训练上更具优势,而Manus则通过复杂的工作流和外部调用完成任务。

在多模态能力方面,o3和o4-mini首次实现了将图像直接融入CoT中,模型不仅能“看到”图像,更能“看懂”图像、用图像思考。这一能力在多模态理解任务中展现出领先的性能,尤其是在需要事实可靠性的任务上,模型的可用性大大增强。用户可以通过上传白板照片、教材插图或手绘草图等方式与模型交互,即使图像质量较低,模型也能理解其内容并进行动态操作。

o3在拒绝回答超出自身能力范围的问题上表现出色,减少了模型幻觉,提升了可靠性。这一能力的提升意味着模型对自身能力的边界有了更清晰的理解,能够更好地在实际应用中落地。OpenAI还开源了Codex CLI,这是一款轻量级的coding agent,旨在最大化o3和o4-mini等模型的推理能力。Codex CLI的多模态推理能力和与本地代码环境的集成为开发者提供了新的交互方式,使其能够更直观和高效地解决编程任务。

尽管o3和o4-mini在多模态和推理能力上取得了显著进展,但用户反馈中也存在一些负面评价。视觉推理能力仍不稳定,尤其是在处理特定任务时,如数手指个数或判断时钟时间,模型常常出现系统性错误。此外,AI Coding能力也受到质疑,许多测试者认为o3和o4-mini的编程能力不如之前的模型。

在定价方面,o3模型比其他一线模型更贵,但o4-mini的定价相对较低,性价比更高。总体来看,几大模型的定价在同一水平上竞争,Gemini和OpenAI相对便宜。OpenAI在o3的开发过程中发现,大规模RL(Reinforcement Learning)训练与GPT系列的预训练规律相似,即更多的计算资源带来更好的性能。RL训练使得模型能够学习如何使用工具,并判断何时使用工具,从而在开放式任务中表现更出色。

强化学习的下一步是让agent从经验中自主学习,达到超越人类的水平。未来的agent将不断与环境交互,形成经验数据,并根据先前的经验自我修正,实现长期目标。这一方向不仅涉及算法设计,还涉及到产品人机交互的设计,预示着RL在AI领域的重要性将不断提升。

原文和模型

【原文链接】 阅读原文 [ 5360字 | 22分钟 ]

【原文作者】 Founder Park

【摘要模型】 deepseek-v3

【摘要评分】 ★★★★★