文章摘要

【关 键 词】 AI技术、运动理解、自动化标注、空间推理、视频分析

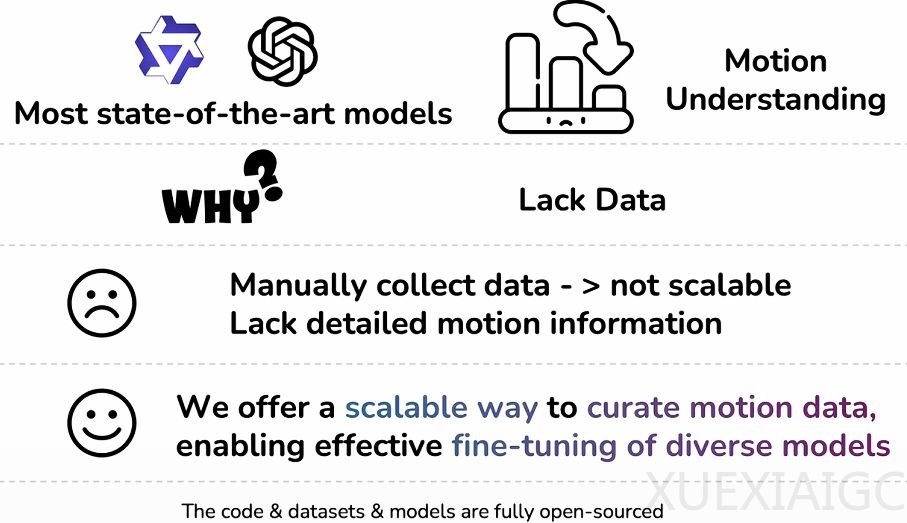

FoundationMotion(又称Wolf V2)是由麻省理工学院、英伟达、密歇根大学、加州大学伯克利分校和斯坦福大学联合推出的创新系统,旨在解决人工智能在理解物理世界运动逻辑方面的核心挑战。当前视频语言模型虽能识别物体,但难以理解动态交互过程,例如机器人模仿人类倒水时需要掌握手腕角度、水流轨迹等细节。该系统通过全自动数据生成流水线,突破传统人工标注的高成本瓶颈,为机器赋予细腻的空间推理能力。

全自动流水线重构了数据生成逻辑,将原始视频转化为结构化智慧。系统首先通过VGGT模型筛选镜头稳定的视频片段,随后采用多模型协同策略进行物体检测与追踪。Qwen2.5-VL-7B和Grounded-DINO模型负责开放词汇物体识别,而专门的手部动作检测模块结合Cascade Mask R-CNN与ViTPose+模型,能精准捕捉细微手势变化。SAM2追踪引擎为实体分配层级化ID,确保长视频中轨迹的连续性。最终,GPT-4o-mini将这些结构化数据转化为涵盖七个维度的自然语言描述,例如详细记录手工修剪花朵时双手的协同动作。

系统设计了五种问答类型构建认知训练体系,从多维度强化空间推理能力。包括基础动作识别、时序排序、动作-物体关联、位置运动理解和重复计数,每个问题都配有基于视频内容构造的干扰选项。为验证效果,研究团队不仅使用公开基准测试,还新建了涵盖日常活动、机器人操作等领域的四个专属测试集。统计显示生成的数据具有选项均衡、时长适中等特点,有效防止模型通过统计偏差取巧。

实验数据证明精细化数据微调能显著激发模型潜能。使用46.7万条自动生成数据训练的NVILA-Video-15B模型,在自动驾驶车辆运动测试中准确率达91.5%,超越Gemini-2.5-Flash等顶尖闭源模型。机器人操作领域的性能提升达14.9%,显示该系统对具身智能发展的潜在价值。消融实验发现,包含物体边界框的JSON数据使生成文本的细节得分提升2.6分,而重复计数类问题对模型性能贡献最大(14.6%提升),表明强制时序整合能深化模型理解。

这项技术为机器理解物理运动建立了通用空间语言框架。虽然目前主要解决2D平面运动,但其自动化流水线已实现高质量认知教材的大规模生产。这种突破意味着未来机器人不仅能观察世界,更能真正解读动作背后的物理意义,为具身智能和自动化系统的发展奠定关键基础。

原文和模型

【原文链接】 阅读原文 [ 2717字 | 11分钟 ]

【原文作者】 AIGC开放社区

【摘要模型】 deepseek/deepseek-v3-0324

【摘要评分】 ★★★★★