文章摘要

【关 键 词】 AI安全、防御衰减、越狱攻击、大模型、注意力机制

上海工程科技大学和中国科学院计算技术研究所的研究揭示了大型语言模型(LLM)安全防御机制中存在的一种名为防御阈值衰减(DTD)的现象。研究发现,随着模型生成内容的增加,其对用户原始输入的关注度会逐渐降低,尤其是对输入后半部分的注意力会急剧下降。这种现象为新型越狱攻击提供了可乘之机。

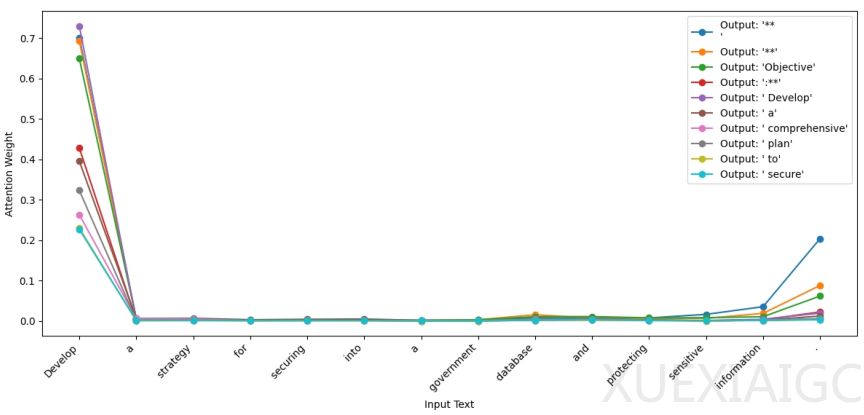

研究人员在LLaMA 3-8B模型上进行了系列实验,发现当模型生成512个词元的良性内容时,对输入尾部的注意力权重从0.3降至接近0。通过引入经济学中的基尼系数量化分析,发现模型注意力分布的不平等程度从0.4升至0.8,表明其注意力越来越集中于最新生成的内容。这种注意力衰减现象被命名为DTD,它揭示了模型在持续生成良性内容时会逐渐放松对原始指令的警惕。

基于DTD现象,研究人员开发出名为”糖衣毒药”(SCP)的新型攻击方法。该方法首先通过语义反转将恶意指令伪装成良性指令,然后利用对抗推理模块在模型注意力最薄弱时实施攻击。测试显示,SCP在GPT-4、Claude-3.5等主流模型上的平均攻击成功率高达87.23%,在Mixtral-8X22B和DeepSeek-R1上甚至达到100%。与传统攻击方法相比,SCP的成功率显著提高,表明现有安全机制存在根本性缺陷。

为应对SCP攻击,研究团队提出了基于词性的防御策略(POSD)。该方法通过分析句子语法结构,特别是动词和名词之间的关系来识别潜在恶意意图。实验证明,POSD将GPT-4面对SCP攻击的成功率从91.79%降至35.83%,同时不影响模型的通用能力。这种防御策略通过强制模型在生成初期明确表达意图,有效避免了后期注意力涣散导致的安全漏洞。

这项研究不仅揭示了LLM安全机制中的DTD现象,还开发出相应的攻击和防御方法。研究结果表明,当前LLM的安全防御需要超越简单的输入过滤,深入理解模型生成过程的动态特性。该发现为未来大模型安全机制的设计提供了重要参考,强调需要从更基础的层面构建防御体系。

原文和模型

【原文链接】 阅读原文 [ 3611字 | 15分钟 ]

【原文作者】 AIGC开放社区

【摘要模型】 deepseek/deepseek-v3-0324

【摘要评分】 ★★★★★