火山引擎,「出击」Agent

文章摘要

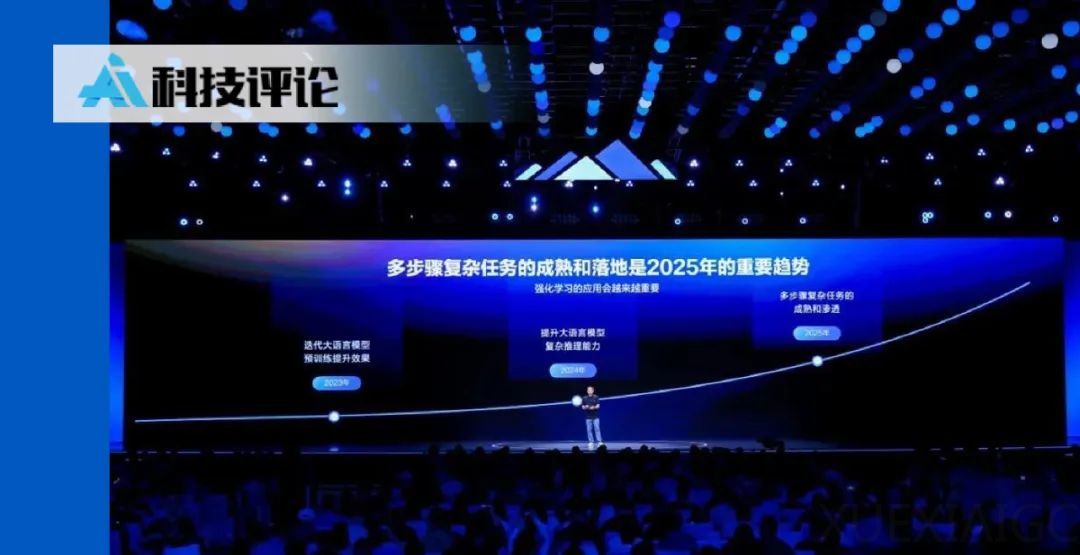

2025年年中,大模型领域的竞争已进入下半场,Agent成为焦点。下一代基础模型的技术壁垒将竞争团队收敛至中美少数几家,创新门槛提高,底层技术的比拼声量降低。Meta因对Llama 4效果不满,计划设立“超级智能小组”进行下一轮冲刺。Agent在自主理解、规划、使用工具与完成任务的表现上,展现了AGI长征中的新天地,被称为“自动收益的商品化”。无论是物理世界中的机器人还是虚拟世界中的Agent,它们被赋予目标后,能够通过自主理解、学习、规划、调用工具等步骤完成任务并获得收益,具备价值可交换的商业特质。

在自动收益商品化的Agent市场中,基础模型占据主导优势,Deep Research工具基本来自模型头部厂商。基础模型是培养Agent能力的高校,强化学习是Agent进入特定环境后适配任务的桥梁。随着头部云厂商的加入,纯产品团队与行业玩家在开发Agent上的潜力也成为了现实。云平台集合了基础模型、强化学习、云计算等第三方开发服务能力,为Agent开发提供了AI Being的原材料和落地到具体场景的辅助buff。

Agent的爆火离不开Manus的功劳,其任务拆解与自主执行能力以及执行步骤过程的透明化,切中了需求侧市场对自动化工具的迫切需求。Manus火不只是由于能做什么事,还在于他们给了用户更多的掌控感,通过可解释性和用户参与感打破技术黑箱,建立用户信任。Agent核心能力依赖大模型或多模态模型,这些模型的推理对算力要求极高,模型+云的组合满足了企业在算力、成本、稳定性等方面的刚性需求,形成了一套完整的行业解决方案思路。

B端市场对降本增效的刚性需求正催生万亿级蓝海,是整个Agent行业的下一块必争之地。企业级Agent落地绝非坦途,模型能力带来的“幻觉问题”、跨系统协作的高昂成本、工业级标准的严苛要求,无不考验着当下的Agent产品从“玩具”到“生产力工具”的进化能力。To B领域的Agent虽然前期推广难度大,但一旦契合企业需求,往往就容易收获稳定的客源。企业对降本增效、流程自动化的需求是持续且强烈的,从电商营销再到金融法律等领域,Agent都还有巨大的应用空间,且这些领域的企业往往付费能力强,一旦形成成熟的商业模式,收益将较为可观。

创业公司在智能体开发流程中普遍遇阻,尤其是B端落地。当前技术存在诸多限制,以智能客服场景为例,很多智能客服存在幻觉问题,无法保证与客户交流的准确性;许多在Auto Agent领域探索的产品虽具备一定工作流程,但在实际B端场景应用中仍不够成熟,产品的反应速度和输出速度与真正解决企业问题的要求相距甚远。系统、数据孤岛与协作成本也是B端Agent面临的核心困境。传统B端企业内部存在多个独立系统,自动化流程需多个Agent协作完成,跨系统对接需要投入大量资源。同时,不同企业的智能体缺乏统一标准,难以直接连接协作,导致整个Agent系统效率低下。

行业目前的主流解决方案为“AI原生应用运行平台+MCP产品组合”,许多模型厂商都推出了企业级的AI云原生应用开发平台,将其视作解决大模型技术向实际应用转化的最后一公里难题的答案,为企业及个人开发者提供Agent应用的一站式构建能力。To B的技术门槛升级后,初创企业想要入局,离不开AI云原生平台作为“智能生产力基础设施”的桥梁作用,当“开箱即用”越来越成为企业刚性需求,新的开发范式正在重构Agent落地的底层逻辑。

对于企业来说,自动化办公转型已箭在弦上,但目前可选的Agent产品十分有限,由于Agent的背后就是模型和产品,因此很多非模型层面的公司仅靠自身很难做出符合市场需求的Agent。非模型层面的企业在切入Agent赛道时,首先面临的就是“模型能力断层”,既缺乏大模型底层研发能力,又难以将通用模型高效适配垂直场景。AI云原生成为企业智能生产力的关键切入点,类似于火山引擎提出的MCP服务+豆包大模型+云服务的一整套Agent开发范式,能直接跳过上述难点0帧起手构建起Agent的技术底座。

在传统软件开发流程中,包含了需求调研、产品规划、界面设计、功能拆解、接口联调、部署发布等多个步骤,编码工作只是其中一个环节,占比约为30%左右。如果AI Coding工具只做AI代码生成,在实际工程应用中将很难全面提高开发效率。如何将零散地分布在不同环节、工具中的AI能力融合起来,成为让AI真正融入工作流的重点,也成为TRAE基于提升软件开发全流程效率和体验打造产品的核心。通过TRAE,开发者可以通过自然语言描述目标生成文件结构、拆分模块、补全代码、甚至自动新建UI页面,按照项目需求执行定制化任务。

豆包大模型1.6解决B端Agent反应速度、输出速度慢难题。从早期的感知智能再到如今的Agentic AI,AI对企业生产力的提升已经从单纯的内容分析、内容创作转变为目标导向的自主执行系统,更看重大语言模型的理解、环境交互能力,以及如何与其他生产工具实现深度融合调用。B端Agent落地首先需要解决的就是模型能力的问题,如果不能从模型层面解决产品反应速度、输出速度慢等从根本上影响用户体验的缺陷,Agent就离真正解决企业问题还有很远。作为目前常用的“Agent大脑”之一,豆包大模型刚刚更新了1.6版本,其中既包括豆包目前最强的思考模型Doubao-Seed-1.6-thinking、灵活支持thinking/non-thinking/自适应思考三种模式的Doubao-Seed-1.6模型,也有具备超低延迟和出色的视觉理解能力的Doubao-Seed-1.6-flash模型。

针对B端Agent反应速度、输出速度慢的问题,豆包大模型1.6在推理能力、推理速度上都实现了进一步升级,Doubao-Seed-1.6-flash模型专门面向于低延迟、低成本需求,模型具备超低延迟表现,per token延迟甚至可以低至8ms左右。同时,豆包还关注到了不同业务场景对模型能力需求的差异,豆包大模型1.6全系列都原生支持多模态思考能力,以求更好理解和处理真实的业务场景。在电商场景,豆包大模型可以在海量角度不同的图片中,快速识别同款;在餐饮场景,百胜中国肯德基基于豆包大模型,构建了新一代AI智能陪练系统,可基于企业专属知识库智能萃取业务领域知识和话术,让员工在高度仿真的对话环境中模拟线下门店实战场景。

值得一提的是,豆包此次的1.6版本在编程能力上还做了定向增强,特别是针对前端开发场景,现在让豆包大模型生成一个企业级的客户管理CRM系统的原型图只需要几分钟时间,还能生成完整的代码并支持在线预览,作为对比,同样的需求在过去可能需要产品经理和UI设计师花费数天时间才仅仅能完成原型图。此外,企业还可以借助火山引擎「PromptPilot」平台进行提示词优化,帮助用户准确传达需求。在日常与大模型聊天机器人的交流过程中我们应该都会发现,有时候我们很难对大模型传达清晰的需求表达,对于大部分人来说,通过prompt摸索模型能力边界是一个痛苦乏味的过程,这一点在B端追求效率的场景下更为明显,特别是B端往往还要面临Agent上线后层出不穷的Badcase。

而PromptPilot是一款面向大模型应用落地的使能平台,充当的就是大模型与用户之间“需求翻译”的角色。PromptPilot从Prompt构建这一基础环节出发,通过用户反馈与数据驱动机制,可以精准识别和表达用户任务意图,自动生成解决方案,并实现线上Badcase检测与运行时持续优化。“虽然说模型越强,prompt越重要,但很多时候,让用户自己通过Prompt调试模型是一种碰运气的做法。”从这点来看,Prompt Pilot更像是一种帮助用户精准控制大模型的工具,平台并不要求用户拥有大模型专业知识,只要用户对自己的行业领域/应用场景有一定的专业知识和判断力,就能帮助用户提升大模型在具体应用场景的效果。

火山MCP打通Agent开发的模型、工具、生态体系。针对当前B端Agent的另一个核心困境:系统孤岛与协作成本,目前行业内的主流解决方案则是构建以MCP协议为核心的平台体系。有业内人士认为,MCP在工具和协议层面上基本上已经被业界认为是“事实标准”,意味着大家基本上都会将其认为是模型与外部工具连接的实施标准。针对传统开发工具难以满足Agent全生命周期管理需求的难题,火山引擎以MCP为标准,构建端到端智能体生产体系。具体来看,火山MCP不仅全面覆盖办公、搜索、内容等大模型工具生态,还打通了TRAE、火山方舟、扣子空间等一系列Agent开发体系,用户可以一键选择200+ MCP服务,快速打造出一站式端到端完整链路极速体验,高效构建复杂Agent并直接部署发布。

事实上,字节旗下扣子平台为了适配端到端智能体生产体系的发展,已经由原先的Agent低代码开发平台升级成为覆盖Agent低代码开发、全代码开发,Agent调优和Agent协作的全生命周期平台。针对全码开发者,扣子提出全码Eino开源框架,为开发者提供GO语言版本的Agent搭建框架,以快速编写构建Agent。目前,扣子上已有诸多企业级AI解决方案,涵盖调研、文案、电商、教育等不同场景,帮助企业既能招到精通各项技能的“通用实习生”,也能请到各行各业的“领域专家”。日前,扣子还针对企业用户上线了企业版,提供精细化权限管理、多租户隔离、全链路安全合规等能力,全新的「扣子罗盘」还能帮助企业开发者完成Agent的调试。截止目前,已有上万家企业、数百万开发者正在使用扣子开发平台。

在具身智能领域,松延动力人形机器人N2接入扣子AI智能体后可以32自由度模拟200+微表情的形式实现沉浸式交互。在智能客服领域,抖音电商通过扣子搭建智能客服系统,客服智能体不仅可以通过任务驱动和卡片交互自动生成回复,还能作为后台AI辅助能力,提供实时建议和解决方案,辅助人工客服快速处理复杂问题。数据显示,在引入扣子智能客服系统后,智能客服每一轮的回复耗时相较于人工回复降低到了15s~20s,对比传统智能链路转人工率降低5pp+,满意度正向2pp+,帮助人工客服的工作效率显著提升50%。

开箱即用,全栈开发工具聚焦Agent落地技术、成本痛点。通过“技术产品化+能力服务化+场景行业化”的三层架构,火山引擎Agent开发范式结合Agent Driven的云、数据、安全技术,打破了传统IaaS+PaaS+SaaS的边界,将复杂的Agent开发运维需求转化为标准化能力并提供,让Agent从概念走向企业级应用。火山引擎通过Agent开发平台提供端到端的开发环境,将原生Agent、数据湖、机器学习等技术封装为开箱即用的服务,在避免企业重复造轮子的同时,通过按需付费降低企业使用成本,并提供适配企业的定制化解决方案。根据官方数据,豆包1.6成本下降了63%,企业只需要原来三分之一左右价格,就能获得一个能力更强、原生多模态的新模型。

截止目前,有近八成主流汽车厂商选择豆包大模型作为汽车AI升级的助力,火山引擎的整套Agent开发逻辑以“协助打造Agentic AI”为核心,聚焦帮助企业低成本高效率做好Agent。在构建企业级Agent的过程中,火山引擎建议遵循“模型选择、性能优化、数据融合、安全保障、编排智能体”的关键路径,以豆包大模型的全栈多模态能力、超大规模语言模型性能及模型家族的场景化覆盖作为模型基础,云服务对MCP提供支持、形成标准化协议驱动的全栈协作生态,规避Agent开发与部署环境脱节,动态调度算力资源。

在底层设施方面,云基础设施从“弹性资源池”升级为“密集算力中心”,需承载多模态大模型训练与推理,并需要平衡企业推理效率与成本。火山引擎云基础设施面向Agent与模型,以GPU为中心进行了网络、存储、计算的升级,包括高达320Gbps的vRDMA高速互联能力、13s加载671B模型推理引擎,整合了全栈推理加速、工程实践、高性价比资源、安全易用和端到端体验等优势。而对于前文提到的系统、数据孤岛问题,火山引擎基于开放技术的智能异构计算平台,引入模型时代前沿技术栈,Agent应用中产生的数据可以无缝回流到数据平台,便于分析和沉淀,通过统一的、全链路的数据管理,可避免数据孤岛、解决企业数据碎片化问题。

在Agent时代,企业的竞争力不再取决于是否拥有模型,而在于能否高效调用模型、编排智能体、融合数据。如此看来,火山引擎AI云原生对于企业开发者而言,不再局限于提供基础的工具、模型、计算资源,而是以智能为纽带,将分散的技术组件编织成有机整体,帮助企业降低技术风险。以火山引擎AI云原生技术为桥梁,非模型企业正在打破“技术壁垒-成本高企-场景割裂”的落地困境,企业级Agent与端到端全场景智能开箱即用,云原生底座就成为释放Agent潜力的核心基础设施。

借助火山引擎AI云原生平台,浙江大学仅仅花了一周时间便落地集AI科学家、课堂问答、教务咨询等多场景定制化应用于一体的“浙大先生”智能体平台,服务5万多名在校师生,开发这些应用的主力全都为浙大的老师、学生和浙大校园各种信息系统的服务商,在开箱即用的Agent开发平台的支持下,快速落地定制化的Agent应用已不再是难题。

当Agent真正成为企业生产系统的“神经中枢”,生产力革命的红利才将真正释放,技术演进的必经之路上,Agent已经成为企业数字化转型的必争之地,而AI云原生带来的Agent Ready,也将推动产业从“概念炒作”走向“生产力革命”,最大化释放Agent的智能价值。

原文和模型

【原文链接】 阅读原文 [ 6373字 | 26分钟 ]

【原文作者】 AI科技评论

【摘要模型】 deepseek-v3

【摘要评分】 ★★★★☆