文章摘要

【关 键 词】 AI视频、多模态模型、影视行业、技术突破、内容生成

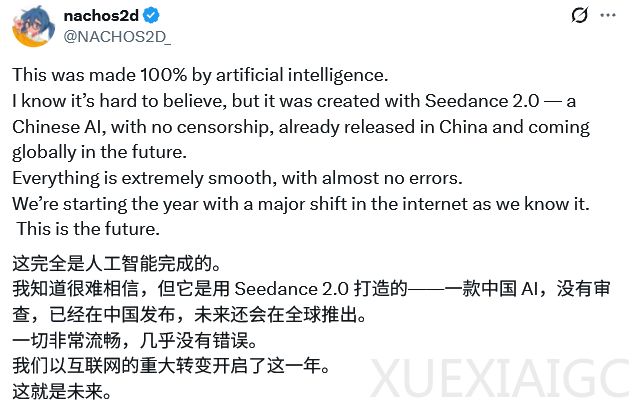

字节跳动推出的多模态AI视频生成模型Seedance 2.0引发全球热议,其突破性技术被认为将彻底改变影视内容生产模式。该模型支持文本、图像、视频和音频四模态输入,能生成1080p以上分辨率的影视级视频,并实现多镜头叙事、原生音频同步和导演级控制。社交媒体上广泛传播的案例显示,用户仅用30分钟和60美元成本即可完成传统需要数十人团队、数周时间和数百万预算的短片制作。

模型的核心创新在于其通用参考系统,允许用户通过上传参考资产精准控制输出效果。使用@image1、@video1等标签可指定每项资产的作用,实现风格锁定、动作复制和韵律匹配。多镜头叙事功能确保镜头切换自然且要素一致,视频延长功能支持从现有片段持续生成。音频系统能同步生成对话、音效和背景音乐,支持8种语言的音素级唇同步。

技术社区将Seedance 2.0视为视频生成领域的”GPT-4o时刻”,其控制精度已超越OpenAI的Sora 2模型。专业用户可通过自然语言指令实现复杂场景生成,如”相机跟随黑衣男子仓皇逃跑”这样的导演级描述。《黑神话:悟空》制作人冯骥公开评价其为”目前全球最强视频生成模型”。

影视行业对此反应强烈,从业者担忧编剧、导演、摄影等岗位可能被大规模替代。社交媒体讨论指出,传统数字电影制作中90%的技能可能被AI取代。更深层次的忧虑集中在超真实视频可能引发的信任危机,有观点认为”看到即真相”的时代即将终结。

目前模型处于有限测试阶段,预计2月24日全面开放。开发者可通过Atlas Cloud接入API,创作者可在Higgsfield等平台体验。行业讨论已从技术惊叹转向本质思考:当内容生产门槛消失后,故事原创性和审美品味将成为核心竞争力。Seedance 2.0的广泛部署预计将重塑整个内容产业生态,其社会影响可能远超当前预期。

原文和模型

【原文链接】 阅读原文 [ 1445字 | 6分钟 ]

【原文作者】 AIGC开放社区

【摘要模型】 deepseek/deepseek-v3-0324

【摘要评分】 ★★★☆☆