Karpathy组建大模型「议会」,GPT-5.1、Gemini 3 Pro等化身最强智囊团

文章摘要

【关 键 词】 AI模型、信息消费、LLM议会、多模型集成、开源项目

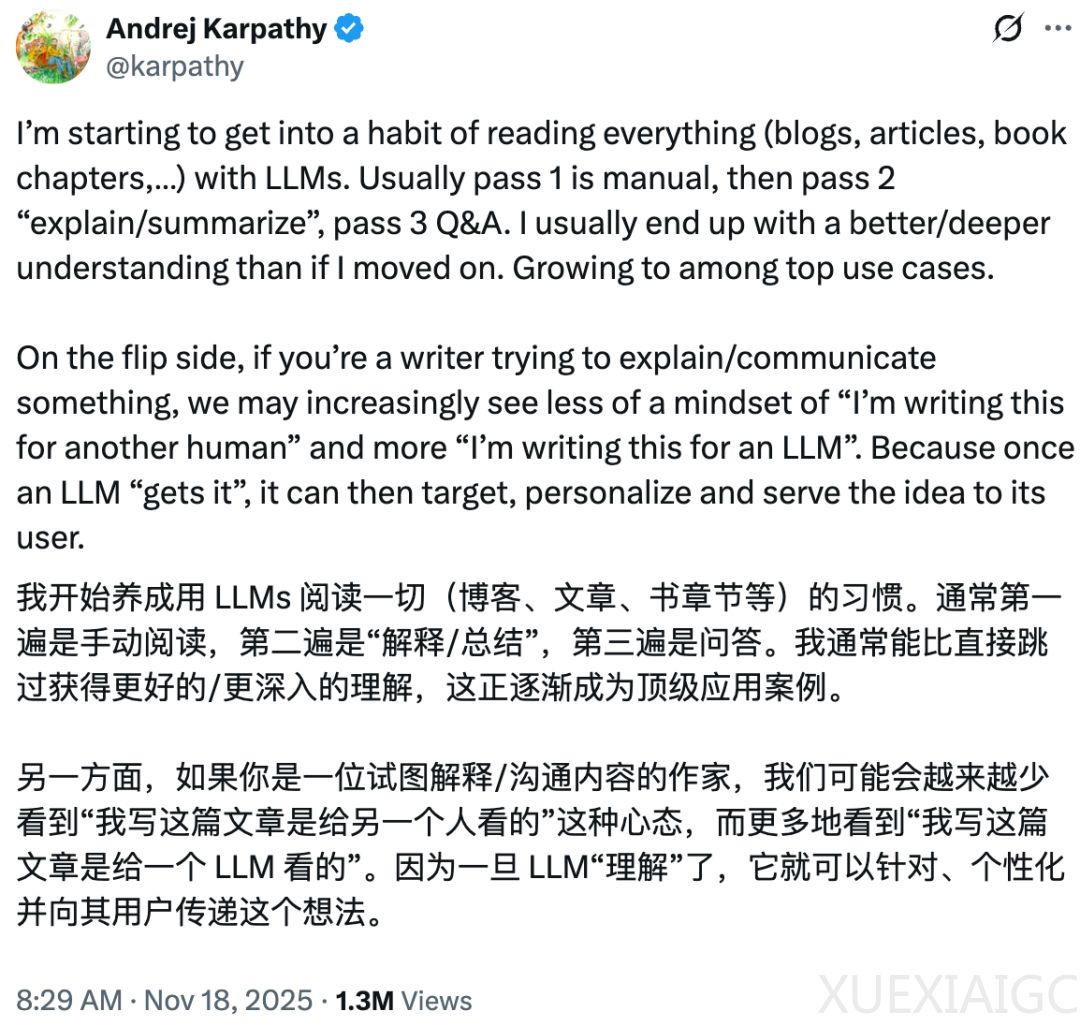

从短视频到AI模型,人们消费内容的习惯正快速向追求效率转变。在信息爆炸的时代,越来越多的人倾向于直接获取高密度、可快速吸收的知识,而非从头到尾浏览长文或论文。这种趋势下,让大模型进行总结已成为普遍做法,高效获取信息本身被视为人类能力的一次跃迁。前OpenAI联合创始人、特斯拉AI总监Andrej Karpathy近期发推表示,自己已养成用大语言模型(LLM)阅读一切的习惯,结合个人感悟与模型总结,形成更完善的认知体系。

面对不同类型的内容,不同大语言模型的能力参差不齐。为获取更高质量的结果,Karpathy开发了一个名为「LLM议会」的Web应用。该项目的核心在于让四个最新的大模型(包括OpenAI的GPT-5.1、Google的Gemini-3-Pro-Preview、Anthropic的Claude-Sonnet-4.5和xAI的Grok-4)组成一个智囊团,协同工作。用户提问后,问题会分发给所有模型,每个模型能看到其他模型的匿名回答,并进行审阅和排名。最终,一个「主席模型」会整合这些信息,生成最终回答。

这一设计与知名游戏博主PewDiePie此前用氛围编程构建的「大模型委员会」类似,但Karpathy的项目采用了不同厂商的模型,增加了多样性。多模型之间的相互评价和投票机制形成了一种全新的「赛博斗蛐蛐」场景,甚至成为评估模型表现的有趣方式。例如,在Karpathy的测试中,模型们一致将GPT-5.1评为表现最佳,而Claude排名最后,但Karpathy的主观感受却略有不同——他认为GPT-5.1有时过于啰嗦,而Gemini-3更凝练。

项目的运行分为三个阶段:首先,所有模型独立生成回答;其次,模型们匿名互评,基于准确性与洞察力排名;最后,主席模型整合信息输出最终结果。这种多模型集成的设计可能为基准测试和模型评估开辟新的研究方向。Karpathy已将项目开源,但明确表示不会提供后续支持,仅作为灵感工具供社区参考。此前,机器之心团队也通过氛围编程复刻了类似项目,使用两个不同模型部署,未来可能同样开源供探索。

原文和模型

【原文链接】 阅读原文 [ 1352字 | 6分钟 ]

【原文作者】 机器之心

【摘要模型】 deepseek/deepseek-v3-0324

【摘要评分】 ★★☆☆☆