文章摘要

【关 键 词】 AI模型、智能密度、边缘计算、参数优化、算法效率

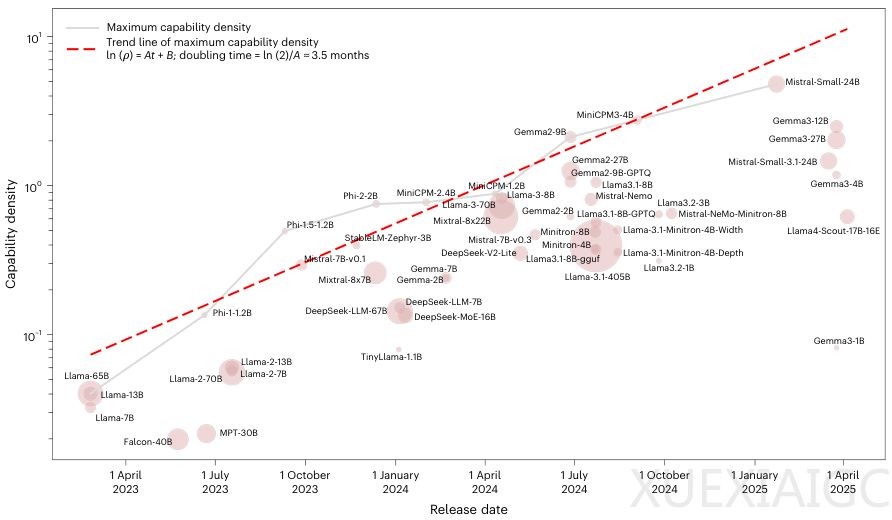

清华大学与面壁智能团队在《自然-机器智能》发表的研究揭示了大语言模型进化的核心规律——致密律(Densing Law),标志着AI发展从参数堆砌转向效率革命。研究发现,为达到相同智能水平,模型参数量正呈指数级下降,能力密度(单位参数量的智能水平)约每3.5个月翻倍,速度远超硬件领域的摩尔定律。这一规律通过51个主流开源模型的分析得到验证,即使在无污染数据集MMLU-CF上仍保持0.953的高相关系数,证实其反映算法真实进步而非数据过拟合。

参数半衰期概念是致密律的核心推论:保持性能不变时,所需参数量每3.5个月减半。实际案例显示,2024年2月发布的MiniCPM-1-2.4B以35%的参数量超越了4个月前Mistral-7B的性能。这种效率提升直接降低推理成本,云服务价格在20个月内下降266.7倍。研究同时颠覆了传统压缩技术的认知,单纯的剪枝、量化可能损害能力密度,而充分再训练的蒸馏模型(如Gemma-2-9B)才能实现密度提升。

算法效率与硬件进步的乘数效应推动边缘智能加速到来。等效智能水平每88天翻倍,使得高性能模型即将进入消费级设备。研究团队建立的客观评估体系通过有效参数规模(EPS)量化密度,涵盖混合专家模型和量化架构。值得注意的是,ChatGPT发布后密度增速提升50%,开源生态与资本投入成为关键驱动力。尽管存在信息论的理论上限,但在突破物理瓶颈前,致密律将持续指导产业方向。

该发现预示AI竞争范式转变:从规模扩张转向效费比优化。企业需基于3.5个月的周期预测技术演进,而本地化智能服务将重塑应用生态与隐私安全格局。随着模型具备自我优化能力,效率革命可能进入加速循环,最终实现“将超级AI装入移动设备”的产业愿景。

原文和模型

【原文链接】 阅读原文 [ 2258字 | 10分钟 ]

【原文作者】 AIGC开放社区

【摘要模型】 deepseek/deepseek-v3-0324

【摘要评分】 ★★★★☆