文章摘要

【关 键 词】 AI芯片、推理市场、技术竞争、成本优化、性能突破

每年9月通常是手机新品发布的高峰期,但今年科技界的焦点已转向AI推理芯片领域的激烈竞争。随着AI应用从训练转向商业化落地,推理市场正迎来爆发式增长。麦肯锡预测,全球AI推理市场规模将在2028年达到1500亿美元,年复合增长率超过40%,远超训练市场的增速。华为、英伟达和谷歌三大科技巨头近期相继发布新一代推理芯片,标志着这一领域的竞争全面升级。

华为推出的Ascend 950PR芯片采用低成本HBM策略,直击推理市场痛点。该芯片专攻推理Prefill阶段和推荐业务,采用自研HiBL 1.0内存技术,相比传统HBM3e/4e可大幅降低成本。在技术层面,Ascend 950PR支持FP8/MXFP8等低精度格式,向量算力显著提升,互联带宽达到2TB/s。华为还创新性地采用”Die+HBM合封”模式,针对不同推理阶段需求定制内存方案,在性能和成本间取得平衡。这一策略不仅缓解了HBM供应紧张问题,也为边缘计算和云服务的大规模部署创造了条件。

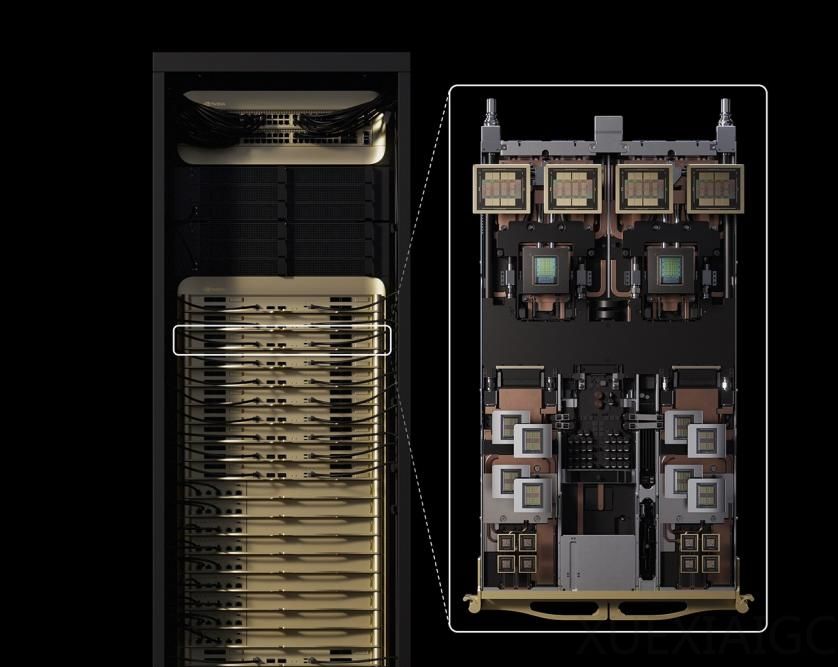

英伟达的Rubin CPX则专注于长上下文处理这一新兴需求。这款被黄仁勋称为”CPX”新类别的处理器,针对百万Token级上下文优化,单机架算力达8 Exaflops。其创新之处在于集成视频编解码器和长上下文推理技术于单芯片,系统专注力提升3倍,能效比显著提高。英伟达预计,每1亿美元投资可获得50亿美元Token收益,投资回报率高达5倍。随着多模态长序列处理需求激增,Rubin CPX有望巩固英伟达在AI生态中的领先地位。

谷歌的Ironwood TPU在效率和规模上实现双重突破。面对内部推理请求量一年增长50倍的挑战,谷歌这款第七代TPU提供256芯片和9,216芯片两种配置,总算力最高达42.5 Exaflops。其功率效率是前代的1.5倍,内存带宽实现飞跃式提升,并采用创新的光路交换机互联技术。谷歌还配套开发了完整的软件堆栈,包括vLLM核心引擎和GKE推理网关等工具,通过软硬件协同将推理延迟降低96%,令牌成本减少30%。

初创公司Groq的崛起也为推理芯片市场注入新活力。这家由前谷歌工程师创立的公司估值在一年内从28亿美元飙升至69亿美元,其LPU芯片采用独特的”张量流”架构,延迟比GPU低10倍。Groq已获得沙特阿拉伯15亿美元订单,并成为加拿大国家AI云网络的独家推理提供商,展现出强劲的市场潜力。

推理芯片竞赛已超越单纯算力比拼,进入成本、能效和生态的综合较量阶段。各大厂商的技术路线各具特色:华为强调成本控制,英伟达专注长上下文处理,谷歌追求极致效率,Groq则另辟蹊径开发新型架构。这场竞争的结果将深刻影响AI技术在各行业的落地速度和规模,最终决定谁能主导AI商业化时代的话语权。随着推理需求持续爆发,芯片创新与应用的良性循环正在形成,推动AI技术从实验室加速走向千家万户。

原文和模型

【原文链接】 阅读原文 [ 3203字 | 13分钟 ]

【原文作者】 半导体行业观察

【摘要模型】 deepseek/deepseek-v3-0324

【摘要评分】 ★★★★★