文章摘要

【关 键 词】 大模型、创造力枯竭、典型性偏见、口述采样、模式坍塌

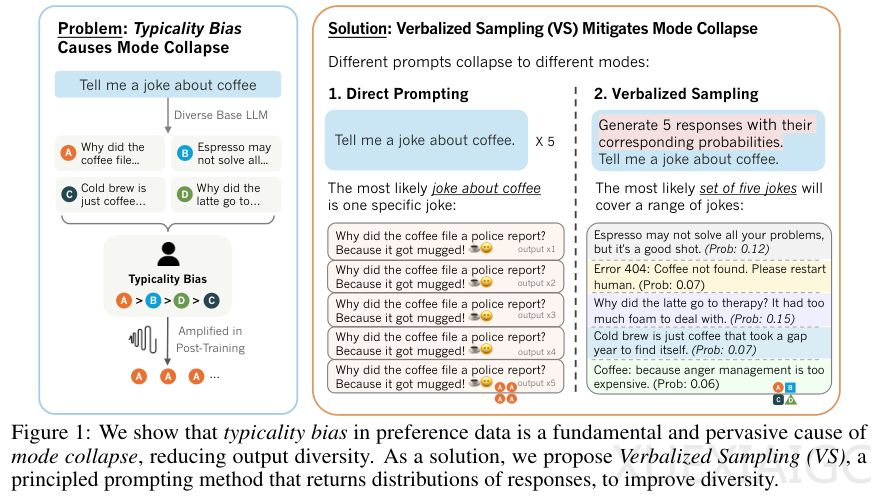

研究发现大语言模型在追求安全顺从的过程中正面临创造力枯竭的模式坍塌问题。东北大学、斯坦福大学和西弗吉尼亚大学的联合团队揭示了这一现象源于人类偏好数据中存在的典型性偏见。典型性偏见植根于人类认知心理,包括单纯曝光效应、流畅性启发式和图式一致性理论等机制,导致标注者系统性地偏好平庸但安全的文本。通过Bradley-Terry模型分析发现,这种偏见迫使模型在训练过程中将概率分布极度尖锐化,集中在最符合人类刻板印象的模式上。

研究团队提出了一种名为口述采样的创新方法,该方法无需重新训练模型,仅通过重构提示词就能在推理阶段解锁模型被压抑的多样性潜能。与传统直接提示不同,口述采样要求模型生成一组响应及其对应概率,引导模型绕过RLHF带来的分布尖锐化效应,重新访问预训练阶段习得的原始概率空间。该方法衍生出VS-CoT和VS-Multi两种变体,分别适用于需要逻辑推理的任务和长文本生成场景。数学证明显示,唯有这种分布级提示能引导模型逼近预训练阶段的真实分布。

在创意写作测试中,口述采样使输出多样性提高了1.6到2.1倍,且未牺牲生成质量。诗歌续写、故事生成和笑话创作等任务的评估显示,该方法生成的内容在创意上显著优于传统方法。社会模拟实验同样取得突破,在PersuasionForGood对话任务中,模型模拟的捐款金额分布与真实人类数据高度吻合,且能还原人类互动中的犹豫和非理性行为特征。开放式问答测试表明,口述采样能显著提升答案覆盖率,KL散度仅为0.12,接近预训练语料库的真实分布。

口述采样在合成数据生成方面展现出独特价值。使用该方法生成的数学竞赛题目微调小模型后,在MATH500等基准测试中准确率提升至37.5%,显著优于传统方法。研究还发现模型规模与口述采样效果呈正相关,大型模型通过该方法获得的多样性增益是轻量级模型的1.5到2倍,表明当前评估可能严重低估了大模型的真实能力。消融实验证实该方法在不同温度系数和对齐阶段都保持稳定效果。

这项研究揭示了模式坍塌的本质是人类心理偏见在机器反馈回路中的投影,为平衡模型安全性与创造力提供了简单有效的解决方案。通过改变提示策略,研究证明安全与多样性可以共存,为理解人机对齐机制提供了新视角,也为提升大模型在创意写作、社会模拟和数据生成等领域的应用价值开辟了新途径。

原文和模型

【原文链接】 阅读原文 [ 4450字 | 18分钟 ]

【原文作者】 AIGC开放社区

【摘要模型】 deepseek/deepseek-v3-0324

【摘要评分】 ★★★★★