文章摘要

【关 键 词】 AIGC、大模型、智能体、强化学习、开源模型

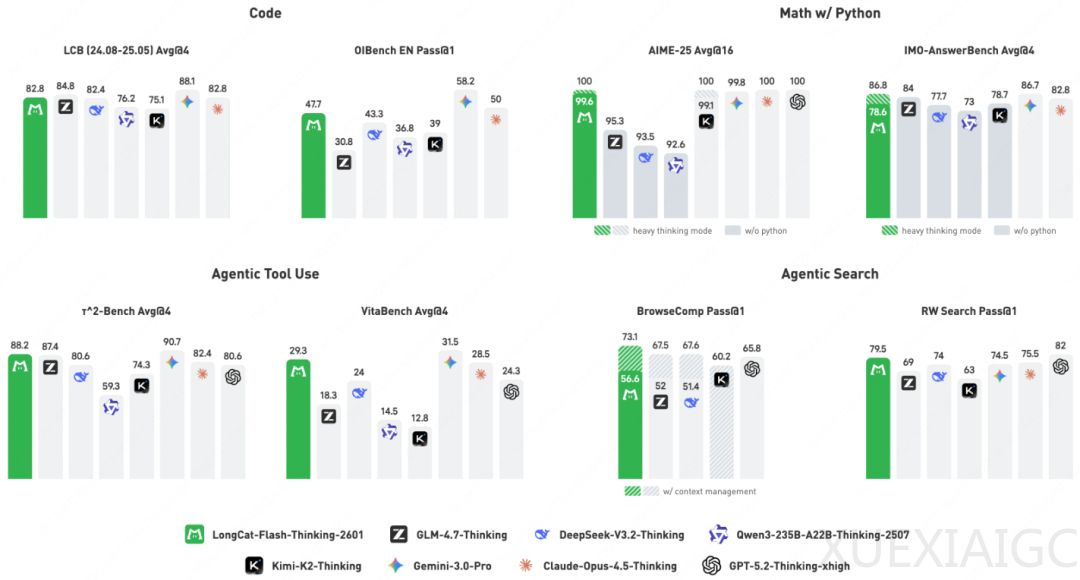

美团龙猫团队开发的LongCat-Flash-Thinking-2601模型标志着智能体推理能力的重大突破。这个总参数5600亿、激活参数270亿的混合专家模型(MoE),在代理搜索、工具使用及集成推理任务上超越了现有开源模型,部分指标甚至媲美闭源模型。其成功源于数据构建、环境模拟、强化学习策略和训练设施的全方位创新设计。

环境交互能力被视为智能体认知的基石。当前大模型在纯认知任务上表现出色,但解决现实问题需要与外部环境交互的代理推理能力。由于缺乏高质量交互数据,团队设计了混合数据合成流水线,从非结构化文本和可执行环境中创造训练数据。通过文本过滤、工具提取技术将静态文字转化为动态交互轨迹,并采用工具分解和推理分解策略增强数据复杂性。为确保逻辑严密性,团队构建了基于Python的轻量级仿真环境,采用逆向工程合成方法生成可执行的高质量数据。自动化环境扩展流水线覆盖20多个领域,将高层定义转化为可执行代码图谱,为模型提供了丰富的训练场景。

多域异步强化学习系统DORA解决了传统训练框架的瓶颈。这个生产者-消费者架构系统实现了推理生成与模型训练的解耦,通过全流式异步管道显著提高硬件利用率。面对560B参数模型的显存压力,团队采用Prefill-Decode分离策略和KV-cache交换技术。为增强模型鲁棒性,设计了遵循课程学习原则的噪声注入策略,并采用动态预算分配解决数据不平衡问题。模型同时作为行动者和验证者的双重角色训练,通过自我验证机制提供额外监督信号。

Heavy Thinking模式通过测试时计算扩展显著提升推理能力。该模式分为并行推理和重度思考两阶段:首先生成多个候选推理轨迹,再由总结模型进行反思整合。上下文记忆模块有效解决多轮交互中的信息遗忘问题,混合上下文管理策略平衡了信息保留与计算开销。实验显示,这种深度与广度并重的策略性能远超传统自洽性方法。

针对长上下文计算压力,团队开源的Zigzag注意力机制结合了多头潜在注意力和流式稀疏注意力,使计算量与序列长度呈次线性关系。配合YaRN位置编码,模型可处理长达100万token的上下文,实现1.5倍推理加速。这一系列技术创新构成了通用智能体构建的系统方法论,从数据合成、环境扩展到训练架构和推理模式,形成完整闭环。模型在数学推理、代码编写等领域表现优异,其开源为开发者提供了强大基础。

原文和模型

【原文链接】 阅读原文 [ 3540字 | 15分钟 ]

【原文作者】 AIGC开放社区

【摘要模型】 deepseek/deepseek-v3-0324

【摘要评分】 ★★★★★