文章摘要

【关 键 词】 图像生成、视频生成、ControlNeXt、条件控制、开源工具

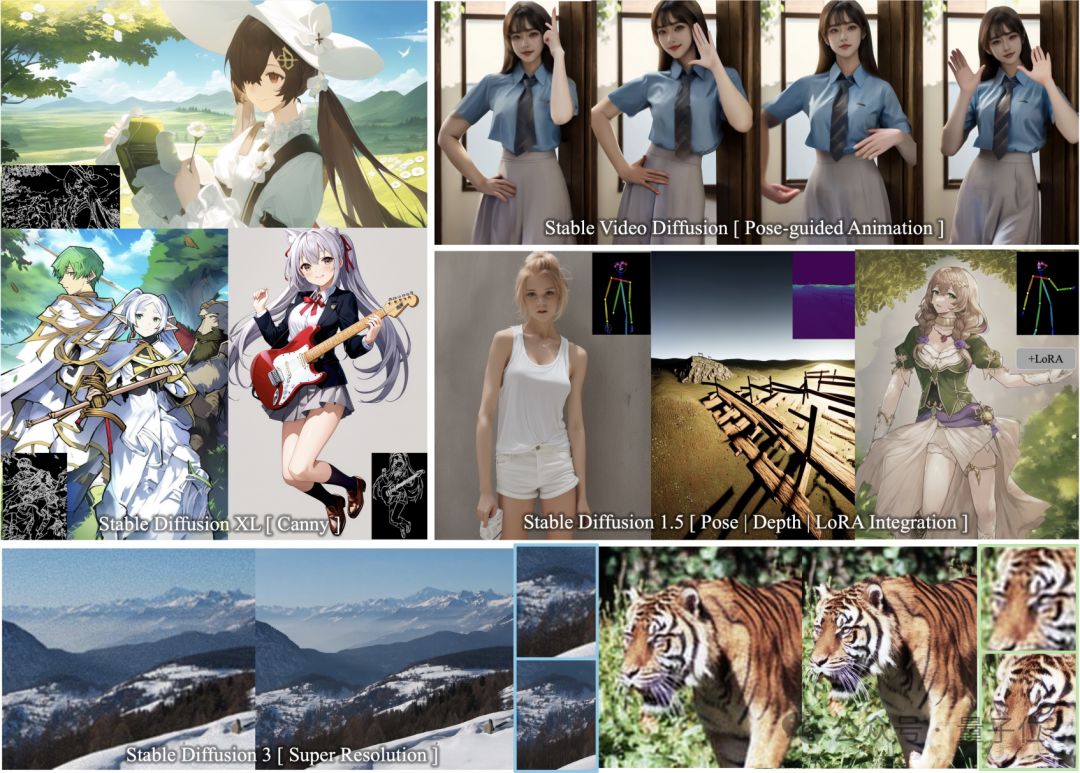

ControlNeXt是由香港中文大学贾佳亚团队推出的开源图像/视频生成引导工具,旨在成为下一代的ControlNet。它通过引入轻量化的条件控制模块,显著提高了可控生成的效率,同时减少了训练参数的需求。ControlNeXt支持多款Stable Diffusion家族的模型,包括SD1.5、SDXL、SD3以及视频生成模型SVD,实现了即插即用的功能。

在图像生成方面,ControlNeXt能够在SDXL中加入边缘引导,绘制出与控制线条完美贴合的二次元少女。即使面对复杂的控制轮廓,模型也能生成符合要求的图片。此外,ControlNeXt无需额外训练即可与LoRA权重无缝集成,实现风格迥异的角色生成。它还支持遮罩和景深的控制模式,以及在SD3中支持超级分辨率,生成超高清晰度的图像。

在视频生成方面,ControlNeXt能够实现对人物动作的精准控制,例如让蜘蛛侠跳起TikTok中的美女舞蹈,甚至让椅子长出手跳同样的舞蹈。相比于原始的ControlNet,ControlNeXt需要的训练参数更少,收敛速度更快,生成速度也更快。

ControlNeXt的核心技术包括轻量化的条件控制模块、交叉归一化以及控制模块学习条件信息到隐空间特征的映射。通过移除ControlNet中的庞大控制分支,引入由少量ResNet块组成的轻量级卷积模块,ControlNeXt降低了计算开销和内存占用。同时,研究团队保持了模型结构与原始架构的一致性,实现了即插即用。

在条件控制信息的注入过程中,ControlNeXt选择了在网络的中间层将条件特征与去噪特征聚合,并通过交叉归一化对齐两组特征的分布,避免了注意力机制等复杂操作引入额外的学习参数和不稳定性。交叉归一化利用主干网络去噪特征的均值和方差对控制模块输出的特征进行归一化,使二者的数据分布尽量对齐,从而加快收敛进程。

ControlNeXt项目主页、论文和GitHub链接分别提供了更多详细信息和资源。这一工具的推出,有望为图像和视频生成领域带来更高效、更可控的生成能力,让人们期待看到更多创新作品的诞生。

原文和模型

【原文链接】 阅读原文 [ 1447字 | 6分钟 ]

【原文作者】 量子位

【摘要模型】 moonshot-v1-32k

【摘要评分】 ★★★☆☆