被Transformer光芒掩盖的论文,Meta科学家回顾十年前创新之作

文章摘要

【关 键 词】 Transformer、注意力机制、语言模型、记忆网络、位置嵌入

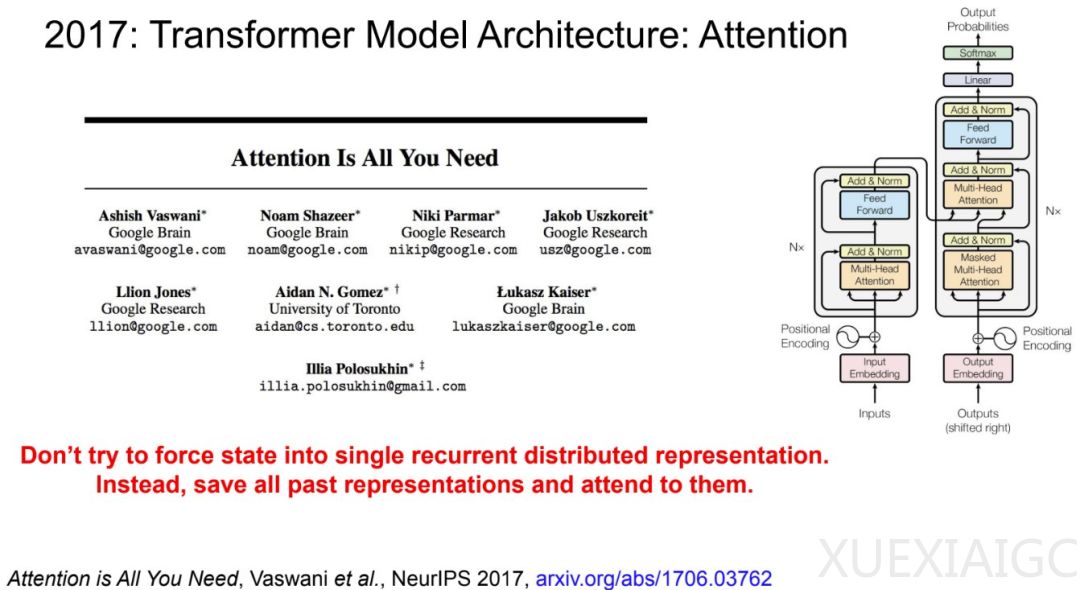

2015年发布的论文《End-To-End Memory Networks》虽然在当时被Transformer的光芒所掩盖,但它包含了当前大型语言模型的许多关键要素。这篇论文首次完全用注意力机制替代了传统的循环神经网络(RNN),并引入了带键值投影的点积软注意力机制,堆叠了多层注意力,使模型能够关注输入的不同部分。此外,论文还引入了位置嵌入来解决注意力机制中的顺序不变性问题。尽管这篇论文比《Attention is all you need》早两年发布,但其被引量仅为3000多,远不及后者的17万次。

论文的第一作者Sainbayar Sukhbaatar回顾了研究的起源,指出他们的工作始于2014年春天,当时他还在Facebook AI研究院实习。他们的研究基于Facebook AI研究院2014年的论文《Memory Networks》,并对其进行了改进。他们使用强化学习训练记忆网络,使其能够学会关注何处,而不需要给定的标签。在2014-2015年冬天,他们实现了强化学习代码,并准备在语言模型任务上与基准进行比较。他们采用了软注意力机制,并将其应用于多层结构中,这在之前是没有人做过的。令人惊喜的是,采用这种软注意力的记忆网络效果出奇地好,他们立即意识到这就是正确的方向。

在Arthur Szlam的坚持下,团队开始使用bAbI任务作为基准,并开发了几种新技术,如为键和值使用不同的投影等。他们还添加了时间嵌入(现在称为位置嵌入)来解决注意力的顺序不变性问题。最终,他们仅使用注意力而没有任何时间recurrence就击败了LSTM,这在当时是一个重要的突破。

回顾10年后的今天,Sainbayar Sukhbaatar认为他们在论文中正确预见了几点。他们的模型是第一个不依赖recurrence的基于注意力的语言模型,成功地堆叠了多层注意力,并使用了位置嵌入,这些现在已成为大型语言模型的标准做法。虽然这篇论文没有像《Attention is all you need》一样引起轰动,但也起到了一定作用。有人表示自己多次读过这篇论文,试图理解为什么某种神经架构有效。

Sainbayar Sukhbaatar承认,Transformer确实做出了重要的改进,比如使用前一层的隐藏状态作为下一层的记忆,还有前馈层、多头注意力等等。他认为,即使已经过去十年,架构改进的工作仍有很多要做。最近,他们发布了一篇题为《Multi-Token Attention》(MTA)的新论文,MTA在多个查询、键和头上调节注意力,在许多指标上都优于标准软注意力,特别是在解决长上下文问题方面表现出色。有趣的是,2015年《记忆网络》论文的结论中就已经提到这一点作为未来的工作,这恰恰是该领域今天仍在研究的问题。

原文和模型

【原文链接】 阅读原文 [ 1828字 | 8分钟 ]

【原文作者】 机器之心

【摘要模型】 deepseek-v3

【摘要评分】 ★★★★☆