3A大作!阿里ROLL团队从基建->算法->机理,推动RL4LLM全栈协同优化

文章摘要

【关 键 词】 强化学习、大语言模型、异步训练、算法优化、注意力机制

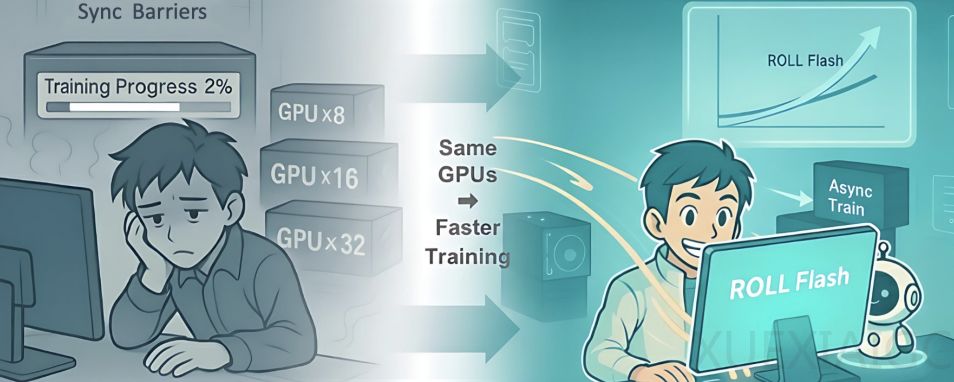

阿里巴巴ROLL团队联合多所高校推出的「3A」协同优化框架,为强化学习在大语言模型(RL4LLM)中的应用带来了高效、精细与可解释的新范式。该框架由Async架构、Asymmetric PPO(AsyPPO)和Attention机制三部分组成,三者深度耦合而非简单堆砌,共同推动RL4LLM技术的发展。

在Async架构方面,ROLL Flash通过细粒度并行与采样-训练解耦两大原则,实现了全链路异步执行。该系统将生成、环境交互、奖励计算与模型训练彻底流水线化,显著提升GPU利用率。实验数据显示,在Agentic任务中最高可获得2.72倍的端到端吞吐提升,在百卡规模下仍保持近乎线性的扩展能力。通过引入异步比机制和集成主流Off-policy算法,异步训练效果能与同步训练相媲美。队列调度、候选生成并行化、环境交互异步化和冗余环境部署四项关键技术共同确保了系统的高效稳定运行。

AsyPPO算法颠覆了传统认知,首次系统论证了评论家的参数规模与其价值估计能力并无必然关联。研究表明,仅需两个小型评论家即可在降低计算资源消耗的同时提升推理性能与训练鲁棒性。该算法通过多样化微型评论家聚合和不确定性感知的策略损失重构两项创新技术,实现了训练稳定性提升、部署轻量化和训练速度加快等多重优势。AsyPPO的提出打破了资源壁垒,使中小研究团队也能高效开展基于PPO的LLM对齐与推理优化研究。

在Attention机制方面,研究团队重新定义了其角色。Attention不仅是语言模型计算的副产品,更是揭示推理内在逻辑的结构化蓝图。通过分析注意力模式,团队发现了模型内部存在的预规划-锚定节奏机制,并据此设计了三种针对关键推理节点的强化学习信用分配策略。实验证明,基于注意力信号的精细化策略优化在多个推理任务上均取得了显著效果,特别是在最具挑战性的任务上表现出最强的性能提升。这种方法将LLM的强化学习从”盲目试错”推向”结构引导”,显著提升了训练效率和模型性能。

「3A」框架的协同作用体现在多个层面:Async架构解决了大规模RL训练的资源利用率问题,AsyPPO提供了轻量高效的算法基础,而Attention机制则实现了精细化的策略优化。这一系列创新不仅提升了RL4LLM的训练效率和模型性能,还增强了模型的可解释性和可控性,为构建下一代智能体系统奠定了坚实基础。团队已开源相关工具链,将进一步推动RL4LLM技术的民主化和广泛应用。

原文和模型

【原文链接】 阅读原文 [ 7174字 | 29分钟 ]

【原文作者】 机器之心

【摘要模型】 deepseek/deepseek-v3-0324

【摘要评分】 ★★★★★