文章摘要

【关 键 词】 视觉分词器、生成模型、开源框架、语义理解、Scaling Law

MiniMax海螺视频团队近期开源了Visual Tokenizer Pre-training(VTP)框架,揭示了视觉分词器(Tokenizer)在图像生成系统中的核心作用。长期以来,业界观察到投入更多算力提升视觉分词器的重建精度,却未能线性转化为生成质量的提升。这一现象被定义为“预训练缩放问题”,即更好的像素级重建精度并不必然带来更高质量的生成效果。

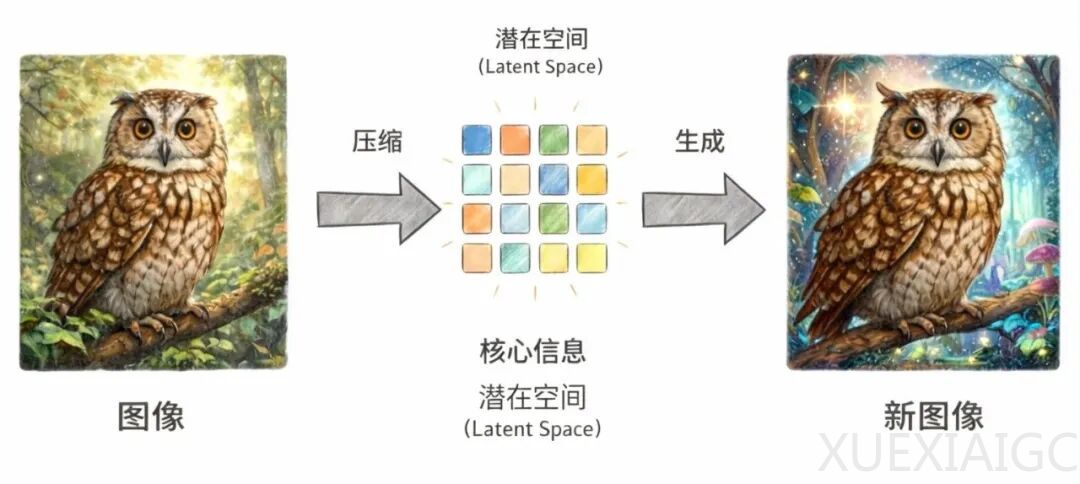

传统两阶段生成框架中,视觉分词器负责将原始图像压缩到潜在空间,再由扩散模型进行生成。尽管Tokenizer的压缩质量直接影响最终输出,但现有方法过度关注局部纹理重建,忽视了高层语义理解。实验数据显示,仅优化重建目标的模型,其生成性能(gFID)会随算力增加趋于饱和甚至下降,而理解能力(Linear Probe)与生成质量呈现显著正相关。

VTP的创新在于将训练目标从单一重建扩展为“理解、重建、生成”的联合优化。通过图文对比学习注入语义对齐能力,结合自监督学习掌握空间结构,同时保留必要的底层细节重建。这种多任务框架使Tokenizer输出的潜在表征同时具备语义结构化表达和生成友好性,零样本分类准确率达78.2%,重建误差(rFID)低至0.36。

更具突破性的是,VTP首次验证了Tokenizer的Scaling Law——生成性能可随预训练计算量持续提升。在相同下游配置下,VTP的算力投入带来65.8%的生成性能增益,而传统方法在1/10算力时即达瓶颈。这一发现打破了“Tokenizer无需扩展”的固有认知,证明其与主模型同样具备scaling潜力。

框架的开源为行业提供了新方向:Tokenizer层面的统一表征学习可能成为理解-生成协同优化的基础。团队强调,当Tokenizer学会用结构化“视觉语言”描述世界时,下游任务无需重复学习底层表达,从而实现更本质的系统级效率提升。目前代码、模型及完整实验数据已公开,相关技术细节可通过论文进一步查阅。

原文和模型

【原文链接】 阅读原文 [ 4092字 | 17分钟 ]

【原文作者】 量子位

【摘要模型】 deepseek/deepseek-v3-0324

【摘要评分】 ★★★★★