文章摘要

【关 键 词】 AI芯片、SRAM技术、HBM存储、英伟达收购、推理优化

英伟达战略性收购AI推理新秀Groq的事件引发了科技界对SRAM与HBM技术路线的深度讨论。这场交易不仅将LPU背后的SRAM技术推向台前,更揭示了AI推理阶段对存储架构的全新需求。传统GPU依赖HBM作为主存储的设计在训练场景表现优异,但在实时推理中暴露出延迟敏感的短板。Groq的创新在于完全抛弃HBM,采用数百MB片上SRAM存放模型权重,其访问延迟仅为HBM的百分之一,带宽高达80TB/s。

SRAM的核心优势体现在物理层级的确定性延迟和能效比。与DRAM需要定时刷新不同,SRAM只要通电就能保持数据稳定,访问延迟稳定在1ns级别。这种特性对自动驾驶、工业控制等零容忍延迟波动的场景至关重要。阿贡国家实验室的测试显示,Groq架构在核聚变反应堆预测任务中的推理速度比NVIDIA A100快600倍。但SRAM的局限性同样明显:在14nm工艺下,SRAM单元面积仅缩小5%,导致大容量SRAM成本呈指数级增长。

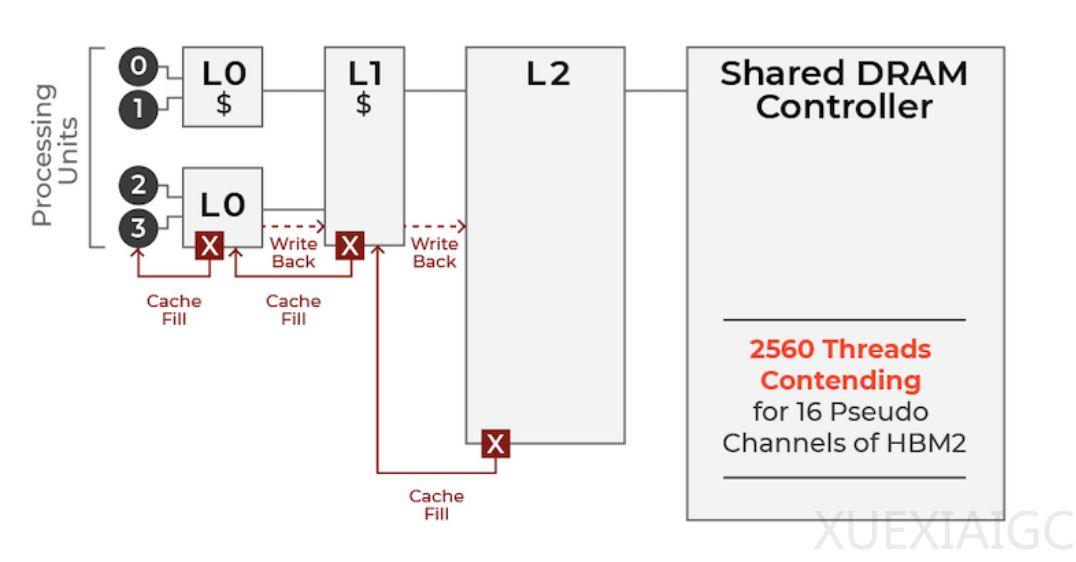

HBM技术当前仍是AI训练不可替代的解决方案。其3D堆叠结构提供数十GB容量和超高顺序带宽,完美匹配GPU的批量计算需求。黄仁勋在CES 2026的回应中指出,若将千亿参数模型完全装入SRAM,需要数百颗芯片并联,电力消耗将成天文数字。英伟达通过收购Groq获取的SRAM技术,实质是补齐极致低延迟推理的拼图,而非替代现有HBM体系。CPX压缩技术与GDDR7的组合,可能在未来形成对HBM成本的有效制衡。

存储技术的层级化演进正在重塑AI芯片架构。训练与推理场景的本质差异催生了”衬衫口袋”与”大型仓库”的协同需求。边缘侧设备更倾向采用SRAM架构实现瞬时响应,而数据中心仍需HBM支撑海量参数。值得注意的是,推理次数通常是训练次数的数十亿倍,这意味着存储架构的能效优化将产生指数级收益。Groq采用的直线线程设计和内存访问解耦技术,通过编译器实现指令级、内存级和数据级三重并行,为单次请求处理提供了新范式。

未来存储技术发展将呈现多维并进格局。SRAM在确定性延迟场景、HBM在通用计算场景、SSD在冷数据存储场景将形成互补生态。黄仁勋强调的架构灵活性观点揭示了行业本质:AI工作负载的多样性决定了没有单一最优解。模型规模的持续膨胀与实时推理的严苛要求,正在推动存储体系从”容量优先”向”分层优化”转型。这场技术演进不仅关乎芯片设计,更将深刻影响从数据中心到终端设备的整个AI基础设施布局。

原文和模型

【原文链接】 阅读原文 [ 3359字 | 14分钟 ]

【原文作者】 半导体行业观察

【摘要模型】 deepseek/deepseek-v3-0324

【摘要评分】 ★★★★★