微软发布Phi-3.5系列模型,性能超越Gemini 1.5 Flash与GPT-4o

文章摘要

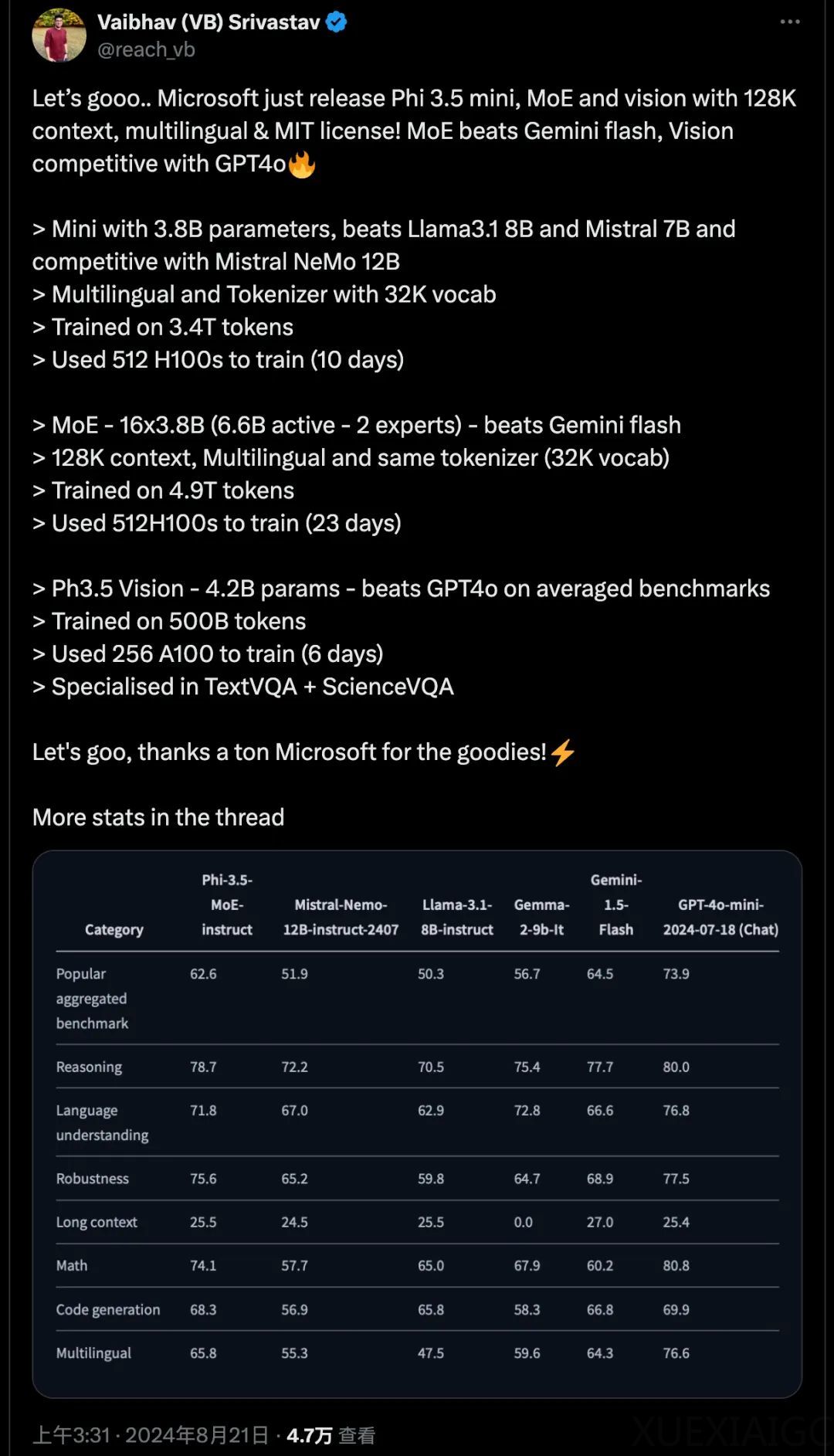

微软公司在大模型领域的最新发展中取得了显著成果,宣布推出了三款全新的Phi-3.5模型,旨在加强其在多语言和多模态人工智能领域的领导地位。这些模型分别是Phi-3.5-mini-instruct、Phi-3.5-MoE-instruct和Phi-3.5-vision-instruct,参数分别为38.2亿、419亿和41.5亿,分别针对基本推理、高级推理和视觉任务设计。

Phi-3.5-mini-instruct是一款轻量级AI模型,专为计算资源受限的环境优化,支持128k的Token上下文长度,适用于代码生成、数学问题求解和逻辑推理等任务。该模型在多语言和多轮对话任务中表现优异,性能接近最先进模型,并在RepoQA基准测试中超越了其他类似大小的模型。

Phi-3.5-MoE(专家混合)模型是微软首次推出的此类模型,采用具有420亿活跃参数的架构,提供可扩展的AI性能以满足苛刻的应用需求。该模型在代码、数学和多语言理解方面表现出色,在RepoQA和5-shot MMLU基准测试中超越了更大的模型。MoE模型的独特架构使其在处理复杂AI任务时保持效率,并能够应对多语言任务。

Phi-3.5-vision-instruct是一款集成了文本和图像处理功能的多模态模型,适合执行图像理解、光学字符识别、图表和表格理解以及视频总结等任务。该模型支持128k的Token上下文长度,能够处理复杂的多帧视觉任务。微软指出,该模型通过使用合成数据集和筛选后的公开数据集进行训练,重点是高质量、推理密集的数据。

这三款Phi-3.5模型均在MIT许可证下发布,体现了微软支持开源社区的承诺。开发人员可以自由使用、修改、合并、发布、分发、再许可或出售这些软件。该许可证还包括免责声明,软件是“按原样”提供的,不提供任何形式的保证。

微软发布的Phi-3.5系列代表了多语言和多模态AI开发的重大进步。通过将这些模型以开源许可证发布,微软使开发者能够将高级的AI能力集成到他们的应用程序中,推动商业和研究领域的创新。这些模型在第三方基准测试中表现出接近最先进模型的性能,在某些情况下甚至击败了谷歌的Gemini 1.5 Flash、Meta的Llama 3.1和OpenAI的GPT-4o等其他AI产品。这样的性能优势,加上宽松的开源许可证,使得微软在社交网络上获得了广泛赞誉。

微软和OpenAI的合作已经取得了成功,但微软并未满足于此,而是继续在大模型领域深耕细作,不断研发和推进。这次发布的Phi-3.5模型系列是微软在多语言和多模态AI领域的最新成果,展示了其在这一领域的领先地位和创新能力。通过提供高性能、易于使用的AI模型,并采用宽松的开源许可证,微软为开发者和研究者提供了强大的工具,以推动AI技术的发展和应用。

原文和模型

【原文链接】 阅读原文 [ 1311字 | 6分钟 ]

【原文作者】 AI大模型实验室

【摘要模型】 moonshot-v1-32k

【摘要评分】 ★★★☆☆