浙江大学研究员彭思达:底层空间感知技术对训练机器人有何作用?丨GAIR 2025

文章摘要

【关 键 词】 机器人、空间感知、计算机视觉、深度学习、行为数据

浙江大学研究员彭思达在GAIR 2025论坛上提出,人类行为数据可作为训练人形机器人的重要资源,通过采集人类日常活动记录,结合空间感知技术解决具身智能领域的数据匮乏问题。其团队聚焦三大核心技术突破:相机定位、深度估计与物体运动估计,旨在构建机器人的通用空间感知能力体系。

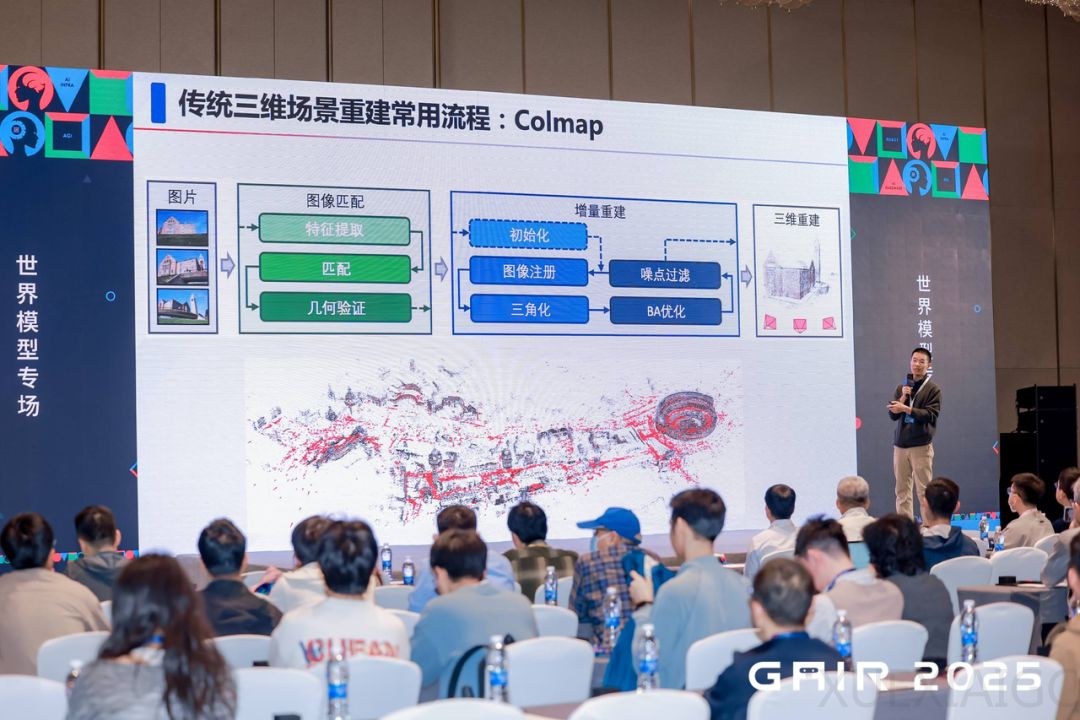

在相机定位领域,传统Colmap方法受限于图像匹配的准确性,尤其在跨模态场景下表现不佳。团队开发的MatchAnything模型通过多模态预训练框架,实现了红外与可见光、CT与MR等异构数据的匹配,并创新性提出Detector-free SfM方法解决多视图匹配问题。针对重建效率瓶颈,Scal3R系统通过”场景记忆”机制在线更新网络权重,使千张规模图像的重建时间从数十小时缩短至秒级,同时保持全局一致性。

深度估计方面,团队发现现有方法普遍存在物体边缘”飞点”缺陷。提出的Pixel-Perfect-Depth方案摒弃VAE压缩环节,直接在像素空间优化,结合语言特征注入使深度估计精度显著提升,单图误差降低至毫米级。针对视频输入场景,通过语义特征提取与时序token叠加,实现了连续帧深度估计的稳定性。后续研发的Prompt Depth Anything引入雷达数据作为提示词,使模型具备绝对深度输出能力,在机器人抓取任务中成功率超越传统LiDAR输入方案。

物体运动估计技术通过三维空间跟踪取得突破。传统二维跟踪方法易受遮挡干扰,团队开发的SpatialTracker将特征反投影至三维空间初始化轨迹,在高速运动(如足球射门)和复杂遮挡(如蝴蝶振翅)场景下,跟踪鲁棒性提升40%以上。该方法为转化人类行为语义轨迹提供了关键技术支撑。

这些技术突破共同构成了机器人理解物理世界的基础设施。相机定位建立空间坐标系,深度估计量化物体距离,运动跟踪捕获动态交互,三者协同形成的空间感知体系,使得利用人类行为数据训练机器人成为可能。实验数据显示,整合新算法的无人机在跨季节环境下的匹配成功率提升67%,自动驾驶场景的三维重建效率提高20倍。当前工作正延伸至医疗影像匹配、工业检测等跨领域应用,相关成果已被CVPR等顶会收录。

原文和模型

【原文链接】 阅读原文 [ 3640字 | 15分钟 ]

【原文作者】 雷峰网

【摘要模型】 deepseek/deepseek-v3-0324

【摘要评分】 ★★★★★