文章摘要

【关 键 词】 多模态、非Transformer、液体神经网络、内存效率、大规模AI

MIT系初创公司Liquid AI推出了一种新型多模态非Transformer模型——液体基础模型LFM,该模型在基准测试中超越了现有的Transformer模型,成为新的SOTA(State of the Art)。LFM模型能够处理视频、音频、文本、时间序列和信号等多种类型的顺序数据,具有三种不同规模的模型:1.3B、3.1B和40.3B,分别适用于资源受限环境、边缘部署和处理复杂任务。

LFM的核心优势在于其液体神经网络(LNN),这种网络在推理过程中可以实时调整,同时保持较低的内存占用和高效的推理能力。LFM-1B在1B类别的公共基准测试中表现突出,成为非GPT架构首次显著超越基于Transformer的模型。LFM-3B在3B参数的模型中取得了第一名,性能甚至优于前代的7B和13B模型。LFM-40B则在模型尺寸和输出质量之间实现了新的平衡,利用12B的激活参数,性能可媲美更大的模型。

Liquid AI的LFM-3B模型在内存效率上显著优于其他模型,仅需16 GB内存,而相比之下,Meta的Llama-3.2-3B模型则需要超过48 GB内存。LFM的内存占用更少,尤其是在处理长输入时,这一点尤为重要。

尽管LFM在多模态能力上表现出色,适合金融服务、生物技术、消费电子等行业的应用,但它在某些任务上并不擅长,如零样本学习的代码任务、精确的数值计算、时效性信息以及人类偏好优化方法。

LFM的架构基于液体神经网络,这种网络的灵感来源于秀丽隐杆线虫的神经结构,即使在训练后也能保持适应性和对变化的鲁棒性。LFM的架构是可控制的,并且具有自适应能力,可以作为各种规模AI的基础。

Liquid AI团队在模型设计上进行了创新,提出了新的算法进展,推进了大规模AI模型的帕累托边界。这些算法增强了模型的知识容量、多步骤推理能力和上下文记忆能力,同时提高了训练和推理的效率。

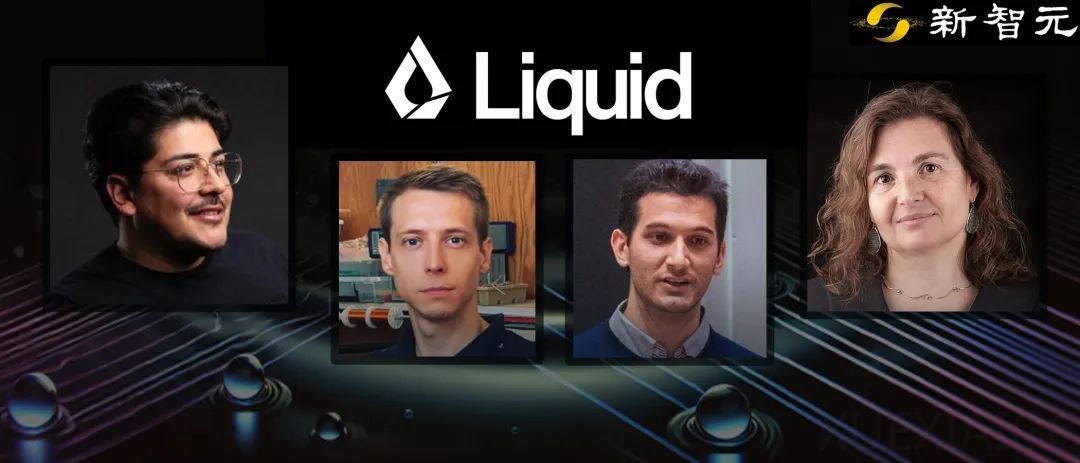

团队成员包括Ramin Hasani(CEO)、Mathias Lechner(CTO)、Alexander Amini(CSO)和Daniela Rus,他们在机器学习、鲁棒性建模、自主智能体的安全决策等领域有着丰富的研究经验。

LFM模型目前可以通过Liquid的推理Playground、Lambda Chat或Perplexity AI进行体验,但并非开源。Liquid AI的目标是在每个规模上创造同类最佳的系统,通过LFM模型,他们已经在性能和操作效率上取得了显著的成果。

原文和模型

【原文链接】 阅读原文 [ 4300字 | 18分钟 ]

【原文作者】 新智元

【摘要模型】 moonshot-v1-32k

【摘要评分】 ★★★★★