文章摘要

【关 键 词】 AI芯片、Cerebras、推理市场、性能提升、行业标准

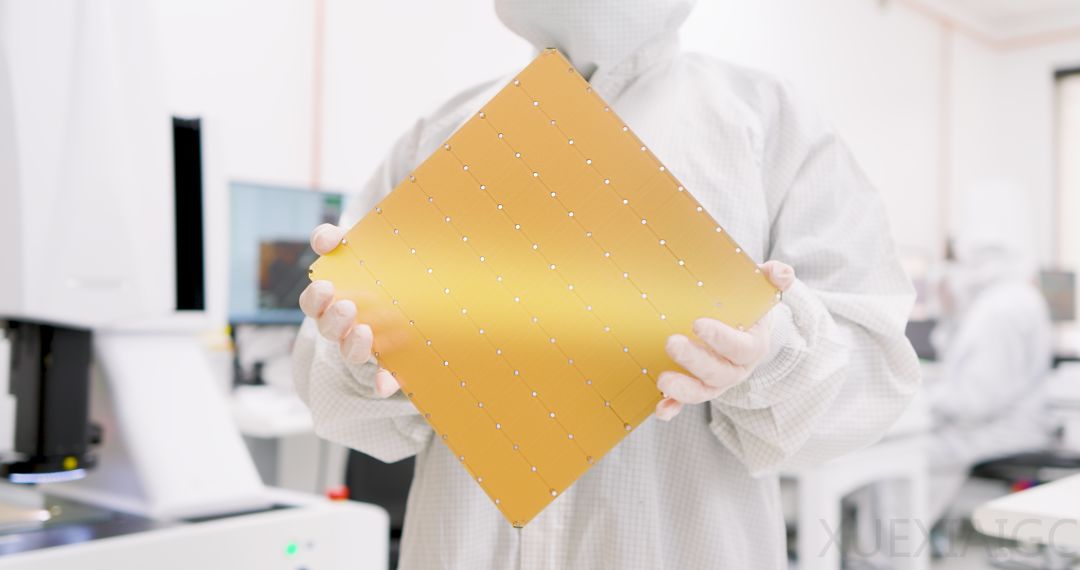

Cerebras Systems,一家以挑战英伟达在AI芯片市场地位为目标的公司,于今年年初推出了WSE-3 AI芯片,专为训练大型AI模型而设计。这款基于5nm工艺、拥有4万亿晶体管的芯片为Cerebras CS-3 AI超级计算机提供动力,通过900,000个AI优化计算核心实现125千万亿次的峰值AI性能,代表了台积电目前能生产的最大尺寸。

Cerebras的CEO Andrew Feldman对英伟达的挑战态度由来已久,而公司现在正将焦点从AI训练市场转向推理市场。在现代生成式AI工作负载中,推理性能通常受内存带宽限制,而非计算能力。Cerebras的首款推理产品基于WSE-3加速器,通过使用44GB的SRAM和21PBps的带宽,打破了这一限制,相比之下,单个Nvidia H200的HBM3e带宽仅为4.8TBps。

Feldman强调,使用SRAM的推理产品在运行Llama 3.1 8B模型时,每秒能生成超过1800个token,而性能最高的H100实例每秒最多只能生成242个token。Cerebras声称,在运行700亿参数版本的Llama 3.1时,其AI推理服务每秒可处理450个token,相比之下,H100的最佳速度为每秒128个token。Feldman认为,这种性能的提升将为AI的采用开辟新机会,类似于宽带的崛起。

Cerebras的AI推理服务通过将模型的所有层直接存储在芯片上,实现了快速响应。这种设计减少了数据在硬件内部的传输距离,提高了处理速度。Artificial Analysis Inc.验证了Cerebras的性能水平,认为其推理服务树立了新的行业标准,且价格具有竞争力,特别适合需要实时或大容量处理的AI应用。

Cerebras的推理服务使用了与传统GPU不同的架构,将计算和内存结合在一个单元中,允许更快的数据访问和处理。这种设计使得Cerebras在推理性能上可能达到市场上其他产品的10倍。尽管Cerebras主要关注AI训练,但其WSE-3芯片和CS-3系统同样适用于推理任务,通过扩展编译器功能,实现了在芯片上放置多层的能力。

Cerebras的推理服务还提供了与OpenAI兼容的API,使开发人员能够轻松集成其推理产品。此外,Cerebras计划支持更多模型,包括4050亿参数版本、Mistral Large 2等,并继续为特定客户提供内部部署系统。

尽管Cerebras的WSE架构需要对软件进行调整或重写以充分利用其功能,但公司通过支持PyTorch等高级框架,降低了开发人员的学习曲线。Cerebras的推理服务提供了易于使用的API,使新进入者能够绕过CUDA的复杂性,实现顶级性能,这符合行业向开放标准的转变趋势。

Cerebras的推理服务不仅对Groq构成挑战,后者也采用了依赖SRAM的架构,但SRAM密度较低,需要连接更多加速器来支持大型模型。Cerebras在性能和成本上均显示出优势,尽管支持的模型范围有限,但公司计划扩展其支持范围。总体来看,Cerebras的AI推理服务在性能、成本和易用性方面均展现出强大的竞争力,预示着AI推理市场的新变革。

原文和模型

【原文链接】 阅读原文 [ 4149字 | 17分钟 ]

【原文作者】 半导体行业观察

【摘要模型】 moonshot-v1-32k

【摘要评分】 ★★★★★