文章摘要

【关 键 词】 浪潮信息、源2.0-M32、性价比高、算力效率、开源免费

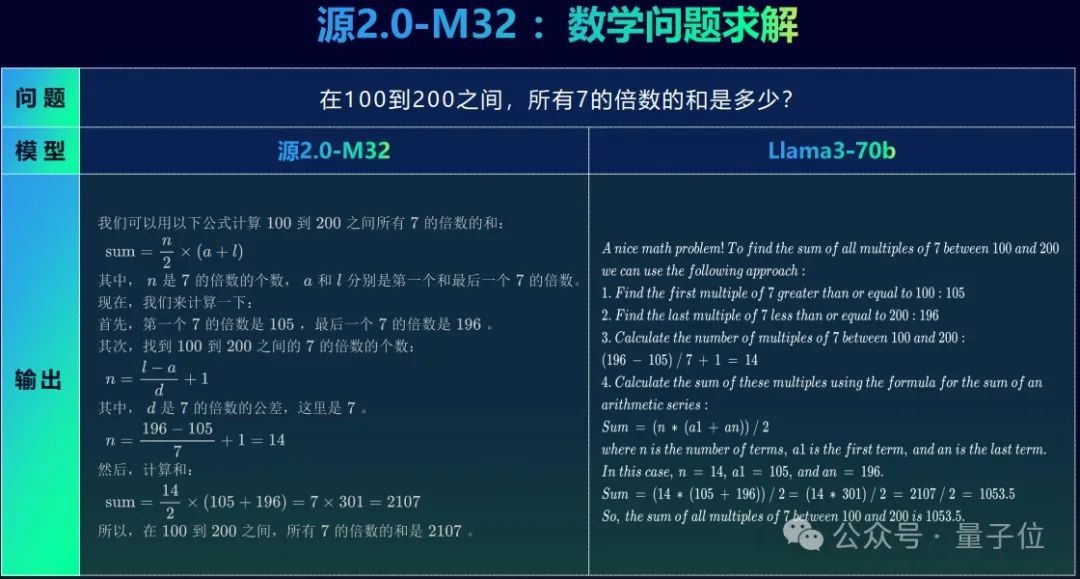

浪潮信息推出的源2.0-M32模型,采用MoE架构,仅需5.28%的算力消耗,就能在精度上对标Llama 3。这一模型的总参数量为40B,激活参数量为3.7B,展现了卓越的性价比和高效的模算效率。在训练、推理和微调过程中,源2.0-M32大幅降低了资源消耗,仅为同类模型的1/19,甚至能在笔记本电脑上运行。

源2.0-M32的设计理念围绕算法、算力、数据的全面创新。浪潮信息选择了32个专家的MoE结构,并创新使用Attention Router门控网络,优化专家间的协同效果。此外,模型还运用了局部注意力过滤增强(LFA)机制,并在数据层面大幅扩展,使用了2万亿token的数据进行训练,其中包括大量代码和合成数据。

浪潮信息的这一模型不仅性能对标业界领先模型,还坚持开源,商业使用免费,无需授权。这种开源策略,加之模型的高效性能,旨在降低大模型的使用门槛,加速产业智能化升级。

在算力层面,浪潮信息凭借其作为专业算力供应商的地位,以及内部丰富的应用场景,实现了高效算力的运用和模型迭代。从源1.0到源2.0-M32,浪潮信息始终坚持算法和架构的创新,并通过开源活动持续受益,这也体现了其致力于基础大模型研发的承诺。开发者可通过GitHub、Huggingface、ModelScope和Wisemodel等平台访问源2.0-M32模型。

原文和模型

【原文链接】 阅读原文 [ 3368字 | 14分钟 ]

【原文作者】 量子位

【摘要模型】 glm-4

【摘要评分】 ★★★★☆

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...